知名科技博主:苹果犯了错

神译局是36氪旗下编译团队,关注科技、商业、职场、生活等领域,重点介绍国外的新技术、新观点、新风向。

编者按:隐私一致是苹果强调自己跟其他人不一样的优势。但苹果最近公布的“儿童安全”功能却遭到了多家组织与各方面专家学者以及消费者的抵制。他们签署公开信,谴责苹果破坏来用户隐私与端到端加密的机制。苹果保护儿童有错吗?有没有更好的解决方案?知名科技博主Ben Thompson提出了自己的看法。原文发表在其个人博客上,标题是:Apple’s Mistake

划重点:

Facebook提交的CSAM报告要比苹果提交的多得多

美国的法律明确了提供商有报告CSAM的义务,但也界定了跟隐私保护的关系

苹果的儿童保护功能让苹果在设备侧具备了对用户内容进行扫描的能力

iPhone从根本上应该得到安全保证,而iCloud备份受法律约束是一个合理的妥协

但苹果的做法恰恰相反,这就是苹果犯下的错误:背叛了初心

2009 年 8 月,也就是 iPhone 3GS 发布两个月后,门口来了野蛮人;来自The Online Photographer:

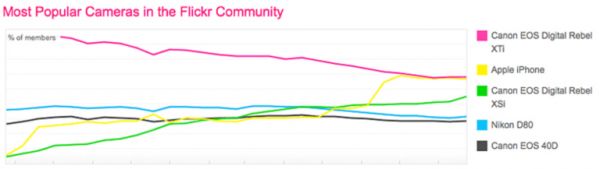

flickr.com,这家领先的照片共享网站列出了自家会员使用的相机的受欢迎程度。最近,苹果 的iPhone 已经开始跟佳能XTi 并列第一。此外,flickr在其“Camera Finder”页面上还指出,它只能检测当时使用的大约 2/3的相机,因此,手机摄像头在这份调查的代表性不足。唉。

当 iPhone 成为 Flickr 上最受欢迎的相机时, iPhone 不仅会继续成为 Flickr 榜单上的头号相机,而且还为Instagram的诞生创造了条件,对于衡量iPhone的影响力来说,这一点要有吸引力得多。instagram 这个照片共享网络无疑令 Flickr 黯然失色,就像谷歌超越了雅虎(当然,雅虎也是Flickr的拥有者)一样。Instagram很快就被 Facebook 收购,而Facebook 本身也因为 iPhone 相机而受益匪浅;随身携带着一台不断改进的优质相机,再加上不间断的连接性,让照片从特殊场合的纪念照片变成了Snap 首席执行官埃文·斯皮格尔(Evan Spiegel)所谓的“我们日常生活沟通交流的一部分”。

当 iPhone 成为 Flickr 上最受欢迎的相机时, iPhone 不仅会继续成为 Flickr 榜单上的头号相机,而且还为Instagram的诞生创造了条件,对于衡量iPhone的影响力来说,这一点要有吸引力得多。instagram 这个照片共享网络无疑令 Flickr 黯然失色,就像谷歌超越了雅虎(当然,雅虎也是Flickr的拥有者)一样。Instagram很快就被 Facebook 收购,而Facebook 本身也因为 iPhone 相机而受益匪浅;随身携带着一台不断改进的优质相机,再加上不间断的连接性,让照片从特殊场合的纪念照片变成了Snap 首席执行官埃文·斯皮格尔(Evan Spiegel)所谓的“我们日常生活沟通交流的一部分”。 问题来了。为什么像 Facebook 这样主要在移动设备(也就是 Android 或iOS )上面使用的公司在2020 年提交的儿童性虐待材料(CSAM)报告达到2030 万份,而苹果却仅仅提交了265 份?毕竟,几乎可以肯定的是,智能手机上的照片要比发布到社交网络上的多——前者在很大程度上是后者的超集。

《美国法典》第18篇第2258A条

《美国法典》第18篇第2258A条是关于电子通信服务提供者和远程计算机服务提供者的报告要求。此条对于网络服务提供者报告儿童色情材料作出详尽和专门的规定,规定了报告义务的内容、义务的履行方式、未履行义务所承担的刑事责任。

规定指出,电子通信服务提供者和远程计算机服务提供者明知自己保管或控制范围内的信息中有违反第2251条(儿童性虐待),第2251A条(出卖或收买儿童),第2252(与未成年人性虐待有关材料的特定活动),第2252A条(与组成或包含儿童色情材料相关的特定活动),第2252B(互联网上误导性域名),2260(生产未成年人的露骨宣扬性的材料并进口到美国),第1466A条(对儿童性虐待的可视资料)的规定,存在涉及儿童色情的事实或情况,需要尽快向国家失踪和被虐待儿童中心报告。

电子通信服务提供者或者远程计算机服务提供者明知且故意不履行报告义务的将承担法律责任:(1)如果是一开始就知道并且故意不报告的,处15万美元以下的罚金;(2)如果是第二次或其后知道并且故意不报告的,处30万美元以下的罚金。

不过,法典也明确了跟隐私保护的关系。法典规定,本节中的任何内容均不得解释为要求提供者监控该提供商的任何用户、订户或客户,或者前述任何人的任何通信内容,或者搜索、筛选、扫描所述事实或情况。

这说明了为什么 Facebook 和苹果以往报告的数字会有这么大的不同:这不是因为 Facebook 上的 CSAM 就要比苹果设备上存在的 CSAM 多,而是因为 Facebook 会扫描发送到自己的服务以及通过自己的服务发送的所有图像,而苹果不会查看你手机或云端的内容。知道这一点后,数字才更有意义:Facebook 在报告自己的发现,而苹果,就像相关条款所说明的那样,在保护隐私,根本就没看里面的图像。

苹果的儿童保护

上周,苹果在自家网站上开辟了一个叫做“扩大对儿童的保护”的特别页面:

在苹果这里,我们的目标是创造为大家赋权,丰富大家生活的技术,同时还要帮助人们保持安全。我们希望帮助保护儿童免受利用通信工具招募和虐待他们的掠夺者的侵害,并限制儿童性虐待材料 (CSAM) 的传播。

苹果正在跟儿童安全专家合作,在三个领域引入新的儿童安全功能。首先,新的交流工具可让父母在帮助孩子进行在线交流方面发挥更明智的作用。Messages app会利用设备上的机器学习对敏感内容做出告警,同时保证苹果不能读取私人通信。

其次,iOS和iPadOS会运用新的密码学应用来帮助限制 CSAM 的在线传播,同时还会考虑到用户的隐私。CSAM 检测可帮助苹果向执法部门提供iCloud Photos里面有关CSAM 集的宝贵信息。

最后,Siri和Search的更新可为父母和孩子提供更多信息,并在他们遇到不安全情况时提供帮助。当用户尝试搜索 CSAM 相关主题时,Siri和搜索也会进行干预。

Daring Fireball 的John Gruber对实际上截然不同的三点举措做出了很好的诠释;不过,这三点的统一之处在于,它们继续保持了苹果做法与Facebook做法的不同。那就是苹果扫描的是设备上的内容,而 Facebook的则在云端进行。苹果一再强调,这确保了苹果没法访问你的内容。来自“Messages的通信安全”:

Messages 使用设备上的机器学习来分析图像附件,并确定照片是否包含色情内容。功能在设计上旨在让苹果无法访问这些消息。

来自“CSAM检测”:

苹果检测已知 CSAM 的方法在设计时考虑了用户的隐私。这套系统不是扫描云端的图像,而是使用 NCMEC 及其他儿童安全组织提供的已知 CSAM 图像哈希数据库来对设备上的内容进行匹配……在防止已知CSAM扩散方面,这项创新技术可让苹果向 NCMEC 和执法部门提供有价值且可操作的信息。这样做的同时,相对于现有的技术我们还提供了显著的隐私优势,因为苹果只有在用户的iCloud Photos帐户里面含有一组已知的 CSAM 时才会去了解用户的照片。而且即使在这些情况下,苹果也只会去了解跟已知CSAM匹配的图像。

苹果的做法可以用三种方式去思考:理想结果、最坏结果以及可能的驱动因素。

能力与政策

苹果的理想结果让很多看似棘手的问题得到了解决。一方面,CSAM 很可怕,但苹果没有采取任何措施;另一方面,该公司有着一个长期的承诺,那就是要不断增加加密的分量,而且最好是端到端的那种。苹果的系统,如果完全按照设计运作的话,是可以鱼与熊掌兼得的:苹果不仅可以为Messages 保留端到端加密,还可以把这种能力补充到iCloud Photos(目前还没有做端到端加密),知道它不仅要报告 CSAM,还要帮助父母照顾他们的孩子,让你可以安心。而且,从商业角度来看,这意味着苹果可以继续不用像 Facebook 这样的公司那些对信任和安全团队进行大规模的投资;问题交给算法处理就行了。

当然了,这就是问题所在:算法是苹果控制的,包括要查找的内容、可能存在可能不存在的错误,还有输入,在 CSAM 扫描的情况下,输入是来自 NCMEC 的数据库。苹果当然努力想要成为一家用户信任的公司,但我们已经知道这种信任并不是无处不在。

根本问题——也是我认为苹果犯错的第一个原因——是能力与政策之间存在实质性的差异。在 2016 年的圣贝纳迪诺案当中,支持苹果公司的最有力论据之一是,这家公司甚至都没有办法打开有问题的 iPhone,而建立这种能力会让面对大量在性质上远没那么紧迫的请求,并削弱公司抵抗外国政府的能力。不过,在现在这种情况下,苹果正在构建自己的能力,唯一阻碍公司的是政策。

再说一次,苹果的政策并不是唯一重要的政策:英国和欧盟都在推进要求在线服务公司主动寻找和报告 CSAM 的法案。事实上,如果这是苹果此举背后最重要的因素的话,我也不会感到惊讶:这家公司不想放弃端到端加密——甚至可能想进一步扩展它——这使得在设备侧扫描成为满足各国政府的唯一途径。

云与设备

我认为苹果的难题还有另一个解决方案;令人沮丧的是,从我的角度来看,我认为这家公司基本已经具备了。想想看现状吧:早在 2020 年时,路透社就曾报道称,应 FBI 的要求,苹果决定不对iCloud的备份进行加密:

六位知情人士告诉路透社,苹果公司放弃了让iPhone用户完全加密公司iCloud服务中其设备数据备份的计划,此前美国联邦调查局(FBI)抱怨此举将损害调查。这家巨头的态度相对于2年前的逆转此前并未有过报道。这表明,苹果公司尽管愿意在与政府的备受瞩目的法律纠纷中采取更强硬的立场,并自称是其客户信息的捍卫者,但仍愿意为美国执法和情报机构提供帮助。

这对 Apple 的安全声明会产生若干重大影响,这就是为什么今年早些时候我会认为iMessage在安全性方面比不上Signal、WhatsApp 、Telegram 以及 Facebook Messenger的原因所在:

iMessage默认对消息进行端到端的加密;但是,如果你选择了iCloud备份,那么苹果(拥有iCloud备份的密钥)就可以访问你的消息,引申而言的话,拿到批准令的执法部门可以也可以访问。但是,跟WhatsApp不同的是,它默认是处于开启状态,而且没法在细粒度的层面上关闭。

这一警告几乎适用 iPhone 上的一切:如果你向没完没了的登录iCloud提示及其默认的备份解决方案屈服的话,苹果就可以访问你的数据,引申而言的话,拿到批准令的执法部门可以也可以访问。其实我觉得这是说得过去的!当路透社的报道出来时,我是这么写的:

回到我上面所说的:坚定的行为者将可以访问加密和面部识别。任何试图争辩说这些技术是否应该存在的人都没有活在现实里。因此,我们应该注意确保好的行为人也可以使用这些技术。这意味着不要让它们成为非法的。

其次,应该认真对待对执法的需求以及互联网激进化性质的合理社会关切。这意味着在把加密设置为默认值上我们应该考虑得非常仔细……这种原则上也是各退了一步:用户有代理权——他们可以确保自己所做的一切都是加密的——而完全隐私也可以有,但不是默认提供的。

实际上,我认为苹果在实现这种平衡方面做得非常出色。就 iPhone 本身而言,苹果是唯一能保证其真正安全的实体。没人可以建立自己的安全飞地,这是 iPhone 安全的根基。因此,他们这么做是正确的:每个人都可以使用加密。

这样的话就可以建立一个完全安全的环境:只用加密通信,计算机也只用加密备份,并且用基于硬件的身份验证来保护等。而采用稍微简单一点的做法——如用iCloud备份、Facebook 来进行消息传递等——则意味着会存在一定程度的脆弱性,不要忘记,有时利用这种脆弱性会存在合理性。执法部门可以获得对这些备份或聊天记录的授权,就像他们可以安装窃听器一样。

同样地,这不会阻止那些坚定的坏的行为者,但正如我所指出的那样,没有一样可以阻止他们。问题是其它的人,那些被最糟糕的社区卷入的人,以及那些犯下合法的罪行的人:他们的默认设置应该是什么?

我对 Facebook计划把加密作为Facebook Messenger会话的默认选项也提出了类似的论点,我反对,尽管我支持提供加密选项:我不反对加密,而且其实我强烈反对强制后门。每个用户都应该能够锁定自己的设备和通信;坏的行为者肯定会。与此同时,对默认设置以及什么是用户最简单的路径提出看法是公平的:我认为 iPhone 从根本上得到安全保证,而iCloud备份受法律约束是一个合理的妥协。

然而,在这种情况下,苹果的选择却是朝着相反的方向发展:他们没有把CSAM 扫描的能力添加到自己所拥有和运营的云端的iCloud Photos,而是把这种能力放进你和我拥有和控制的手机里,而在这件事情上面我们任何人都没有发言权。是,你是可以关闭iCloud Photos以禁止苹果对其进行扫描,但那是一项政策决定;进入用户手机的能力现在已经具备了,而iPhone 用户没法摆脱这种能力。

对于我开始所说的“Flickr 问题”,一个更好的解决方案是认识到正确的比较方式不是 iPhone跟Facebook比,而是 Facebook跟iCloud比。个人的设备应该是个人的财产,个人应该拥有其所有权,可以决定对隐私的处理;与此同时,云服务也是其所有者的财产,同时需要承担社会责任和守法的所有期望。令人失望的是,如此执着于隐私愿景的苹果,最终却背叛了让用户控制的理念:让用户相信,自己的设备真正属于自己。

译者:boxi。

相关推荐

知名科技博主:苹果犯了错

知名科技博主:苹果应用商店之争(下)

知名科技博主:苹果应用商店之争(上)

知名科技博主Ben Thompson:信息的定义

知名科技博主:Facebook的平台机遇

知名科技博主:iPad诞生10周年,却变成了一出悲剧

知名科技博主Ben Thompson:互联网竞争的一个监管框架

知名科技博主Ben Thompson:谷歌与环境计算

知名科技博主Ben Thompson :苹果 OS X 系统的终结

知名科技博主 Ben Thompson:一个时代的早期结束了

网址: 知名科技博主:苹果犯了错 http://m.xishuta.com/newsview48778.html