跨物种脑-脑连接:听障人士通过豚鼠大脑听到了声音

本文来自微信公众号“量子位”(ID:QbitAI),作者:明敏,36氪经授权发布。

想知道你的宠物每天都在想什么吗?

现在,这事真的有可能实现了。

最近《Nature》发表的一篇研究中,科学家们成功把人类和豚鼠的大脑连接在了一起。

他们发现,人类可以识别豚鼠脑内的语音信息,识别率最高可达70%。

也就是说,人类和豚鼠之间实现了脑-脑传输信息(brain-to-brain interface)。

这不禁让人想开个脑洞:

或许有一天,我们真的能跨物种脑电波交流了!

用豚鼠大脑听到声音

所以,人类识别豚鼠脑内的信息,是怎么做到的?

首先,科学家们选择让人类听到所传输的信息。

为了能够实现不同物种大脑之间的信息传输,科学家们选择把豚鼠的大脑看做一个可以处理信息的机器,即“编码器”。

研究人员在豚鼠的下丘脑植入多通道微电极,用它来记录豚鼠的神经反应模式。

试验过程中,他们给豚鼠听一个单词,豚鼠的听觉系统会做出相应的反应,多通道微电极把这一过程中产生的信号传输给人类。

而人类想要接收到信号,则需要用到人工耳蜗,可以将它理解为一个解码器。

△人工耳蜗

人工耳蜗本身可以把声音转化为一定形式的电信号,通过植入人体内的电极系统刺激听觉神经,从而恢复或重建人的听觉功能。

在这项试验中,研究人员只需要把电信号输送给人工耳蜗,人体内的电极系统用这些信号刺激听觉神经,然后人就能听懂豚鼠所听到的单词了。

具体效果如何呢?

研究人员主要设置了两种测试:

第一项测试中,受试者并不知道自己听的是一个单词,他只需要描述出所听到声音的长度、节奏和响度;

第二项测试,则是让受试者在给出的4个单词中,选出认为自己听到的那一个。

判断测试情况好坏主要也有两个标准:

第一是测试对象是否可以选出正确的单词;

第二则是不考虑所选单词的对错,只要测试对象能判断出声音信号来自于同一个单词即可。

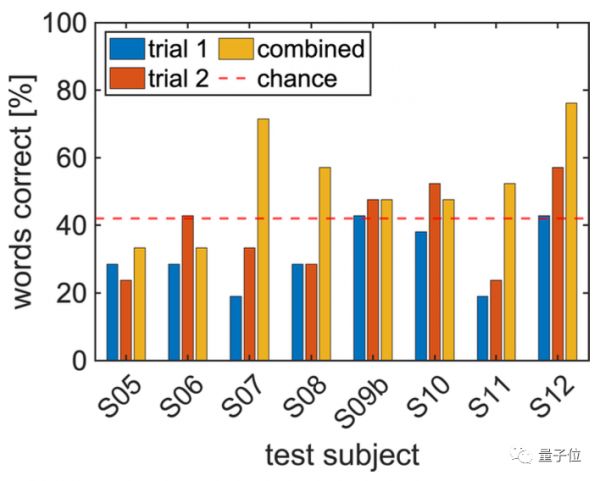

△第二项测试总结果

△第二项测试中的21组测试情况

总的来说,受试者在选择单词的测试中的表现更好:

他们选择出正确词汇的概率在34.8%;

能够识别出同一个单词的概率有53.6%,最高识别率达到了70%。

而在描述测试中,在告知测试对象所听到的声音信号来自于一个单词后,8位受试者中有6人可以在50%以上的测试中识别出相同单词的信号。

虽然成功率不是非常高,但是这样的结果也足以让人感到兴奋了。

研究人员也表明,成功率不高和试验条件有一定关系。

比如豚鼠下丘脑对低频率声音的记录非常有限,500赫兹以下的信号几乎没有被记录。

也就是说一些可以区别单词的关键频率,可能没有被记录到。

上图中,图(c)是受试者大脑接收信号后的神经元光栅图,从中可以看出,受试者接收的最低频率为500赫兹。

以及该研究中的测试对象均为人工耳蜗的使用者,他们的听觉系统已经受损,神经也会出现相应地退化,所以这也会影响他们判读声音信号的准确性。

One More Thing

如此赛博朋克的研究,也让网友们开了脑洞,有人就激动地表示:

我迫不及待想知道我的狗子每天在想什么!

我一定会又痴迷又害怕。

不过这项研究可真不是为了让你能知道自家狗子脑子里想啥的。

本质上,它更多是为了探索新的声音编码方式。

科学家们可以通过研究动物编码声音信息的方式,来开发新的语音编码方式,进一步提升人工耳蜗在噪音感知、音乐编码等方面的性能,为听障人群提供更好的体验。

该研究的通讯作者为西北大学范伯格医学院的Alan G. Micco博士,目前他是一名耳鼻喉科医生,主要研究领域为人工耳蜗、听神经瘤。

论文地址:https://www.nature.com/articles/s41598-021-90823-1#Sec9

参考链接:https://news.ycombinator.com/item?id=27491721

相关推荐

跨物种脑-脑连接:听障人士通过豚鼠大脑听到了声音

为侵入性脑机接口瑟瑟发抖?别怕,大脑可以被“声控”了

MIT脑洞研究:只听6秒语音,AI就知道你长什么样

用牙齿听声音?「声佗医疗」自研牙骨传导听力系统

Cognixion ONE:为什么要给脑机接口加上AR界面

智能助听趋势来临,「聆通科技」推出可当助听器用的智能助听APP

脑机接口,还远谈不上机器控制思想

马斯克的“脑机接口”,能彻底根除残疾吗?

类脑智能,迈向通用人工智能新可能?

马斯克带小猪演示脑机接口?脑机之难,难在如何重返人间

网址: 跨物种脑-脑连接:听障人士通过豚鼠大脑听到了声音 http://m.xishuta.com/newsview45515.html