他们让GPT-4看起来像个流氓

当地时间3月4日,Anthropic发布了最新的Claude 3模型系列,包括Claude 3 Opus、Sonnet和Haiku三个模型,其中Claude 3 Opus在多个测试数据集中全面超过了GPT-4。

Anthropic是一家由 OpenAI 前成员Daniela Amodei、Dario Amodei和Jared Kaplan共同创立的美国人工智能(AI)初创公司,专注于开发通用 AI 系统和大型语言模型。

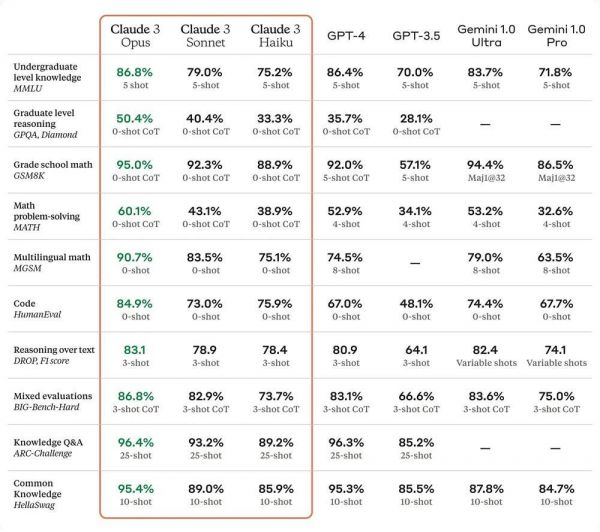

Claude 3 Haiku、Sonnet和Opus三款模型的能力和成本依次递增,推理速度依次递减。Claude 3 Opus性能最强,相对的输出成本最高和输出时间最长,Claude 3 Opus模型在数学、编程、多语言理解和视觉等多项基准测试中超越了GPT-4和Gemini 1.0 Ultra。

与GPT-4相比,Claude 3 Opus在多个测试数据集中全面超过了GPT-4。

Anthropic在Claude 3系列模型中首次放出了多模态能力,用户可以上传各类非结构化数据如照片、图表等供AI分析。这三个模型均支持200K token的长上下文窗口,并向特定客户开放超过100万token的上下文输入能力。

不过,Claude 3模型的定价也高于GPT-4。能力最强的Claude 3 Opus比GPT-4 Turbo贵得多:GPT-4 Turbo每百万token输入价格为10美元,输出价格为30美元,Claude 3 Opus每百万token输入5美元,输出75 美元。

Claude 3的定价

目前Claude 3 Haiku 尚未推送,Sonnet已经开放在Claude的官网上可以免费试用,Opus也已经上线,不过要体验Opus需要花每月20美元(不含税)订阅Claude Pro。相对于ChatGPT,目前Claude的全系产品均不能直接链接互联网查询资料。

安全第一

“安全、稳定”一直被认为是Claude的一大特点。

Anthropic开发了所谓的“宪法AI”技术,旨在将一系列原则赋予模型,以引导模型产生符合这些原则的文本,例如非有害、有益的内容。这种方法旨在使Claude 2的行为更易于理解和调整,尽管公司承认在预测模型在所有情况下的行为方面仍面临挑战。

Claude 2的另一个重点是降低模型产生有害、有偏见或不准确回应的概率。比如,与Claude 1.3相比,Claude 2在内部评估中在给出“无害”回应方面表现得“两倍”更好。但是,这种改进的具体含义并未详细说明,例如是指两倍不太可能回应带有性别歧视或种族歧视的内容,还是两倍不太可能支持暴力或自残等。

由此,Claude模型曾被质疑“道德标准过高”。

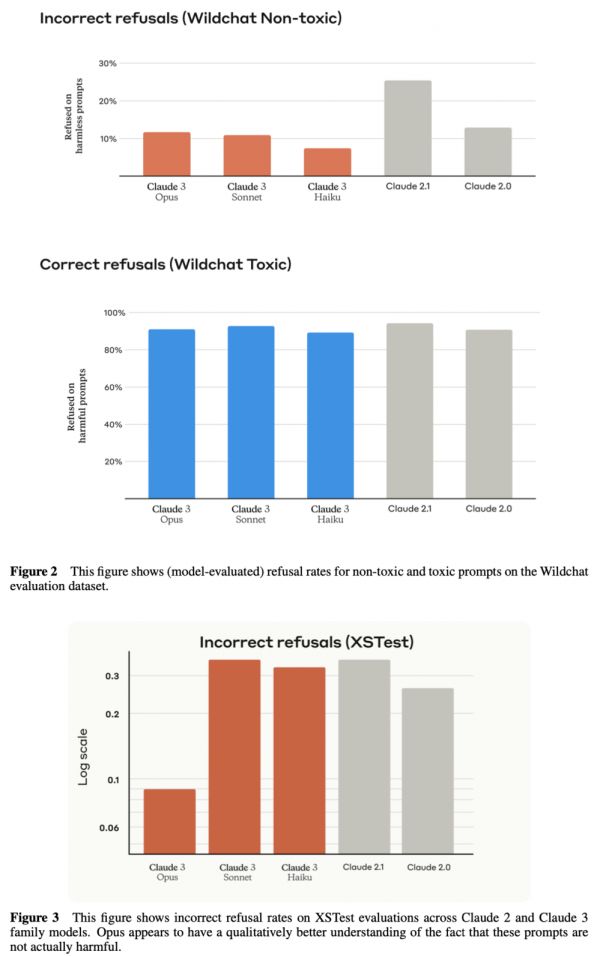

此次发布的Claude 3,在安全性和伦理性方面也进行了改进,包括对有害内容的更好管理和对有益行为的支持,同时减少了对良性提示的拒绝反应。

在训练数据方面Anthropic也格外小心,尽量规避可能的风险。

Claude 3的训练数据来自2023年8月之前公开可获得的互联网信息、第三方提供的非公开数据、数据标注服务和付费合同工提供的数据以及Anthropic专门制作的数据集上训练的。Anthropic采用了多种数据清洗和过滤方法,包括去重和分类。值得注意的是,Claude 3的模型系列没有使用任何用户或客户提交给我们的用户提示或输出数据进行训练,包括免费用户、Claude Pro用户和API客户。

在获取通过爬取公共网页的数据时,Anthropic遵循行业实践,尊重网站运营者通过robots.txt指令和其他信号用来指示是否允许爬取其网站内容的做法。根据Anthropic的政策,其爬虫不会访问受密码保护或需要登录的页面,也不会绕过CAPTCHA控制。

Anthropic对所使用的数据进行了尽职调查,并以透明的方式运营其爬虫系统,这意味着网站运营者可以轻松识别Anthropic的访问并向Anthropic表达他们的偏好。

OpenAI的尴尬处境

Claude“过于安全”的属性,也成了OpenAI的压力。

Claude发布前月余,业界一直有传闻认为,OpenAI将在Claude 3发布之际,迅速跟进发布最新的GPT-4.5(5),或是秘密研发的Q*模型。

不过就在2月29日,马斯克突然对OpenAI提起诉讼,指控OpenAI首席执行官Sam Altman为了追求商业利益,违背了OpenAI“确保AI造福人类”的非盈利性初衷。马斯克要求法院强制OpenAI回归开源,并阻止公司及其创始人以及微软等背后支持者从中获利。

在此之前OpenAI在AGI研发方面就一直饱受质疑,人们对“巨型”AI模型和AGI安全性的担忧与日俱增,一些人甚至认为OpenAI及其他AI大模型公司应该暂时停止研发,等待相关法律、监管制度的逐步健全。

此番全新发布的Claude 3,在模型能力方面继续主打安全、稳定。在Claude 3的衬托之下,如果OpenAI此时发布新模型,能力强则很可能在安全方面刺激监管和舆论敏感的神经,而能力弱,则自然会影响“大模型之王”的形象。

马斯克的突然袭击,似乎搞得OpenAI有点左右为难。Sam Altman如今也不得不把注意力从产品、模型中抽出来,转而关注当下舆论焦点的AI安全问题。

正在发大火箭的马斯克还特意跑来Anthropic点了个赞

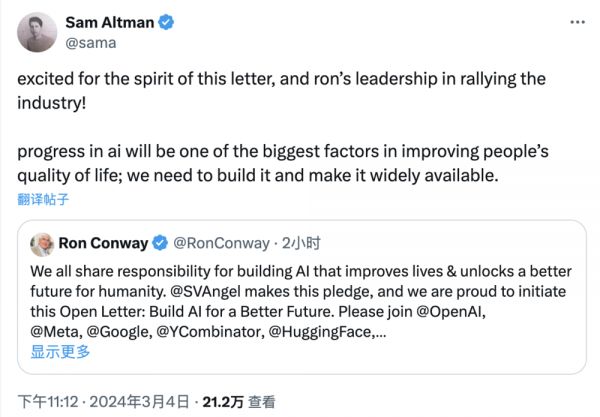

就在Claude 3发布几分钟后,Sam Altman也发布了一条X推文,但他的推文却与AI大模型技术和产品无关,而是关于一封公开信。

Sam Altman推文

风险投资家 Ron Conway 和他的公司 SV Angel 发起了一场名为:Build AI for a Better Future(构建人工智能,共创美好未来)的联名公开信活动,旨在强调“最大限度地发挥人工智能的好处并减轻风险”对社会的“集体责任”。OpenAI、Google、Meta、Y Combinator等科技公司、投资机构参与并签署了这份联名公开信。

目前,关于GPT-4.5(5)和Q*的猜测仍未停止,而OpenAI近期是否真的会发布新模型,让我们拭目以待。

GPT-4和Claude谁强?

“跑分”战胜了GPT-4,但具体模型能力方面,Claude 3和GPT-4的差别到底在哪呢?

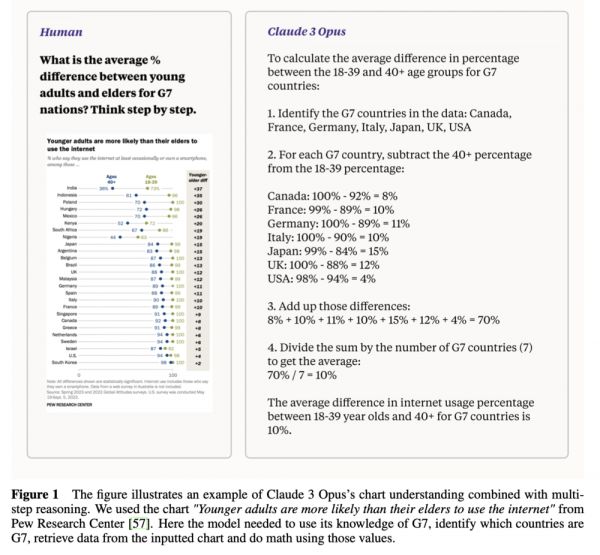

首先是多模态理解与处理能力,Claude 3能够处理和理解图像和视频帧输入,从而解决超出简单文本理解的复杂多模态推理挑战。

在AI2D科学图表基准测试中,Claude 3的能力得到了展示,尤其是在视觉问答评估方面。这项评估涉及到理解和分析图表,然后根据图表信息回答多项选择题。简单来说,就像在考试中,你被给了一些图表(比如柱状图、线图等),然后要回答一些基于这些图表的问题。Claude 3不仅要理解图表显示的数据,还要准确选择正确的答案。

在这个测试中,Claude 3展现了非常高的准确率,特别是Sonnet版本,在没有任何预备知识(即0-shot设置,也称为零样本学习)的情况下就达到了89.2%的准确率,这表明它非常擅长理解图表和回答相关问题,即使是在没有特定训练的情况下。这种能力对于执行需要图像和文本结合理解的任务非常重要,比如在学术研究、市场分析等领域。

在长文本处理方面,Claude 3模型支持至少1M(1,000,000)个token的上下文,而目前在生产中仅提供最多200k(200,000)token的上下文。在长文档理解、跨文档分析、金融数据分析等方面提供了更详细和可操作的用例。这一点在处理大规模文本数据时,相对于GPT-4可能更有优势,尤其是在需要综合分析和提取大量信息的场景中。

此外,Claude 3的多语言能力也被Anthropic认为是一大亮点。Claude 3 Opus在多语言数学(MGSM)基准测试中达到了超过90%的0-shot成绩,并在8种语言中实现了超过90%的准确率,包括法语、俄语、简体中文、西班牙语、孟加拉语、泰语、德语和日语。这表明Claude 3在多语言理解和推理方面具有较强的能力,尤其是在数学问题解决方面。

最后,Claude 3在长文本理解、推理、编程以及科学查询处理方面均表现出良好的性能。其在长文本问题回答基准测试QuALITY中的表现尤其突出,0-shot和1-shot设置下的表现均优于早期模型,显示了其在理解和处理长文本上的高效能力。

在Claude的技术论文中也提到了一些模型的不足之处。

首先Claude不能联网。虽然用户可以通过直接分享的文档方式互动互动,但Claude只能基于2023年8月之前的数据回答问题,并拒绝识别图像中的人物。

其次是所有大型语言模型(LLMs)都会遇到的问题,生成内容的准确性和偏见,Claude亦会产生错误信息(confabulations)、展现偏见、犯事实错误,并可能被“破解”(jail-broken)。

多语言推理能力的不完备,在处理小语种时性能较不稳定。

多模态能力方面的准确性有待提高,Claude模型有时可能生成关于图像的不准确信息和描述。性能有时也会在处理小图像或低分辨率图像时降低。

最后是新能力的“潜在”负面效应。Claude 3引入了新的多模态、多语言能力等,开发人员认为这些能力有时可能会打破模型原有的“平衡”,某些新改进的能力在其他领域可能造成潜在影响。

论文中提到:随着时间的推移,决定Claude“个性”和能力的数据和影响因素变得相当复杂。在简单可自动化的方式中平衡这些因素,跟踪它们,以及一般减少训练Claude的复杂性,仍然是我们的关键研究问题。

走OpenAI没走的路

Anthropic在Claude 3的发布博客中介绍了三款模型的潜在应用方向,带着浓浓的ToB商业化气息。

Claude 3 Opus:任务自动化,跨 API 和数据库规划和执行复杂的操作、交互式编码;研发,研究回顾、集思广益和假设生成、药物发现;策略,图表、财务和市场趋势的高级分析、预测。

Claude 3 Sonnet:数据处理,RAG 或对大量知识的搜索和检索;销售,产品推荐、预测、定向营销;节省时间的任务,代码生成、质量控制、从图像中解析文本。

Claude 3 Haiku:客户互动,实时互动、翻译中快速、准确的支持;内容审核,捕捉危险行为或客户请求;节省成本的任务,优化物流、库存管理、从非结构化数据中提取知识。

外界一直认为Anthropic是一家有着重度ToB基因的公司。

Anthropic在C轮融资中,引入了Google、Salesforce、Zoom等技术和服务市场上的ToB科技巨头,这些合作伙伴对AI公司的诉求必然是将先进的AI技术集成到自己的产品和服务中,以提高效率、创新能力和竞争力。

此外,Anthropic已经与Zoom开展合作,旨在“构建以可靠性、生产力和安全性为中心的面向客户的AI产品”,也清晰地表明了公司的B2B基因。这种合作通常涉及开发能够为企业提供具体价值的解决方案,如改善客户服务、自动化工作流程或提供决策支持等。

Anthropic还与波士顿咨询集团(BCG)合作,旨在将负责任的生成式AI技术引入到企业客户中。通过这一合作,BCG的客户可以直接利用Anthropic的AI系统,包括其最先进的模型Claude 2,这些系统专注于可靠性、可解释性和可控性。

目前,Anthropic声称已拥有多个来自不同行业(包括医疗保健、人力资源和教育等)的客户。

在企业服务和ToB市场上,虽然OpenAI也推出了ChatGPT Enterprise版以及企业的API接口,但相对于Anthropic与企业的深度合作,则ToB属性轻得多。

从这次Claude 3的中提及的很多重点也可以看出,Anthropic希望在商业化方面,走出一条与OpenAI不同的道路。

相关推荐

GPT-4的黑箱运作方式,让他们怒了

流氓手段,流氓理由……

GPT-4被吹爆,科学家担忧溢屏

Stripe:像个文明一样去思考(六)

GPT-4就是冲着赚钱来的!

Stripe:像个文明一样去思考(七)

GPT-4背后的算法,对齐了,又没完全对齐?

互联网创业流氓简史

遇到流氓,我们该怎么办?

苹果微软等科技公司联手汽车制造商,敦促欧盟打击专利流氓

网址: 他们让GPT-4看起来像个流氓 http://m.xishuta.com/newsview110606.html