为什么DPU在新算力时代这么重要?

首次被国家正名的DPU

日前,工业和信息化部、中央网信办、教育部、国家卫生健康委、中国人民银行、国务院国资委等六部门联合印发了《算力基础设施高质量发展行动计划》(以下简称“行动计划”)。

该行动计划中提到“促进数据处理器(DPU)、无损网络等技术的研发与应用”,这是DPU首次出现在国家层面的文件中。

诚然,数字经济已经成为了大国发展的重中之重,与此同时,新一轮人工智能浪潮对算力发展提出了更高层次的要求,算力效率的提升则是箭在弦上,不得不发。

而国家层面为DPU正名也意味着其在提升算力高效运载能力,优化算力高效运载质量,促进绿色低碳算力发展,引导算力基础设施高质量发展等方面有着至关重要的作用。

比如在英伟达最新一代的超强人工智能系统DGX GH200里,DPU是除GPU以外的另外一颗核心芯片,从中足以看出DPU在算力效率提升的重要性以及在人工智能时代的地位。

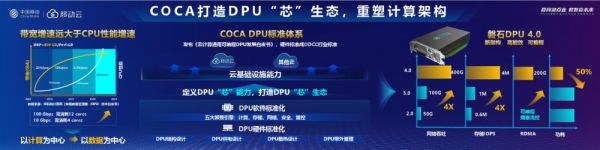

巧合的是,在行动计划发布的同一周,中国移动就率先发布了自研DPU产品——磐石DPU,其吞吐量达到400Gbps,比中移动之前FPGA版本的性能提升4倍,功耗降低50%,是目前国内最先进、性能最高的DPU芯片,重新定义了DPU硬件和软件标准体系。同时,在RDMA上可达到200Gbps,也是国内首创。

据悉,这并非是中国移动在DPU方面的唯一动作,在今年四月,中国移动曾与云豹智能联合发布了《云计算通用可编程DPU发展白皮书》,在近期召开的中国移动伙伴大会上,双方又联合发布了COCA白皮书。

需要指出的是,现在国内行业其他公司都用的FPGA方案,对于国内电信运营商来说,如果业界有一款商用的有足够竞争力的DPU SoC,其将毫无疑问地从CPU+FPGA的DPU解决方案升级到DPU SoC方案。

而中国移动首次发布DPU芯片方案也将云计算行业竞争提升到了一个新的高度,据知情人士透露,中国联通和中国电信也都在酝酿自研DPU的相关动作。

不难推测,三大运营商积极投入自研DPU Soc赛道势必将倒逼其他云计算厂商将技术方案向此倾斜,一来,他们代表了国家队的技术方向,二来,最近两年,作为新闯入者的运营商云来势汹汹,已经在云计算市场站稳了脚跟,并蚕食了一定的市场份额。

DPU,不言而喻的重要性

虽然在近期国家层面才首提DPU,但早在两三年前,DPU就在国内芯片市场掀起了一阵风潮,甚至成为了资本和大厂热追的风口。当然,这背后也折射出了这样一种行业共识,即技术趋势正在从以计算为中心(CPU为中心)向以数据为中心(DPU为中心)演进。

对于这一点,则要从CPU谈起。

众所周知,自计算机问世以来,一直采用的冯·诺依曼架构,该架构以计算和存储为核心。其中CPU作为处理器单元,负责执行各种算术和逻辑计算。RAM和硬盘则负责存储数据,并与CPU进行交互。

再后来图形、3D设计等多媒体软件的高速发展,要处理的工作量越来越大,也越来越复杂。为了帮CPU分担压力,专门进行图像和图形处理工作的GPU应运而生。

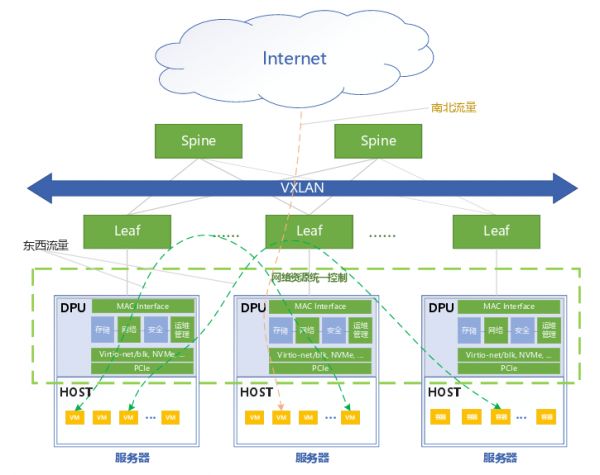

如今,随着数据量的指数性增长,计算任务难度和复杂性的增加,传统以CPU为中心的数据中心架构也开始面临性能的考验,此时,DPU作为一种面向海量数据的新型专用处理器,能够起到为CPU分担的作用。

提到DPU,很多人首先想到的是数据中心,是算力。但其实从功能角度来看DPU,英伟达给出了一个形象的回答——用来把数据在正确的时间放到正确的位置。

具体地,“正确的时间”指的是必须满足延迟要求,带宽要能达到数据量,数据带宽要做到匹配;“正确的位置”则是要把所有的远程资源都本地化,所有的跨节点访问都要做的跟访问本地的资源是一样的。

通俗一点讲,在云计算系统当中,如果说数据是一辆辆快速奔驰的汽车,那么DPU则是指挥这些汽车高效行驶的交通灯,可见,DPU能够有效提升算力高效运载能力。

如果说,DPU在功能性上的作用是为行业带来了新的技术核心,那么对于国家和企业来讲,DPU还起到了切实的降本增效的作用。

首先,从国家层面来讲,数字经济显然已经成为了大国之争,而数字经济说到底是成本决定的,因此谁能用最低的成本完成最高级的算力部署,谁就在这场竞争中占据了主动。尤其是人工智能浪潮之下,大规模数据需要经过复杂的集群训练,就算10%的算力效率提升,都意味着将节约几十上百亿的成本。

DPU之于数字经济,犹如燃烧过程中的氧气,虽然氧气不是燃料,但是没有氧气就无法进行燃烧。当前不仅需要新的算力,也需要新的网络,而同时能够做到算力与网络提升的,只有DPU,也就是说没有DPU这样的基础设施,任何算力都将成为空谈。

其次,从企业本身来讲,云计算在国内发展了十余载,但盈利一直是困扰云计算企业的难题。

而云计算的商业模式很简单就是通过互联网提供计算资源、存储资源和应用程序服务,简单点,就是售卖算力资源,是规模化的生意。难以盈利的原因,也显而易见——算力成本高。也就是说,如果能够提高算力效率,那么盈利也并非空中楼阁。

以AWS为例,根据亚马逊发布的2022年度财报显示,AWS业务全年营收约为801亿美元,同比2021财年增长29%。营业利润228亿美元, 营业利润率为28.7%。其财报指出,AWS能够同时保持高营业利润和高增长,离不开DPU技术(Nitro)。

此外,我们在上文提到,没有DPU作为基础设施,算力难以展开,这也直接影响到云计算企业的竞争排位。也正是上述两个原因,国内云计算厂商的玩家均对DPU展开了重点布局。

玩家众,成者少

值得一提的是,国内DPU赛道中站满了各路玩家,但各家的技术路线选择并不相同。

目前国内云厂商大部分还是基于CPU+FPGA的DPU解决方案,这些方案在研发投入上拥有一定的时间优势,但因其功耗过高及性能受到限制,并未达到新一代云计算的要求。比如阿里云、腾讯、字节跳动等互联网巨头,以及一些DPU创业公司星云智联、云脉芯联、中科驭数、大禹智芯、益思芯、芯启源等。

然而,纵观DPU架构和技术发展历程,可以明确看到DPU SoC(System-on-Chip)是当前国外头部云服务提供商和DPU厂商的主流技术路线。

我们也看到了国外行业领先企业的发力和探索。

早在2015年,全球最大的云服务商AWS收购半导体公司Annapurna开发DPU SoC芯片,开启了DPU应用的序幕。如今以亚马逊、Nvidia、Intel和AMD等为代表的头部企业都陆续通过自研或并购的方式在DPU SoC上进行研发投入。

例如,AWS最早研发DPU SoC芯片,并在多年前已最先实现了DPU SoC(AWS称之为Nitro)商业化的成功部署;Intel与Google合作开发Mount Evans系列的DPU SoC;Nvidia于2020年以69亿美元收购Mellanox,随后快速面向全球数据中心市场推出了BlueField系列的DPU SoC;AMD于2022年以19亿美金收购了DPU SoC厂商Pensando。

当然,在国内也有一家创业公司——云豹智能,选择了DPU SoC这条技术路线。虽然SoC的性价比高很多,但由于开发SoC要求团队拥有丰富的经验和多年的技术积累,并能够承担巨大的资金投入,所以之前很多大厂和创业公司都选择了投入成本较低但性能也相应低的路线。

DPU SoC的技术壁垒究竟有多高?专业人士给出的答案是要远远超过CPU和GPU,因为这项技术不但涉及到了芯片本身,还有复杂的软件系统。

这样的技术壁垒和资金投入也就说明了DPU SoC是个赢家独赢的赛道。正如GPU在海外成就了英伟达一样,将来DPU也是如此,会出现一家独占鳌头的公司。

而此次国家将DPU提到了新的高度,其也再次成为关注的焦点,让这个有些降温的赛道,重拾了热度,未来格局如何演进,着实让人兴奋和期待。

相关推荐

大算力芯片时代下,Arm迎来新风口

300万跟注英伟达,腾讯云走上了DPU的道路

一片蓝海的DPU市场

英伟达的DPU,是想在数据中心奇袭英特尔?

财经早知道:AI芯片算力跨越的破局之路,各大巨头纷纷布局Chiplet工艺

芯片巨头热捧、英伟达老黄狂吹,国内掀起DPU融资热

DPU芯片公司“中科驭数”完成数亿元B轮融资,国家队领投|硅基世界

处理35亿张图片+42台服务器+336块显卡,硅谷可怕的AI算力就是这么来的

中国算力位居全球第二!中兴“东数西算”全栈产品亮相,助力升级

推开“智算之窗” 解码“产业秘钥” 中国电信亮相2023年中国算力大会

网址: 为什么DPU在新算力时代这么重要? http://m.xishuta.com/newsview94076.html