OpenAI CEO出席美国国会听证会:对待AI应该参考核武器的监管方式

出品|虎嗅科技组

作者|齐健

编辑|陈伊凡

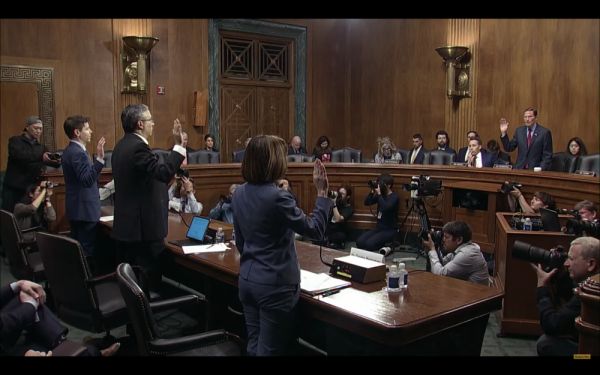

头图|直播截图

“AI会出错。”

在当地时间5月16日上午,OpenAI首席执行官Sam Altman在美国国会举行的关于人工智能监管的听证会上说。

过去几个月,OpenAI的产品ChatGPT在全球掀起了新一轮人工智能浪潮,犹如一只横冲直撞的“燃烧弹”,冲击了各个领域,点燃一把火,与之相关的生成式AI的监管也在全球范围展开。

美国政府虽然打起了十二分的精神,并从多个层面提出了高度重视。但Sam Altman却并没有如周受资抑或是扎克伯格一样被美国政客“围攻”,这场听证会甚至比多数硅谷科技公司参加过的国会听证会都短,只有2小时40多分钟。

在这个过程中,并没有呈现出剑拔弩张,会议结束后也是一片安静祥和。

会后,Sam Altman甚至像个大学生一样,跑到IBM的首席隐私和信任官Christina Montgomery面前主动握手,然后又跑到主席台前,跟听证会小组主席“虚心请教”了一番。

有趣的是,许多参议员似乎对Sam Altman十分器重,参议员John Neely Kennedy甚至询问Sam Altman他本人是否有资格参与组建监管AI的联邦机构。不过Sam Altman似乎对这份工作并没什么兴趣,他说,“我喜欢我现在的工作。”同时,他也表示OpenAI将会尽快向国会提交一份他们认为适合这份工作的人员名单。

而Sam Altman在这场听证会中的姿态也非常低,对于生成式AI,他似乎也有迷茫和困扰。“面对日益强大的AI模型,政府监管机构的干预对于控制相关风险来说至关重要。”他表示。

与Sam Altman一同参与这场听证会的还有一直在社交媒体上对AI研究提出质疑的AI学者,纽约大学心理学和神经科学名誉教授Gary Marcus,以及刚刚宣布用生成式AI替换7000余名人类员工的IBM的首席隐私和信任官Christina Montgomery。

Christina Montgomery,Gary Marcus,Sam Altman(左到右)

本场听证会聚焦的问题也正是美国政府和全社会广泛关注的问题,其中包括:

1. AI是否会生成危险内容

2. AI是否会威胁到美国的国家安全

3. AI是否会侵害公民的隐私,以及数据权利

4. AI是否会影响就业

5. 对AI的监管,是否会影响美国在国际竞争中的地位

对此,Sam Altman及其它两位证人一一做出了回答。

美国应带头监管人工智能

在听证会上,美国议员提出应该组建一个专门监管AI的新机构。Sam Altman非常认可这一做法。

Sam Altman在听证会上提出OpenAI在这方面的3个计划:

成立一个新的政府机构,负责审批大型AI模型。并对不符合政府标准的公司进行处理,包括吊销他们的AI“执照”。

为AI模型创建一套安全标准,用以评估其风险。AI大模型必须通过某些安全测试,例如它们是否能够“自我复制”或是“出逃(摆脱人类控制)”。

要求独立专家对模型在各个指标上的表现进行独立审核。

有国会议员提出关于AI研究的国际监管问题时,提到了世界各国政府在监管核武器方面都有先例。Sam Altman表示了赞同,并且他认为美国应该带头监管人工智能, “如果每个国家对每个司法管辖区都有自己的政策和法规,那么AI公司就需要针对不同地区重新训练模型,如果没有全球协同,这些公司将很难运作。”

在这方面,Gary Marcus也表示支持,并提出应该像对待原子弹一样,成立一个类似国际原子能机构的国际组织,以应对人工智能的风险。

在立法方面,美国政府为监管社交媒体平台专门制定了230法案,该法案免除了在线服务对用户发布内容的责任,由此大幅促进了社交媒体的兴起。新兴的生成式人工智能,在内容生产上与社交媒体不无相似之处。这也使得美国政府在立法方面,直接将AI与社交媒体相对比。探讨AI技术是否适用230法案,AI公司是否应该对AI生成的内容负责。

对此,Sam Altman认为AI并不适用230法案,他表示生成式人工智能工具需要一套新的责任框架。例如AI研发机构对AI生成的内容需要负有一定的责任。

没有训练更高版本的GPT,未来半年内也没计划

在听证会上,有议员提到了此前热议的“暂停大规模人工智能模型研发”联名信。

作为联名信签署人之一,Gary Marcus解释说,联名信的目的并不是要求暂停研发AI,而是希望在具备规范、安全的AI管理措施之前,暂停部署比GPT-4更大的AI模型。他认为现阶段,要将这些“超级AI”交给1亿普通人使用,还是太快、太冒险了。

Sam Altman则表示,在完成GPT-4的训练后,OpenAI等了6个月才上线。他表示,“我们目前没有在训练更高版本,例如GPT-5。我们在未来6个月内也没有这样的计划。”

但他认为联名信的框架是错误的,他说,“对于AI来说,最重要的是安全审核,红蓝队模拟(AI的安全对抗模拟)等安全措施。通过这些在部署前达到安全标准。“Sam Altman认为,暂停6个月并不是一个有效的做法,”如果暂停AI研发6个月,AI研发可能就会与时代脱节。6个月之后我们要怎样?再停6个月吗?”

不过,Sam Altman也认为,当发现一些不理解的东西时,确实需要停下来。他说,“目前我们对下一个模型就抱有忧虑,我们非常担心研发过程中可能会产生一些危险的内容,更不用说部署了。”

此外,Sam Altman还表示支持“要求AI公司在推出人工智能产品前评估人工智能产品风险”的新规定。他在提交给委员会的书面证词中表示,政府应“促进平衡的激励措施和安全监管,同时确保人们能获得技术带来的益处”。

AI大模型的研发主要集中在少数大公司手中,也引起了美国政府的关注。

参议员Cory Booker表示,他很担心AI领域的“大规模企业集中度”问题,“目前,OpenAI与微软合作,类似的大模型公司Anthropic则由谷歌支持。”。他认为,随着这些公司变得越来越大、越来越强大,它们对人们生活的控制和影响也将越来越大,并有可能在商业和技术上实现垄断。

对此Sam Altman认为,AI大模型的研发相对困难,只有少数企业能够研发出AI大模型。这并不会造成垄断,反而会在一定程度上降低监管难度。

生成式AI的监管还有很长的路要走

事实上,美国政府对于这波生成式AI热潮的关注与担忧已经有一段时间了,其在监管上也走得更早。美国商务部在4月11日已就相关措施正式公开征求意见,包括新AI模型在发布前是否应经过认证程序。征求意见期限为60天。

对于生成式AI的监管,与上一波人工智能的不同在于,其能够将数据跨境、知识产权、个人信息保护的问题放大化。因为过去的人工智能更多是针对某种特定场景,而生成式AI涉及到更多数据和通用大模型。涉及到的供应链角色更多,例如大模型提供商、在大模型之上做应用的服务商、还涉及存储数据的云厂商。

“生成式AI对于监管行业来说,是一个太新的事物,而且新技术发展很快,但我们现在针对算法、技术等立法监管并不能完全覆盖目前出现问题,对于监管来说,是很大的考验。”观韬中茂律师事务所合伙人王渝伟曾告诉虎嗅,王渝伟长期进行网络安全数据合规方面的法律工作。

更早之前,今年1月26日,美国NIST(国家标准与技术研究院)发布了《AI风险管理框架1.0》。这份框架,包括治理、映射、测量和管理的四个部分,治理指要在组织的制度流程、组织建设、组织文化、技术能力等方面践行AI风险管理框架;映射主要用于确定特定场景与其对应的AI风险解决方案;测量主要采用定量和/或定性的工具、技术和方法来分析、评估、测试和监控AI风险及其相关影响;管理主要是将相关资源分配给相应的AI风险,进行风险处置。治理是一个交叉模块,融入并影响其他三个模块。

在框架中也提到了AI系统的可说明性、可解释性、可追责、透明性的问题。例如,AI可信度特性之间可能相互影响,全面的AI风险管理需要在AI可信度特性之间进行权衡取舍。

另外,优化可解释性和隐私增强性之间会存在矛盾;或者在数据较稀疏的情况下,隐私增强技术可能导致有效性降低。过度关注某一方面特性,例如:高度安全但不公平的系统、有效但不透明和不可解释的系统以及不准确但安全、隐私增强和透明的系统都是不可取的。

从这份框架以及美国4月颁布的《人工智能问责政策征求意见》可以看出美国在制定人工智能监管方面政策时,重点在于问责明确。

5月5日,美国国家科学基金会(The National Science Foundation)宣布将拨款1.4亿美元(约合人民币9.67亿元),成立7个国家级人工智能研究机构,确保美国在AI领域保持领先的同时,遏制AI引发的道德、社会问题等。

政府还承诺为政府机构发布指导方针草案,以确保对人工智能的使用保障“美国人民的权利和安全”。有消息称,美国政府已得到Anthropic、Google、Hugging Face、Microsoft、NVIDIA、OpenAI和Stability AI六家公司的承诺,将提交他们的人工智能系统供专家社区进行公开评估,这些公司已同意在8月的一次网络安全会议上提交其产品以供审查。

美国总统拜登也曾表示,人工智能是否危险“有待观察”。他任命的一些高级官员承诺,如果以有害方式使用该技术,他们将进行干预。白宫在13日发布的文章中提到,美国总统科技顾问委员会(PCAST)正在组建一个生成式人工智能工作组。该工作组将帮助评估人工智能关键机遇和风险,并就如何最好地确保这些技术的开发和部署尽可能公平、负责和安全提供意见。目前已公布的专家名单中,就包括著名华人数学家陶哲轩,以及AMD的首席执行官苏姿丰。

美国时间5月16日早些时候,在华盛顿邮报的报道中,一位众议院助手称,国会人工智能核心小组将于听证会后与奥特曼举行仅限特定人员参加的简报会。这名助手说,该闭门会议将由众议院议长Kevin McCarthy和众议院少数党领袖Hakeem Jeffries共同主持。

在本场听证会上,两名参议员则专门针对这一问题微软及OpenAI就版权付费问题向Sam Altman提出质疑。对此,Sam Altman表示,OpenAI将会拿出保护地方新闻业的相关举措,但也没有具体回应如何在AI模型训练过程中保护内容创作者版权权益的问题。

相关推荐

OpenAI CEO出席美国国会听证会:对待AI应该参考核武器的监管方式

ChatGPT之父出席听证会,拥抱AI监管

直击TikTok美国国会听证会:中国公司出海的又一警示

最前线 | TikTok首次出席美国国会听证会,回应青少年网络保护、数据安全等问题

美众议院将举行反垄断听证会:要脸书谷歌等高管出席

美国国会听证会探讨“深度伪造”风险及对策

美国反垄断听证会今夜上演:四位科技巨头CEO证词提前曝光

TikTok的听证会,周受资“来不及说话”

扎克伯格将亲自出席美国众议院听证会并作证

奇怪的关注点,推特CEO在国会听证,他的胡子“火”了

网址: OpenAI CEO出席美国国会听证会:对待AI应该参考核武器的监管方式 http://m.xishuta.com/newsview75119.html