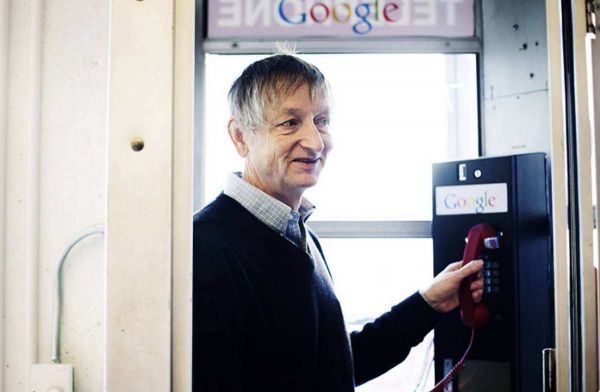

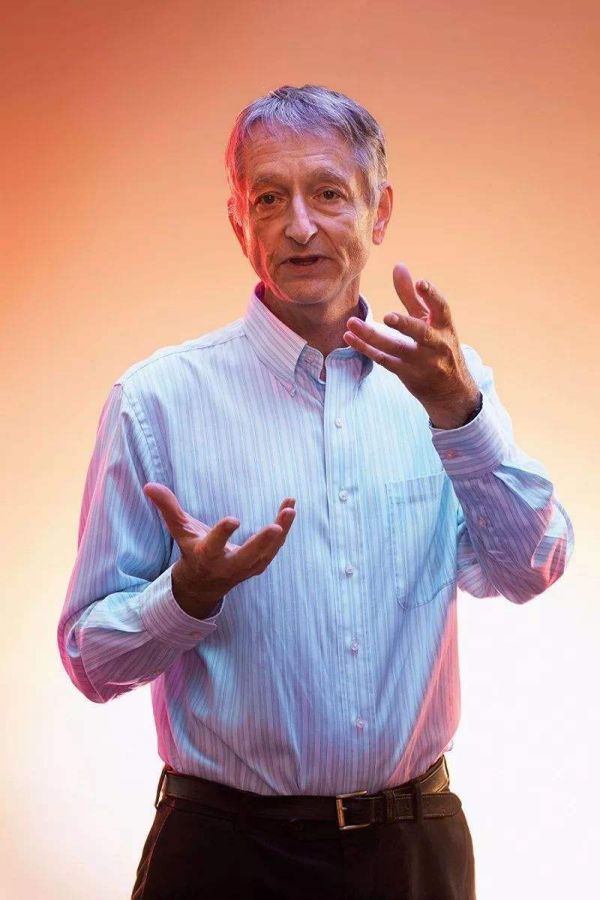

深度学习教父辛顿:未来神经网络可以重建人脑意识

杰弗里·辛顿(Geoffrey Hinton)是Deep Learning(深度学习)这一术语的“作者”,2019年他曾拿到图灵奖,他还是谷歌的工程师。,行业甚至称他为“深度学习教父”。最近在谷歌I/O开发者大会上,辛顿接受了《连线》杂志的采访,他谈到一些有趣的议题,比如早年些他曾对大脑着迷,计算机可以模仿大脑神经架构。辛顿还谈论了感知、自己的未来规划、是否应该教计算机做梦。

下面是整理后的对话实录:

早期研究

主持人:让我们从早期开始,当时你曾写过一些非常有影响力的论文。大家都在说:“真是个明智的构想,不过我们无法按这样的方式设计计算机。”能否解释一下你为何坚持自己的构想?什么你深信自己发现了相当重要的东西?

辛顿:在我看来大脑不可能按其它方式运,它用学习改变连接强度。如果你想制造一款设备,让它做一些明智的事情,你有两种选择:一是给它编程,二是让它具备学习能力。人没有编过程,所以我们必须学习。这条路是正确的。

主持人:请解释一下什么是神经网络,讲讲最初你的看法吧。

辛顿:首先是相对简单的处理元素,也就是松散的神经元模型。然后神经元会连接起来,每一个连接都有其权值,这种权值通过学习可以改变。神经元要做的事就是将连接的活动量与权值相乘,然后累加,再决定是否发送结果。如果得到的数字足够大,就会发送一个结果。如果数字是负的,就不会发送任何信息。你要做的事就是将无数的活动与无数的权重联系起来,然后搞清如何改变权重,那样就行了。问题的关键就是如何改变权重。

主持人:你什么时候开始理解到神经网络的运行与大脑相似?

辛顿:从一开始神经网络就是按这样的方式设计的,和大脑运行机制相似。

主持人:所以说,到了职业生涯的某个阶段,你开始理解大脑是如何运作的。当时你可能只有12岁,也可能是25岁。不过你是什么时候做出决定,准备参照大脑设计计算机的?

辛顿:大体正确。总的想法是就是开发一台会学习的设备,让它像人类大脑一样学习,我们普遍认为大脑通过改变连接来学习。这个想法不是我提出的,英国数家图灵也有相同的看法。虽然图灵为计算机科学制定了许多基本标准,不过他认为大脑是一个无组织设备,有着随机权值,它会通过增强学习来改变连接,从而学习各种知识。他认为这是通向智能的最佳捷径。

主持人:你遵循图灵的构想,认为我们如果想参照大脑开发机器,这是最好的选择。人类大脑正是这样运作的,可以按这样的方法开发机器。

辛顿:是的,构想来自图灵,很多人认同这种观点。

主持人:最糟糕的时刻是什么时候?本来有一些人在努力,他们赞同图灵的构想,什么时候他们开始后退,而你继续前进?

辛顿:一直有一些人坚信的,在心理学方面尤其如此。至于计算机科学家,90年代时,数据集还很小,计算机也没有那么快。如果是小数据集,其它方法更好用,比如支撑向量机(Support Vector Machines),它们不会受到噪音的严重干扰。真是让人沮丧,因为80年代时我们开发了反向传播算法(Back Propagation,BP算法),我们原本认为它是万能的,结果不是,我们深感困惑。实际上只是规模问题,只是我们当时并不知道。

主持人:为什么你认为这种方法行不通?

辛顿:我们之所以认为它不管用,主要是因为我们没有正确的算法,没有正确的目标函数。在很长的时间内,我们曾认为行不通主要是因为我们正在做监督式学习,你必须拥有贴标签的数据,我们应该做的是非监督式学习,可以从没有标签的数据中学习。结果证明主要还是规模问题。

主持人:真有趣。问题的关键在于没有足够的数据。你原本认为你们拥有的数据足够了,但是没有给它们贴上正确的标签。你们在问题的判断上出了错?

辛顿:我认为光是使用标签是错的。许多学习没有使用任何标签,只是在数据中给结构建模。我现在仍然坚信这一点。如果计算机更快一些,给予任意特定规模的数据集,只要计算机足够快,在无监督学习方面就能得到更好的结果。当你做好了无监督学习,只需要少量的标签就能学习了。

主持人:1990年代时,你继续自己的研究,钻进学术行业,你不断发表论文,但是没有解决最大的问题。当时你有没有对自己说过:“够了,我要去做其它事。”还是说:“继续研究深度学习。”

辛顿:我继续研究,因为当中一些原理是正确的。大脑连接以某种方式学习,我们只是要搞清它是如何进行的。大脑连接强度可能通过多种多样的方式学习,大脑使用其中的一种,还有其它方法。你必须找到一些东西,模拟这种连接强度。我对此深信不疑。

主持人:你从未怀疑过。什么时候它开始走上正轨,看起来越来越正确?

辛顿:80年代有一件事让人很失望:如果你开发的网络有很多隐藏层,你没有办法训练它们。当然这种说法并不完全正确,因为有些简单的任务还是可以训练的,比如识别笔迹。至于大多的深度神经网络,我们不知道如何训练。

2005年时,我提出一种新方法,可以用无监督方式训练深度网络。你输入内容,给出像素(pixels),然后你要获取一堆特征检测器,它们可以解释为什么像素是这样。接下来,你要修正这些特征检测器(以数据的形式存在),再获取其它特征检测器,这样你就可以解释为什么特征检测器拥有这样的相关性。

你继续深入一层又一层。有一点很有趣,你要做一些数学计算,证明每一次深入新层时,不一定非要有更好的数据模型,但是你有一个等级,可以评估模型有多出色。每增加一个层,等级会提高。

主持人:你说的是什么意思呢?到底模型有多好,你会分出等级吗?

辛顿:一旦你有了一个模型,你可以说:“模型些数据到底有多么让人吃惊?”你给它一些数据,然后你会问:“它是就你相信的东西,还是让你感到吃惊的东西?”你可以对此进行评估。

总之,你要做的事情就是建一个模型,一个很棒的模型,它观察数据,你会说:“是的,是的,我知道,的确的让人吃惊。”

模型发现数据到底有多么让人吃惊呢?许多时候很难准确计算。你可以设立等级。此模型在数据中发现的东西没有彼模型让人吃惊。当你增加新一层特征检测器,你会得到一个模型,每增加一层,找到的数据会更加让人吃惊。

更好的语音识别

主持人:2005年时,你提出此构想,它在数学方面是一大突破。从什么时候开始,你开始拿到正确答案?当时你研究什么数据?你最初取得突破时研究的是语音数据,对吗?

辛顿:当时只是手写体数字,非常简单。大约就在同一时间我开始开发GPU。2007年时,神经网络研究人员开始使用GPU。我有一名非常出色的学生,他开始用GPU做研究,从航拍图片中寻找公路。

他写了一些代码,其它学生拿去使用,他们用GPU识别语音中的音素。当时学生们做的是“预训练”,当他们做完所有的预训练,只要在上面贴上标签,就可以引入反向传播算法。结果证明,这样做可以开发出一套非常深的预训练深度网络。然后你可以使用反向传播,能够运行。从某种程度上说它的语音识别能力超过了基准,最开始时只是稍微超过一点点。

主持人:是不是说它击败了最好的商用语音识别系统?还击败了最好的学术语音识别系统?

辛顿:用TIMIT语音数据库测试,它的表现的确比最棒的学术系统稍好一些,比IBM系统也要好一些。由于新系统击败了标准模型,而标准模型是专家们花了30年时间才开发出来的,结果让人满意。很快,大家意识到只要多花一点时间研究,结果会更好。所以我的研究生去了微软、IBM、谷歌,谷歌的推进速度很快,它将新技术植入成品语音识别器。到了2020年,新技术融入Android,2009年谷歌才开始研究,2020年就全面推广了。很快,Android的语音识别能力大幅提升。

主持人:40年前你提出这样的构想,在20年的时间里你一直发表论文,最终你做得比同事更好,这是一种怎样的感受?

辛顿:实际上这样的构想是30年的提出的。

主持人:这是一个新想法。

辛顿:终于它成为一个真正的问题,我对此感到满意。

主持人:你是何时何地获得第一批启示性数据的,还记得吗?

辛顿:不记得了。

主持人:你意识到它在语音识别领域是可行的,然后你开始用同样的技术解决其它问题,什么时候的事?

辛顿:我们开始用它来解决其它各种问题。最初有一批成员研究语音识别问题,George Dahl是其中之一,他用同样的技术预测分子与其它何种物质结合会变成良药。行业呈现出竞赛态势。他只是申请使用我们的标准技术,这套标准技术本来是为语音识别设计的,然后他用技术来预测药物活动,最终赢得竞赛。这只是一个迹象,说明这种技术应用广泛。我的一名学生说:“Geoff,你知道吗?这种技术可以用于图像识别,李飞飞为此准备了一套正确数据。大家公开竞赛,我们必须参与。”

最终结果显示它比标准计算机视觉技术好很多。得到结果的时间是2012年。

主持人:也就说新技术在三大领域取得成功,分别是建模化学、语言和声音,在哪些领域失败了呢?

辛顿:失败也是暂时的,你能理解吗?

主持人:有些领域进步很快,有些领域进步慢,二者的有区别在哪里?视觉处理、语音识别,还有一些与人类感官知觉密切相关的任务看起来难道较大,是行业首要清理的障碍,我说得对吗?

辛顿:不全对,因为还有其它也要优先处理,比如运动控制。人类擅长运动控制。我们的大脑就是为运动控制设计的。直到不久前,神经网络才有资格与其它最棒的技术围绕运动控制展开竞争。神经网络刚刚才开始占据上风,成为赢家,它会成为最终赢家。依我之见,推理、抽象推理,这些任务会是神经网络最后要去征服的。

模仿大脑

主持人:你认为神经网络最终在各领域成为赢家?

辛顿:是的,我们就是神经网络,最终我们能做的事它们也能做。

主持人:人类大脑不一定是最高效的计算机。

辛顿:当然不是。

主持人:会不会有有另一种模型机器,它的效率比人类大脑更高?

辛顿:从哲学角度看,我并不反对这一观点,可能会有另一种完全不同的方法能实现。如果你从逻辑开始,然后让逻辑自动化,再制作一些定理证明器,然后推理,接下来你决定利用推理来完成视觉感知任务,这种方法有可能胜出,但结果证明它不行。从哲学角度说,我并不反对这种方法有胜利的可能,我只是知道大脑能做到。

主持人:不过也有一些事情是大脑做得不好的。对于这些事情,神经网络也同样做不好吗?

辛顿:当然有可能。

主持人:我们完全不知道它们是如何运作的,对吗?

辛顿:是的,完全不知道。

主持人:我们不理解自上而下神经网络是如何运作的。人类不知道神经网络如何运作,这是神经网络的核心要素。如果我们不知道它是如何运作的,神经网络又如何能运作呢?

辛顿:你可以看看当前的计算机视觉系统,大多都是向前推进的,没有使用反馈连接。当前的计算机视觉系统还有其它一些特点,比如,很容易出现对抗性错误。面前摆着一张图片,你稍微修改几个像素,在人眼看来,它仍是熊猫,但计算机系统却说它是鸵鸟。很明显,你修改像素是精心准备的,目的就是遇难系统,让它将图片看成鸵鸟。而图片在你眼里仍然是熊猫,这才是关键。

开始我们认为一切正常。不过当算法注视着熊猫,却深信它是鸵鸟,我们有点担忧了。我认为,算法没有尝试从高层表现中重建,这可能是原因之一。

算法尝试做判别学习(discriminative learning),它只是理解特征检测器屋,整个目标只是调整权重,让算法变得更好,获得正确的答案。

最近,我们在多伦多做研究时发现,如果引入重建流程,算法对于对抗攻击会有更强的抵抗力。我认为,人类视觉也会学习,在学习时会重建。正因为我们通过重建学习,面对对抗攻击时才会有更强的抵抗力。

主持人:神经网络中有自上而来的通信,你深信有了这种通信,就可以测试重建。如何测试呢?如何确保算法判断图片是熊猫,不是鸵鸟?

辛顿:这才是关键。

主持人:对于这点,大脑科学家并不是完全赞同,是吗?

辛顿:如果大脑有两个皮层区域处于感知通路中,它们就会向后连接,这点是所有大脑科学家都认同的。至于这样做有何用途,科学家的意见并不一致。可能是为了注意力,可能是为了学习,也可能是为了重建,或者三者都有。

主持人:所以说我们并不知道向后通信到底是什么。你们开发新神经网络(或者说你们搭建向后通信)是基于一种假设进行的:在神经网络中完成重建。虽然大家并不确定大脑是如何工作的,你们还是这样来做研究,对吗?

辛顿:是的。

主持人:这算不算欺骗?我的意思就是说你们正在努力开发很像人脑的东西,但我们并不确定它像大脑。

辛顿:不是这样的。我们所做的研究不是计算机神经科学研究。我们并不是想建一个模型,模拟大脑运行。我们观察大脑,然后说:“这种的方法可行,如果我们想让其它东西同样可行,我们应该从中寻找灵感。”换言之,我们的工作是从神经中寻找灵感,并不是建一个神经模型。神经元有许多的连接,它们的连接会增强,这是事实,我们从这一事实中寻找灵感。

主持人:真是有趣!如果我是一名计算机科学家,也在研究神经网络,想打败Geoff Hinton,我有一种选择,那就是以自上而下的通信作为基础,以其它脑科学模型作为基础,然后开发,也就是说学习不依赖重建。

辛顿:如果真有计算机科学家按这样的方法研究,开发的模型更好,那他们就是赢家。

连意识也能重建

主持人:真是非常非常有趣。让我们跳到一个更普通的话题吧。未来,神经网络将会解决所有问题。在人类大脑中是不是有些神秘之处,这些神秘之处是神经网络没有捕捉到的,或者无法捕捉的?比如情绪。

辛顿:没有。

主持人:难道说神经网络通过重建也可以体现出爱?意识也能重建吗?

辛顿:当然。当你搞清这些东西是什么,就能重建。人类本身就是神经网络。我们已经知道,意识就是人类特别感兴趣的东西,没有它我也能过得很好……人类并不能真正知道它是什么,对于意识的定义有很多种。我觉得它是一个科学术语。100年前,如果你问大家生命是什么,他们可能会说:“生物有生命力,一旦生物死亡,生命力就会消失,这就是生与死的区别,生者有生命力,死者没有。”

现在我们知道根本没有什么生命力,它只是前科学概念。只要稍稍学一点生物学和分子生物学,就会知道没有生命力,你能理解生命是怎样运行的。我觉得意识也是这样的。大家在解释意识时,总是想用某种特殊本质来解释精神现象。当你能真正能解释意识是什么,就能解释我们做了什么事才让大家认为我们有意识,还可以解释不同意识的差异,不需要什么特殊本质。

主持人:从理论角度看没有什么无法被创造的情绪,没有什么无法被创造的思想,当神经网络完全理解大脑运作机制,人类心智都可以被创造,没有不能创造的,是这样吗?

辛顿:John Lennon唱的歌和你刚才所说的很像。

主持人:对于这个观点,你100%确定它是正确的吗?

辛顿:非也,我不是Bayesian,不过我可以99.9%确定。

主持人:好吧,那么剩下的0.1%是什么呢?

辛顿:例如,我们可能是大型建模的一部分。

主持人:说得通。在计算机研究过程中我们学到什么脑科学知识呢?

辛顿:在过去10年里,我们发现,如果开发一套系统,拥有几十个亿个参数,给一个目标函数(比如填补一串单词中的空白),它的表现很好,比我们预料的好很多。此时你就会想,AI行业的许多人都会想:开发一套系统,拥有10个亿参数,然后从随机值开始优化系统,不断评估目标函数的提升梯度(将各参数稍微改变一点点,看看目标函数会有多大进步),然后再朝着提升目标函数的方向改变参数。

你可能会认为这是一种毫无希望的算法,但事实却证明算法很好。规模越大,算法的表现越好。这是一项了不起的发现,而且是实证发现。当中有一些理论成份,但基本上算是实证发现。因为有了这样的发现,我们更相信一种理论:大脑会计算某些目标函数的梯度,更新突触强度的权值,使权值与梯度匹配。现在我们必须搞清梯度是如何降级的,目标函数是什么。

主持人:不过我们还不知道大脑是如何运行的?不知道它是如何更新权值的?

辛顿:这只是一套理论。许久以前大家就认为有这样的可能。一直都有传统计算机科学家在说:“一切都是随机的,你只能通过梯度下降来学习。如果有10亿参数,这种策略行不通。为什么?因为要输入海量知识。”现在我们知道他们的观点是错的,你可以输入随机参数,然后学会各种技能。

主持人:我来解释一下。首先,我们会在模型之上完成大规模测试,结合对人类大脑功能的假定,我们会对大脑有更深入的理解,知道它是如何运行的。未来会不会触及某一个转折点,到时我们可以“重写”大脑,让大脑像高效机器一样运转?

辛顿:如果能真正理解当中的运行机制,的确能在让某些行业变得更好,比如教育。当我们真正理解大脑是如何运行的,是如何学习的,就能让人脑更加适应环境,学得更好。

主持人:再过几年,人类对大脑、深度学习会有更深的了解,我们到时如何利用这些知识改变教育、改变课堂?

辛顿:未来我们会了解一些什么知识,对此我并不是很确定。如果想改变教育行业,那是更久远的事。不过变化已经存在,助手变得越来越智能了。当助手可以真正理解对话,就可以让助手与孩子交流,教育孩子。

主持人:从理论上讲,当我们对大脑有了更深的了解,就可以改进助手,让它与孩子对话,根据孩子需要学习的东西对话。

辛顿:是的。

梦的理论

主持人:能不能理解梦是怎样形成的?

感兴趣,至少四种。

主持人:能说说嘛。

辛顿:很久以前就出现了Hopfield网络,它通过“局布吸引子”学会记忆。Hopfield(物理学家)发现,如果你将太多的记忆放进去,网络会感到困惑。两个局布吸引子会在中途融合,变成一个。

然后Francis Crick和Graeme Mitchison指出,可以通过反学习来摆脱错误极小值。不输入信息,将神经网络转换到随机状态,让它稳定下来,稳定之后我改变连接,让它摆脱稳定态,稍微改变一下就能存储更多记忆。

再后来Terry Sejnowski和我提出一种理论。我们当时在想:“如果我们不只有存储记忆的神经元,还有许多其它神经元,能不能开发一套算法,让所有其它神经元帮着恢复记忆呢?”根据这一构想,我们最终开发出玻尔兹曼机,它有一个相当有趣的特点:向算法展示数据,它会在其它单元的周围振动,直到进入非常舒适的状态才停止,完成之后,它会根据两个单元是否都激活来增强连接。

当中还有一个阶段也是必需的,进入此阶段,算法会与输入信息切断,它会振动,进入非常舒适的状态,于是算法就有了“幻想”,当它有了幻想,你就会想:“让我们拿掉激活的神经元,降低连接的强度。”

算法实际上是一系列数学计算的结果。如何改变连接串才能让拥有隐藏单元的神经网络找到让人吃惊的数据呢?要找到必须拥有这么一个阶段,我们管它叫“Negative Phase”,让算法与输入切断,继续运行,忘记自己进入的状态。

晚上,我们会做几个小时的梦。当我们突然醒来会记得一些梦,因为它存在于短期记忆中。总之,你做了几小时的梦,但是早上醒来时只记得最后的梦,其它的全忘了;这是一件好事,否则你可能会把梦与现实混淆。为什么其会忘了其它梦呢?按照Crick的观点,做梦的过程就是反学习过程。简言之,学习过程是反的。

Terry Sejnowski和我认为,玻尔兹曼机的学习过程很可能就是这样的。

主持人:接下来我们谈谈其它理论。你们有没有尝试让深度学习算法学着做梦?让它在一段时间内理解图片数据,然后重置,再次学习,再重置。

辛顿:是的,我们开发过这样的机器学习算法。早期有一些算法可以处理隐藏单元,比如玻尔兹曼机,只是效率并不高。后来,我找到一种方法,与玻尔兹曼机相似,但是效率更高。正因如此,专家们再次钻进深度学习。当时我们对特征检测器有了更多理解,它相当于受限玻尔兹曼机的有效形式,通过反学习来实现。算法并没入睡,只是在每个数据点之后会幻想一段时间。

主持人:让我们来谈谈你感兴趣的第二种、第三种和第四种理论。

辛顿:第二种理论叫Wake Sleep算法。首先要学会一个生成模型,这个模型会不断生成数据,它有各种特征检测器层,算法会激活高级层和低级层,不断继续,直到激活像素,形成图像。除此之外,我们还想让算法用其它方法学习,识别数据。

算法分两个阶段。在苏醒阶段,数据进入,算法努力识别数据,而不是理解用于识别的连接,它学着生成连接。总之,数据流入,我要激活隐藏层,然后让隐藏单元重建数据。在每一个层都要学着重建。问题来了,假如是正向连接,你如何学习呢?如果我们能理解正向连接,就能理解反向连接,因为你可以掌控重建过程。

如果你使用的是反向连接,也可以学习正向连接,因为你可以从顶部开始,只需要生成一些数据就行了。因为要生成数据,所以你能知道所有隐藏层的状态,这样就能学习正向连接,恢复状态。这就是Sleep过程。当你切断输入,你会生成数据,然后努力重建生成数据的隐藏单元。如果你知道自上而下的连接是怎样的,也就能知道自下而上的连接是怎样的。假如你知道的是自下而上的连接,同样可以知道自上而下的连接。如果是从随机连接开始的,又会怎样?那样的话两种都要试,最终是可行的。总之,所有变化形式都要试,但的确可行。

主持人:另外两种理论你想介绍嘛?我们只有8分钟时间了,如果要介绍,可能会省掉其它问题。

辛顿:如果再给我一小时,也许可以解释一下其它两种理论。

Capsules理论

主持人:那就谈谈其它问题吧。你的研究方向是怎样的?你目前想解决什么问题?

辛顿:最终,你要做一些没有完成的事。我觉得我所做的事永远也不可能完成,它叫作“Capsules”,这是一种理论,告诉你如何利用重建实现视觉感知,如何将信息传到正确的地方。在标准神经网络中,信息(也就是层上的活动)会自动传到某些地方,你不能决定它的去向。Capsules的存在就是要决定信息的目的地。自从我开始研究Capsules之后,谷歌其它一些人开发了Transformer,它们的功能一样。

激发Capsules的另一个因素是坐标框架。人类用视觉观察时,经常用到坐标框架。如果观察对象时使用的视觉框架错误,有时甚至连对象是什么都看不清。我举个列子,假设有一个四面体,四个面都是等边三角形。不难想像,对吗?再假设让你用一个平面将它切开,想得到一个正方形横截面。

不太容易了吧?每次切开时往往会得到三角形,想得到方形不太明显。我再给你一个相同的形状,但是描述稍有不同。请把你的笔给我,假设有几只笔,将它们连起来,组成四面体。

此时再看会有不同的坐标框架,四面体的两个边缘会与坐标框架对齐。如果用这种方式观察四面体,你会发现在顶部有一个长矩形,在底部也有一个长矩形,两个长矩形的中间有一个方形。现在你可以明显看出如何切出方形,不过只有用这种坐标视觉观察才能一目了然。

对于人类来说,坐标框架在感知中扮演着相当重要的角色。

主持人:这种方法只是针对于视觉识别,还是说它是一种使用更广泛的技术,通过为坐标框架设定规则来改进?

辛顿:可以用在其它领域,不过我对视觉识别更感兴趣。

主持人:之前的深度学习是截然不同的东西。然后呢,它变成AI的同义词,现在AI成了营销术语,意思就是说以任何方式使用机器。在你的帮助下,机器学习被创建出来,对于这一术语你有何感受?

辛顿:AI术语流行时,我觉得还好,它的意思就是说以逻辑为灵感,操纵符号字符串。然后是神经网络,意思就是说你想在神经网络内完成学习任务。当时有各种各样的企业在研究,它们的关系并不好,为钱而战。我就是在这样的环境中长大的。现在呢,我听到一些人不断在说神经网络没有意义,他们大声叫喊:“我是一名AI教授,所以我需要钱。”真是让人讨厌。

主持人:也就是说你所研究的技术取得成功,从某种程度上吞噬或者包涵了其它技术,这样一来当他们提出金钱要求时就有了优势,真是让人沮丧。

辛顿:是的,现在的环境并不公平,因为当中的许多人转换了身份。

主持人:还有一点时间,让我再问一个问题。在一次讨论AI的采访中,你曾说过可以将这种技术想像在挖沟机,它可以挖洞,如果制造不当,也可能成为消灭人类的杀手。所以问题的关键在于在制造挖沟机时要让它成为挖洞能手,而不是敲掉你的脑袋。当你从事研究时,你会做出怎样的选择?

辛顿:我想我永远不会刻意去制造武器。你可以设计一台挖沟机,它可以成为消灭人类的高手。但我觉得这是技术的误用,我不会这样做的。

主持人:好的,Geoffrey Hinton,感谢你的精彩对话。信息很丰富。明年我们再来谈谈关于梦的第三种和第四种理论吧。

译者:小兵手

相关推荐

深度学习教父辛顿:未来神经网络可以重建人脑意识

马斯克的神秘公司Neuralink:连接人脑和 AI 的“读心术”

重建脑科学与AI之间的桥梁,人工神经网络比机器学习更优吗?

20条理由告诉你,为什么当前的深度学习成了人工智能的死胡同?

人工智能七十年 | AI十大里程碑:光影双面,相伴前行

Science子刊:人脑存在加速学习机制,算力赛过最新AI算法

特斯拉收购初创公司 专注自动驾驶“深度神经网络”

七年终登Science封面:最强大脑皮层神经网络重建,揭示迄今哺乳动物最大神经线路图

深度学习三巨头:AI需要新硬件,万亿突触神经网络或成可能

YC教父奥尔特曼的雄心:将通用人工智能引入现实

网址: 深度学习教父辛顿:未来神经网络可以重建人脑意识 http://m.xishuta.com/newsview6091.html