特斯拉 vs 司机:是谁在“自动”驾驶?

文|杜晨 编辑|VickyXiao

特斯拉最近又出了个大新闻:被美国国家公路交通安全管理局(NHTSA)要求在美国召回近5.4万辆汽车。

为啥?

这又是它的完全自动驾驶(Full Self-Driving)软件惹的祸:它有可能让汽车在路口的停车标志前缓慢前行,而不是完全停止。

在美国,所有司机都知道,一旦看到路口有停车标志,不管有没有看到其他车辆或者行人,司机都要先完全停下车,再继续前行。所以,特斯拉自动驾驶里的这个功能妥妥地违反了不少州的法律,而且有可能会增加车祸风险。

为什么特斯拉号称全智能的自动驾驶,在现实里,却这么多bug?当这些bug造成严重后果,承担责任的,是它,还是相信了特斯拉所描述的美好场景的司机?

司机or汽车:谁的错?

上个月,全球第一桩涉及到特斯拉 Autopilot 的严重刑事起诉,浮出水面。

此案当中的事故,发生在2019年的洛杉矶郊区 Gardena.

2019年12月29日深夜,司机 Kevin Riad 驾驶一辆特斯拉 Model S,从高速公路下匝道时,以较高的速度闯了红灯,并且撞上一辆正常行驶通过路口的本田小轿车。事故导致本田车上两人当场死亡,Riad 和特斯拉车上另一名女性乘客受到轻伤,目前已恢复。两辆汽车均已报废。

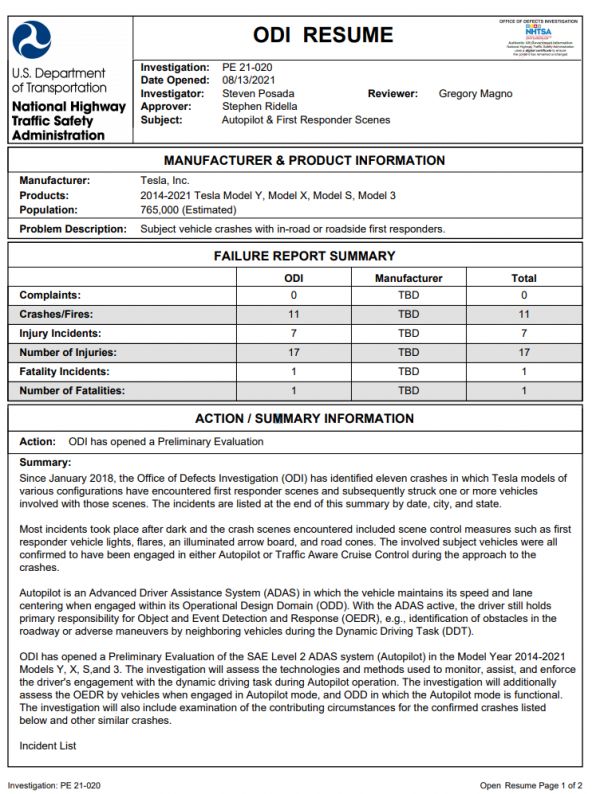

事后,美国公路交通安全管理局 NHTSA 宣布派出特别调查组。在此之前,这支特别调查组已经对十多起和特斯拉 Autopilot 功能相关的车祸事件展开了调查。

去年10月,加州检方正式对 Riad 发起了重罪指控 (felony charge),包括两项交通肇事致人死亡 (vehicular manslaughter) 的罪名。首次开庭安排在今年2月23日。

需要明确的是,本案的被告人是当时肇事车辆的司机。

尽管 Autopilot 技术无疑在事故中扮演了关键的角色,并且也将在本案的审理过程中被着重提及——但该技术本身,以及特斯拉公司,并非本案的被告。

(不过,美国联邦和各地监管部门,同时也在就 Autopilot 功能对特斯拉公司展开调查。)

图片来源:当地电视台 KCAL-9

此案也是目前全美已知的第一起涉及 Autopilot 功能,并且起诉对象为肇事驾驶员的重罪案件。这也意味着:即使司机认为汽车在“自动驾驶”,司机自己仍然是事故的责任人。

多位自动驾驶相关法律事务专家,包括南卡罗莱纳州大学法学教授 Briant W. Smith,和律师 Donald Slavik 等表示,这次加州公诉 Riad 一案,是第一桩涉及相关辅助/自动驾驶功能致人死亡的严重刑事诉讼案件。

除此之外车祸受害者的家人也已经分别向肇事司机和特斯拉公司发起了民事诉讼。受害者 Lopez 的家人在起诉书宣称,那辆 Model S 在事故发生时“突然加快到无法控制的速度”,并且指控肇事者 Riad 本人此前的驾驶记录非常不干净,属于“危险驾驶者”。这些民事起诉将作另案审理,和本次的加州公诉暂时无关。

自动驾驶 or 辅助驾驶?

如果你对电动车本身以及相关的技术行业有足够多的了解,你可能会知道,被特斯拉命名为“Autopilot”的这一功能,并非真正的“自动驾驶”系统。

本质上,Autopilot 就是很多汽车都有的辅助巡航功能的“升级版”,可以实现定速巡航、跟随车道、调整车速等操作。该功能从2019年4月之后的车型开始标配,无需额外付费;2016-2019年的车型均包含了 Autopilot 所需的硬件,需要付费才能激活。

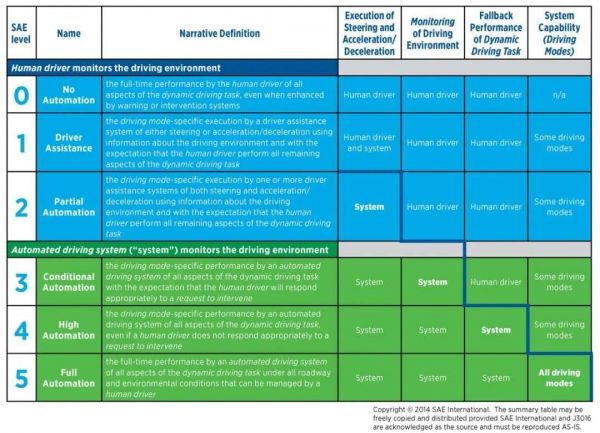

按照行业广泛接受的国际汽车工程师协会 (SAE International) 标准,Autopilot 处于 L2-L3 之间,并未达到公认的“自动驾驶”的水平。

比方说,SAE 标准(见下图)对于 L3 的一个重要指标,就是在特定情况下驾驶员可以无需关注路况;而特斯拉在功能说明和教学的时候也会告知车主,即使开始了 Autopilot 功能,驾驶员也仍需要保持注意力。

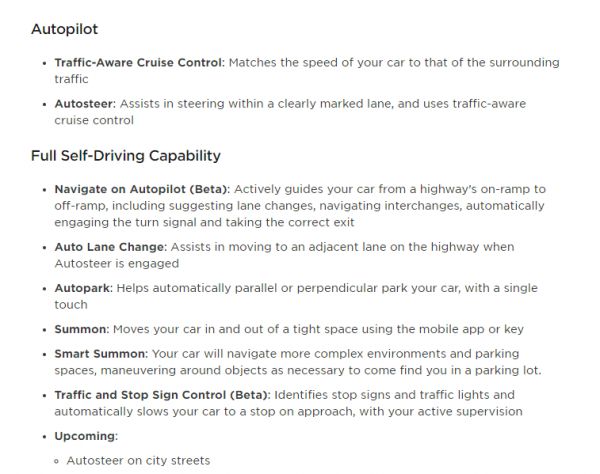

Autopilot 还有一个 FSD 模式,可以自动进行转换车道、根据周围交通情况自动调整车速、变换车道、驶入驶出匝道、自动泊车、根据信号灯/停车指示牌完成操作等更多功能。

FSD 的全称是 Full Self-Driving(完全自主驾驶),其中大部分功能均已商业化;少数功能仍处于公测阶段 (Beta),但也对市售车型的消费者开放,只要付费升级 FSD,即可开启。

然而,监管部门似乎并不认同特斯拉的说法和做法。

在加州公诉 Riad 一案中,NHTSA 直接发表声明,宣称:

1)尽管许多车辆都有辅助驾驶功能,在法律上,只有驾驶者本人才是责任主体。

2)所有的汽车,不管是否有部分自动驾驶功能,这些功能是否开启,都要求驾驶者必须保持全程的控制。(every vehicle requires the human driver to be in control at all times.)

3)没有任何的市售汽车能够实现自动驾驶。(no vehicle on sale that can drive itself.)

从 NHTSA 的表态中可以我们可以明确:截至目前,对于涉及到 Autopilot 以及类似辅助驾驶功能的交通事故案件,这些功能的确是事故发生的直接诱因。然而,监管部门的思路,仍然是将肇事司机作为责任主体和惩治对象。

不过,就前述的第三条来看,考虑到特斯拉公司和其高管过去曾在许多场合严重夸大 Autopilot 功能的实际能力和特斯拉自动驾驶技术的先进性——NHTSA 的声明,也直接驳斥了他们的口径。

2016年5月7日,美国俄亥俄州,一辆开启了 Autopilot 功能的 Model S 撞上一辆卡车。驾驶员当场死亡,Autopilot 在美国夺走了第一条生命。当时,该功能刚刚上线半年之久。

根据硅星人统计,自从该功能发布以来,全球已知确认与 Autopilot 功能相关的交通事故已经造成至少6人死亡、多人严重受伤。

美国国家运输安全委员会 NTSB(一个政府属性的民用交通事故调查机构),已经对至少28起特斯拉电动车伤亡事故展开特别调查。这些事故涉及包括 Autopilot、电池起火、刹车失灵等诸多因素。

去年,NHTSA 发布政府简报,宣布正式就11起涉及 Autopilot 的具体事故,对特斯拉公司,以及其推出的 Autopilot、交通感知巡航系统 (TACC) 等功能的设计能力,展开更加详尽的调查。

而在欧洲,特斯拉的过度宣传问题已经受到政府重视了。比如在德国,反不正当竞争监管机构在2020年起诉了特斯拉,指责 Autopilot、FSD 的命名和宣传行为构成了误导公众的行为,并且道路运行车辆开启这些功能,违反交通安全法规。

该案中,法院判定特斯拉败诉。从此,特斯拉被禁止在德国使用 Autopilot、FSD 之类的字眼,并且在营销宣传内容中也不得继续诱导消费者相信其在“自动驾驶”方面的能力。

要酷 or 要命?

很多硅星人的读者应该记得,在2018年,101高速的 Mountain View 路段,华人车主 Walter Huang 驾驶一辆 Model X ,在正常前进行驶中突然撞上了混凝土隔离带,不幸殒命。

当时,车上就开启了 Autopilot 功能,然而这辆高配 Model X 搭载的诸多强大的的传感器,和先进的道路扫描软件算法,都没能及时发现前方道路收窄,导致了事故发生。

相关调查显示,这位车主在生前已经几次对自己的妻子、家人和其它 Model X 车主吐槽过 Autopilot 功能不好用。具体来说, Autopilot 已经好几次把车往他后来丧命的那条隔离护栏上拐了。

Huang 生前在苹果担任工程师,然而就连他都没能对 Autopilot 功能局限有足够清楚的认识,就更别提那些非科技从业者,对电动车和辅助/自动驾驶技术不够熟悉的普通车主了。

很多车主选择特斯拉,看中的正是它的高科技属性,给人很“酷”的感觉。而 Autopilot,又似乎是人们期待已久的自动驾驶技术,在大规模市售车型中的最早也最高调的应用。

硅星人之前的一篇文章曾经指出,现在的问题就在于:包括特斯拉在内的的一部分电动车/新造车品牌,对相关的辅助驾驶功能进行过度宣传,夸大其能力,在用户的心中造成错误的理解,间接导致事故更加频繁的发生。

结果就是,某些压根没有达到自动驾驶标准的辅助驾驶技术,包装在自动驾驶的假面之下,非但没有让道路交通更加安全,反而酿成了更多事故。

欧盟新车安全评鉴协会成员、英国汽车安全专家 Matthew Avery 接受当地媒体采访时曾表示,特斯拉在 Autopilot、FSD 等功能的宣传上极具误导性,容易让那些对技术不太熟悉的消费者,误以为他们花钱升级了 Autopilot/FSD 之后,自己的汽车就获得完全自动驾驶的能力了。

“Autopilot 导致的许多事故都是致命的。这些司机究竟是在闹着玩,或者因为更糟糕的情况——他们真的相信 Autopilot 就是完全自动驾驶——我们无从得知。”

去年,特斯拉向一部分车辆推送了 FSD beta 9 测试版软件,让这部分车主给特斯拉提供路测数据。

但是一些车主很快发现,这一版本的 FSD 非常不稳定、不安全,会把月亮当成信号灯,还会时不时窜入自行车道。如果真的让这些车上路,它们毫无疑问将会成为严重的道路安全隐患。

消费者权益机构《消费者报告》(Consumer Reports) 发布了调查报告,宣称特斯拉推送的 FSD 测试软件缺乏安全防护,对其它道路参与者带来严重风险。

FSD Beta 9 将月亮误认为信号灯 截图来源:Jordan Nelson

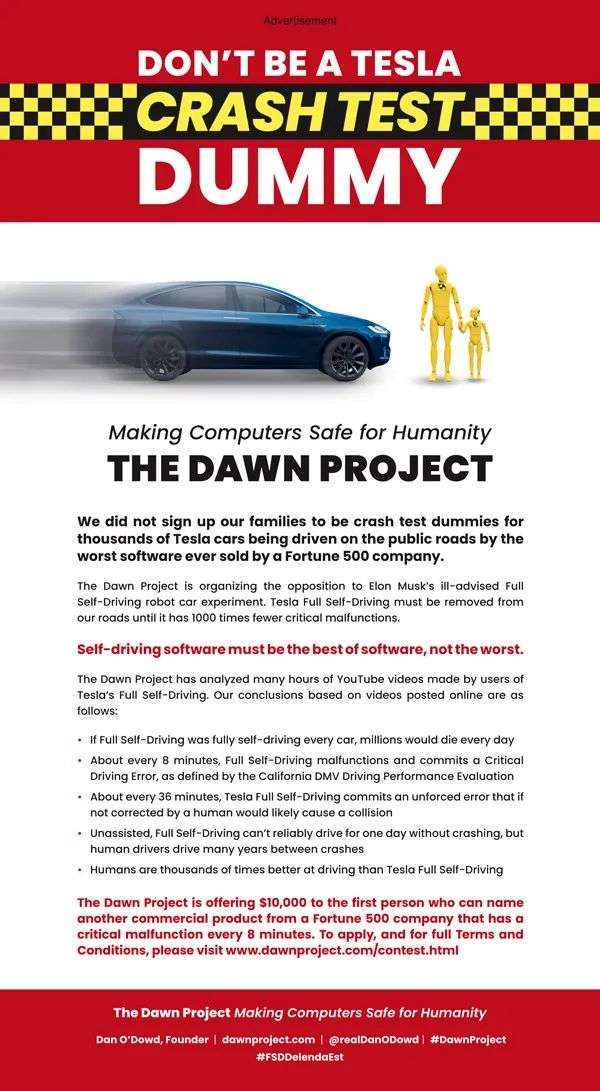

近日,一家名为 The Dawn Project 的社会公益机构,在《纽约时报》上刊登了一则整版广告,题为“不要成为特斯拉碰撞测试假人”,指责 FSD 功能的技术可靠性、安全性非常糟糕,特斯拉面向市售车型提供该功能,让车主成为路测“小白鼠”的做法是在草菅人命。

“一家《财富》500强公司,销售的数千辆汽车,运行着最糟糕的软件,在公开道路上行驶,而我们的家人将成为这些汽车碰撞测试的假人——这不是我们想要的,”广告写道。

卖了这么多年,特斯拉电动车的普及程度现如今已经非常高了,它的独特感、科技感,给车主身份增添的“酷”的标签,也不如从前了。

而我们在今天观察到的是:Autopilot、FSD 等实际是辅助驾驶,却被宣传夸大为自动驾驶的功能,正在延续着特斯拉作为一个“酷”品牌的生命。

然而,让车主对这些功能产生错觉,进而诱发更多的交通事故、生命和财产损失——这件事,可一点都不酷。

注:封面图和顶端题图来自于 KCAL-9、The Dawn Project 等机构,版权属于原作者。如果不同意使用,请尽快联系我们,我们会立即删除。

本文来自微信公众号 “硅星人”(ID:guixingren123),作者:光谱 杜晨,36氪经授权发布。

相关推荐

特斯拉 vs 司机:是谁在“自动”驾驶?

“自动”驾驶?别忽悠了

黑客曝光特斯拉有司机监控功能 可检测司机面部特征

马斯克“官宣”全自动驾驶,特斯拉成了异类?

特斯拉车载摄像头监控司机:用于自动驾驶启用时

特斯拉全自动驾驶来了,马斯克:我就是个「异类」

美国报告:特斯拉FSD全自动驾驶软件缺乏安全保障

美监管机构指责特斯拉和苹果忽视司机安全,称特斯拉系统不够完善

收智商税?特斯拉上线“全自动驾驶”软件包,卖1万美元

裸奔的特斯拉,也难以实现驾驶自由

网址: 特斯拉 vs 司机:是谁在“自动”驾驶? http://m.xishuta.com/newsview58603.html