Netflix是如何做决策的?(五):树立对决策的信心

神译局是36氪旗下编译团队,关注科技、商业、职场、生活等领域,重点介绍国外的新技术、新观点、新风向。

编者按:决策是行动的指南。不管是个人还是企业,每天都要面临着无数的决策。决策的好坏会对结果产生巨大影响,如何做好决策是每个人都要上的一门必修课。在Netflix这里,他们采用了一种以实验为导向的决策流程,先小范围地对不同方案进行测试,根据对比效果调整,从而摸索出普遍适用的决策。他们为此还在官方技术博客推出了关于Netflix如何用A/N测试做出决策的系列文章。本文来自编译,是系列文章的第五篇。后续文章还将介绍实验在 Netflix 中的作用、Netflix对基础设施的投资是如何为实验提供支撑和扩展的,以及 Netflix内部实验文化的重要性。

图片来源:Adobe

划重点:

合适的推理需要完整的报告与透明。

p 值或统计显著性并不能衡量效果的大小或结果的重要性。

科学结论与商业或政策决策不应该光看 p 值是不是超过特定阈值。

Netflix 是如何做决策的?(一):介绍

Netflix是如何做决策的?(二):什么是 A/B 测试?

Netflix是如何做决策的?(三):误报与统计显著性

Netflix是如何做决策的?(四):漏报与功效

在第 3 部分(误报与统计显著性)与第 4 部分(漏报与功效)里,我们讨论了支撑 A/B 测试的核心统计概念:误报、统计显著性与 p 值,以及漏报和功效。在本文中,我们将讨论困难的部分:在复杂的业务环境下,怎么运用测试结果来支撑决策?

关于 A/B 测试,我们需要面对一个令人不快的现实,那就是任何测试结果都未必潜在真相的反映。就像我们在之前的文章里面讨论的那样,好的做法包括先要设置并理解误报率,然后再设计出好的实验,从而有可能检测出合理且有意义的真实影响。这些统计学上的概念可以帮助减少并理解错误率,并在面对不确定性的时候做出正确决定。但特定实验的结果是误报还是漏报我们仍无法知道。

图 1:心存怀疑虽是一种不愉快的体验,但至少不像深信不疑那般荒唐——伏尔泰。

在用 A/B 测试来改进 Netflix 会员的体验时,我们发现有一点至关重要,那就是不要只关注数字(包括 p 值在内),还要用有力和合理的判断来解释结果,二者结合来确定是否存在令人信服的证据,能够说明新体验对于会员来说是好的。这些考虑因素跟美国统计协会在 2016 年的时候发表的关于统计显著性与 P 值的声明一致,以下三条直接引用(粗体)对我们的实验很有帮助。

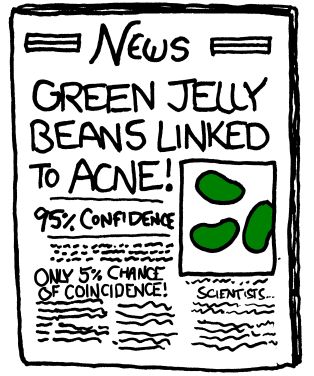

“合适的推理需要完整的报告与透明。” 就像我们在第 3 篇(误报与统计显著性)所说那样:,按照惯例,我们的实验将误报率设为 5%。在实践上,如果我们进行 20 次实验(比如评估 20 种颜色的果冻豆是不是都跟粉刺有关)的话,预计至少会得到一个显著结果——即便事实上每个实验的零假设均为真,并没有产生实际效果。这就是多重比较问题了,有很多方法可以控制整体的误报率,但我们不会在这里介绍。不过,最重要的是不仅要报告和跟踪产生了显著结果的测试结果,还要报告和跟踪那些没有产生显著结果的测试结果。

图 2:关于误报,你需要了解的一切都在这儿了。

“ p 值或统计显著性并不能衡量效果的大小或结果的重要性。” 在第 4 篇(漏报与功效)中,我们讨论了实验设计阶段做好设计的重要性,这样才能让A/B 测试有很高概率能检测出合理的、有意义的指标变化。在解释结果的时候也要有相关考虑。即便结果具有统计显著性(p 值 < 0.05),估计的指标变动也可能很小,以至于对 Netflix 会员的体验无关紧要,我们最好把精力放在其他领域的创新上。或者,扩展新功能的成本相对于收益而言也许过高,反不如不推出这项功能,而是把资金投资到改善其他领域的产品体验上,从而更好地为会员服务。

“科学结论与商业或政策决策不应该光看 p 值是不是超过特定阈值。” 本文的其余部分将深入介绍我们的决策实践,重点会介绍我们是怎么通过 A/B 测试全面评估证据的。

用数据为效果说话

在为了支撑决策而评估证据时,有一种比较实用方法,那就是想象自己是新产品体验的辩护律师,为它收集理由:看有没有有足够的证据得出结论说,除了那 5% 的合理怀疑之外,新产品体验产生了对会员有益的真正效果。为了帮助大号这桩案子,在解释测试结果时我们会向自己提出这样一些的问题:

结果跟假设是否一致?如果假设跟优化后端基础设施的计算资源有关,结果显示用户满意度在统计上有了显著提高的话,我们会持怀疑态度。结果有可能是误报——或者更有可能是实验执行中出现错误或bug的结果(Twyman 定律,任何看起来有趣或与众不同的数据通常都是错误的)。有时候结果虽然令人惊讶但却是对的,不过更有可能要么是实验执行错误的结果,要么是误报,这会促使我们深入去挖掘数据,找出根本原因。

指标的故事是不是连贯一致?在第 2 篇(什么是 A/B 测试?)中,我们介绍了因果机制,说到了通过这种机制,对产品所做的更改会影响到此次测试指定的次要指标与主要决策指标,并且介绍了这种机制的重要性。在评估测试结果时,重要的是要看这些次要指标的变化情况。一般来说,这些次要指标往往跟特定实验相关,从而可以评估主要指标的变化是否遵循了假设的因果链。比方说,通过十大榜的实验,我们想看看把十大榜放进来能不能提高作品级别的参与度,以及会员是不是会在主页找到的观看内容会比在其他地方找到的多。用户对十大榜的参与度增加,来自主页的播放增加,这些会帮助我们增强信心,即十大榜实际上是提高了会员的整体满意度的。相比之下,如果十大榜治疗组主要会员的满意度指标上升,但对这些次要指标的分析显示,十大榜所包含的作品的参与度没有增加的话,我们就会持怀疑态度。也许十大榜对于会员来说并不是个很好的体验,它的存在导致更多会员离开主页,增加了对Netflix 搜索的使用——结果神奇的是,整体满意度还是提高了(也许是因为搜索体验较好)。或者这也可能是一次误报。不管是哪种情况,次要指标的变化都会引发质疑,以至于尽管主要决策指标发生了变化,但我们没法很自信地得出结论,认为所做处理激活了假设的因果机制。

那有没有有额外的支持或反驳证据,比方说某种体验的类似派生存在一致的模式?在一项实验中测试一个想法的多个变种其实很常见。比方说,对于 Top 10 体验,我们可能会测试多种设计变体以及多种Top 10 榜中主页的摆放位置。如果Netflix 会员觉得十大榜体验很棒的话,我们预期在这些不同的变体当中,其主要和次要指标都能看到类似的收益。有的设计可能更好一些,但如果不同变体均产生广泛一致的结果的话,就有助于说明十大榜体验是有用的。反过来,如果我们测试了 20 个设计和摆放变体,其中只有一个的主要决策指标中发生重大变化的话,我们会更加怀疑十大榜的有效性。毕竟,在误报率为5%的情况下,我们预计平均而言智慧得到一个显著的随机结果。

结果是否可重复?到头来,要想对结果树立信心,最可靠的办法是看看结果在后续的测试里面是不是可以重复。如果一开始的 A/B 测试的结果具有启发性但不是决定性的话,我们一般还会继续测试,根据第一次测试学到的结果对假设进行改进。比方说,通过十大榜测试,我们可能会观察到部分设计以及放置选择往往会带来好的指标变化,其中部分具备了统计的显著性。然后,我们会改进这些最有希望的设计和放置方案变体,然后开始新的测试。如果上一次测试的体验比较少的话,我们还可以扩大规模,从而提高功效。还有一个策略,在产品变化很大的时候比较有用,那就是把胜出的治疗体验逐步推广到全部用户或会员,从而确认在 A/B 测试中看到的好处是真的,并确保没有产生意外的有害影响。在这种情况下,我们不是一下子向所有用户推出新体验,而是慢慢增加获得新体验的成员的比例,并观察与仍然接受旧体验的会员之间的差异。

与决策理论的关联

在实践上,每个人都有不同的框架,可以用来解释测试结果,做出决定。除了数据之外,每个人都会基于之前做过的类似的A/B测试,把自己的先验信息带进来,以及他们对决策的潜在收益和后果的评估所制定的损失或效用函数带来进。使用决策理论(包括贝叶斯决策理论),有多种方法可以将这些人类这些评估风险和收益的判断形式化。这些方法涉及到对做出正确或错误决策的效用做出正式评估(比方说,测算推出未能改善会员体验的代码变更的代价)。如果在实验结束时,我们还可以估算出每个处理组犯每一种类型错误的概率的话,就可以做出让会员的预期效用最大化的决策。

决策理论是吧统计结果与决策结合起来,所以是基于 p 值的决策方法的一个很吸引人的替代方法。不过,由于特定效用函数的细微差别,决策理论方法可能难以广泛应用到实验当中。虽然不完美,但我们在本系列文章所介绍的频率论假设检验方法(重点是 p 值与统计显著性),却是一个广泛易用的框架,可以用来解释测试结果。

解释 A/B 测试结果还有一个挑战,那就是对多个指标(主要决策指标和次要指标)的变动做出合理解释。关键挑战之一是指标本身往往不是独立的(也就是指标通常可能会朝同一方向或相反方向变动)。统计推理和决策理论一些更先进的概念也适用这里,而Netflix也在致力于研究给这个多维度指标的解释问题带来更多的定量方法。我们的做法是用贝叶斯推理把有关历史指标变动的分析信息纳入到分析里面,敬请关注!

最后,值得注意的是,不同类型的实验在决策过程中都要不同程度地引入人工判断。比方说,Netflix 采用了一种 A/B 测试形式来确保将新版软件安全地部署到生产环境。在面向所有会员发布新版本之前,我们会先做一个一个小型的 A/B 测试,让部分会员接收旧版代码,部分会员接收新版,确保错误或意外后果不会降低会员体验或基础设施的性能。对于这个用例而言,我们的目标是自动化整个部署过程,并运用遗憾最小化以及基于测试的决策等框架。通过自动部署新版,或者标记降低的指标给开发者,从而节省了开发人员的时间。

总结

本文描述了如何为产品创新寻找支撑理由的办法,那就是仔细分析实验数据,同时也指出了不同类型的测试需要引入不同级别的人工输入到决策过程之中。

在不确定的情况下做出决策(包括根据 A/B 测试的结果采取行动)是很困难的,而且我们在本系列文章里面所描述的工具很难得到正确应用。但是这些工具(包括 p 值)已经受住了时间的考验,就像美国统计协会主席在 2021 年关于统计显著性与可重复性的工作组声明中所强调的那样:“p 值与显著性检验的运用,若是得到正确应用和解释的话,是不应该放弃的重要工具。. . . [它们] 增加了从数据得出结论的严谨性。”

公开分享关键产品的测试结果,并对此进行辩论,这种概念在 Netflix 的实验文化里面已经根深蒂固,我们会在本系列文章的最后一篇中加以讨论。不过在下一篇文章中,我们将讨论 Netflix 不同的实验领域,以及聚焦实验的不同角色。

译者:boxi。

相关推荐

出海企业如何做战略选择和决策

贝索斯的决策方法论:当决策可逆时,当机立断

出海企业如何做战略选择和决策?

创业公司管理人员应该掌握的6个决策框架(上篇)

风险投资者如何做出决策?

决策智能化:人工智能时代的重要理论

我们到底能不能控制自己的决策?

创业公司管理人员应该掌握的6个决策框架(下篇)

彩色认知、黑白决策、灰度执行

做决策的时候,你脑子里在想什么?

网址: Netflix是如何做决策的?(五):树立对决策的信心 http://m.xishuta.com/newsview55502.html