7纳米制程、2.6万亿晶体管、比ipad还大,初创公司推「巨无霸」芯片

编者按:本文来自微信公众号“机器之心”(ID:almosthuman2014),作者:小舟、陈萍,36氪经授权发布。

全球最大芯片出第二代了!WSE 2 将于今年第三季度上市。WSE 2 采用 7 纳米制程工艺,晶体管数达 2.6 万亿个。

近年来大量芯片进入市场,旨在加速人工智能和机器学习工作负载。基于不同的机器学习算法,这些芯片通常专注于几个关键领域,但它们大多有一个共同的限制——芯片大小。

两年前,Cerebras 揭开了芯片设计领域的一场革命:他们研发了一款名为 Wafer Scale Engine(WSE)的芯片,拥有 1.2 万亿个晶体管,是英伟达 GPU Titan V 的 57 倍。WSE 的尺寸比一台 iPad 还要大。Cerebras 的「暴力美学」曾引发人们惊呼:「WSE 的晶体管数量已经超过人类大脑中的神经元了!」Cerebras 也因此在业界闻名。

今天,该公司又宣布其下一代芯片 Wafer Scale Engine 2(WSE 2)将于今年第三季度上市,采用 7nm 制程工艺,晶体管数量翻倍到 2.6 万亿个,含有 850000 个 AI 核心。

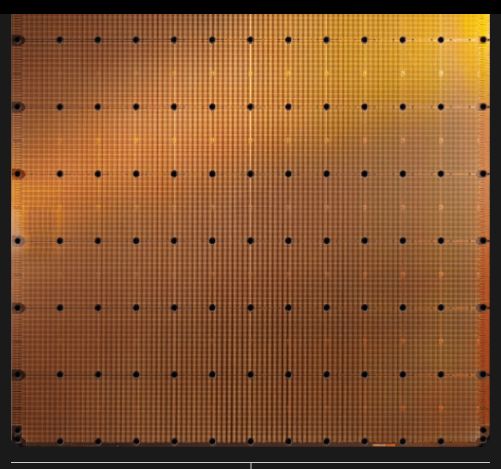

WSE-2:46225 平方毫米,2.6 万亿个晶体管。图源:https://cerebras.net/

Cerebras 一直致力于将机器学习问题逻辑解决方案的作用发挥到极致。2015 年 Andrew Feldman 成立该公司时,训练神经网络需要花费较多的时间,大型网络则需要数周。最大的瓶颈是数据必须在处理器和外部 DRAM 存储器之间进行多次传输,既浪费时间又消耗能源。WSE 的研发团队指出:我们可以扩大芯片,使它与 AI 处理器内核一起容纳所需的所有数据。随着自然语言处理、图像识别等领域的发展,神经网络也变得非常庞大,AI 领域需要一个非常大的芯片。有多大?尽可能大,这意味着是整块晶圆,46225 平方毫米。

CEO Feldman 表示:「当你想做出改变时,总是会遇到物理设计上的挑战。所有的东西都与几何有关。这真的很难,但台积电是我们非凡的合作伙伴。」

7 纳米技术的发展意味着巨大的进步,但据 Feldman 表示,该公司还对其 AI 核心的微架构进行了改进。他不愿透露细节,但表示在与客户合作一年多后,Cerebras 吸取了一些经验教训,并将其整合到新的核心中。

WSE 2:7 纳米制程工艺、2.6 万亿个晶体管

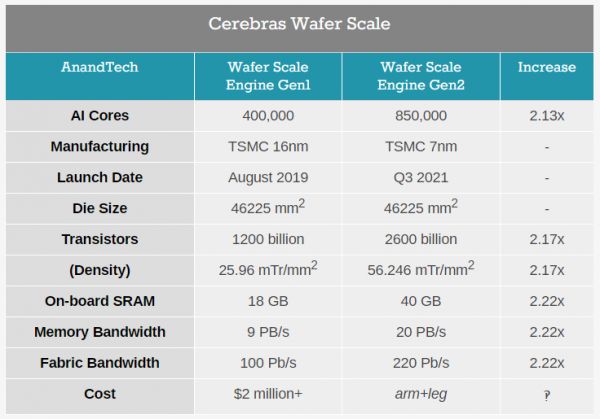

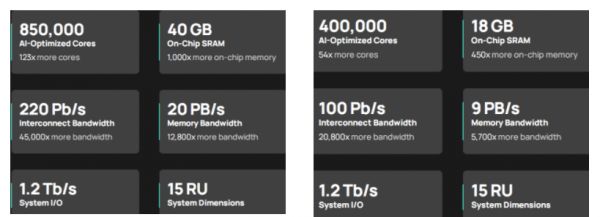

WSE 2 采用台积电 7 纳米制程工艺。这使得其可以按比例缩小,并能够在一定程度上缩小 SRAM,WSE 2 上具有 850000 个 AI 核心。WSE 2 的晶片尺寸与 WSE 保持一致,但几乎所有功能都翻倍增加,如下表所示:

与一代 WSE 一样,WSE 2 在 46225 平方毫米的硅片上拥有数十万个 AI 核心。WSE 2 拥有 850000 个核心,2.6 万亿个晶体管——相比之下,市场上第二大的 AI CPU 约为 826 平方毫米,拥有 0.054 万亿个晶体管。相比于 Ampere A100 的 40MB 内存,Cerebras 引入了 40GB SRAM 的板载内存,是前者的 1000 倍。

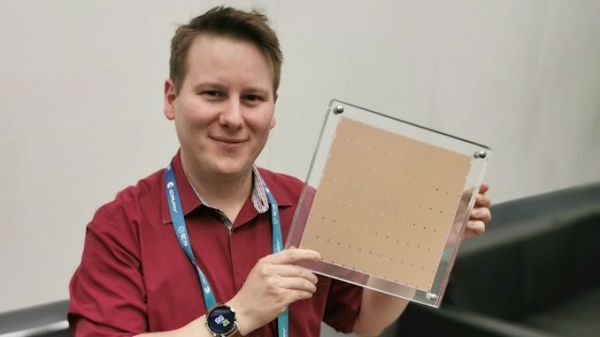

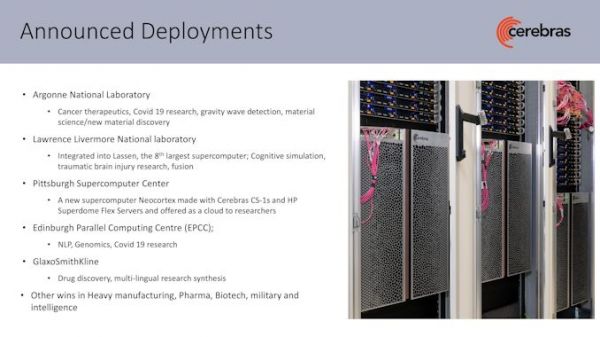

图中是 WSE 1,WSE 2 与其外观相同,但核心数量翻倍。

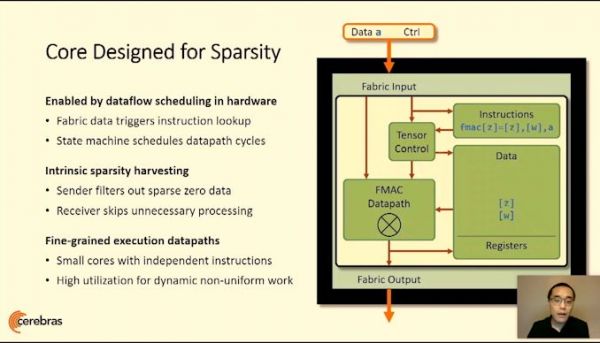

其核心通过一个带有 FMAC 数据路径的 2D 网格(2D Mesh)进行连接。Cerebras 与 WSE 的目标是提供一个通过创新专利设计的单一平台,该平台允许用于 AI 计算的更大处理器,现已扩展到更广泛的 HPC 工作负载中。

WSE 2 以第一代为基础

第一代 WSE 芯片拥有 1.2 万亿个晶体管,其数量是英伟达旗舰 GPU Titan V 的 57 倍,使用台积电 16 纳米制程工艺打造,面积 46,225 平方毫米,包含 400,000 个核心,片上存储高达 18G,功耗 1.5 万瓦(约等于 6 台电磁炉的功率),内存带宽 9PB / 秒,通信结构带宽 100PB / 秒。此外,第一代 WSE 还实现了 3000 倍的速度提升以及 10000 倍的存储带宽扩展。

WSE-2 设计的关键是自定义图形编译器,它采用 PyTorch 或 TensorFlow,并将每一层映射到芯片的物理部分,并允许数据流进行异步计算,拥有如此大的处理器意味着不会浪费能源。编译器和处理器在设计时也考虑到了稀疏性,无论批处理大小如何,都允许高利用率,或者允许参数搜索算法同时运行。

WSE 2 与第一代相比如何?

两者相比,芯片本身的大小没有改变,300 毫米仍然是大规模生产中的最大晶圆尺寸,因此 WSE 2 芯片的外形尺寸没有改变,但是 AI 核心翻了一倍。WSE 2 仍然被划分成一个 7×12 的矩形阵列。

WSE 2(左)与 WSE 1(右)对比。

此外,承载 WSE 2 的计算机系统 CS-2 也没有太大变化。CS-2 旨在实现快速、灵活的训练和低延迟的数据中心推断。目前,CS-2 由 WSE-2 提供动力,与其他数据中心 AI 解决方案相比,CS-2 具有更高的计算密度、更快的内存和更高的带宽互连,并使用领先的 ML 框架进行编程。

迅速成长的初创公司 Cerebras

Cerebras Systems 公司 2015 年在美国加州成立,联合创始人及 CEO Andrew Feldman 此前曾创立服务器芯片公司 SeaMicro。

Cerebras 联合创始人及 CEO Andrew Feldman

经过几年的迅速发展,该公司的规模已基本翻倍,在硅谷,圣地亚哥,多伦多和东京拥有约 300 名工程师。

参考链接:

https://www.anandtech.com/show/16626/cerebras-unveils-wafer-scale-engine-two-wse2-26-trillion-transistors-100-yield

https://www.chinaventure.com.cn/news/114-20190820-347306.html

https://cerebras.net/product/

https://spectrum.ieee.org/tech-talk/semiconductors/processors/cerebras-giant-ai-chip-now-has-a-trillions-more-transistors

相关推荐

7纳米制程、2.6万亿晶体管、比ipad还大,初创公司推「巨无霸」芯片

史上最大芯片诞生:1.2万亿晶体管超级巨无霸,专为AI设计

iPhone 12背后,5纳米芯片秘辛

英特尔又开始“挤牙膏”?7纳米芯片发布时间推迟

芯片制程之战:三星台积电挺进3nm,英特尔们呢?

芯片制程:28nm向3nm的“大跃进”

IBM的30亿美元芯片计划

英特尔推出10纳米制程芯片,这能帮其应对AMD和英伟达的挑战吗?

最前线 | 天数智芯云端7纳米GPGPU芯片产品BI及产品卡正式发布,将实现批量生产和商用

最大碳纳米管芯片、最大 AI芯片相继发布,芯片行业要变天了?

网址: 7纳米制程、2.6万亿晶体管、比ipad还大,初创公司推「巨无霸」芯片 http://m.xishuta.com/newsview42094.html