硬氪专访|商汤联创王晓刚带队具身智能新业务,要帮机器人重新理解真实世界

作者|黄楠

编辑|袁斯来

在AI行业,商汤科技已经是家成立11年的公司,早已习惯一次次浪起浪涌。

在视觉AI崛起的时代,它从港中文实验室跑出、叩开规模化落地的大门。但To B业务从来不是一份轻松活,包括商汤在内、绝大部分公司不得不应对客户长期定制化的开发需求。

直到ChatGPT横空出世,所有公司集体转向大模型。在算力层面先走一步的商汤,找到了施展空间。根据商汤年报,其生成式AI 2024年收入为24亿元,占比由2023年的34.8%提升至63.7%,成为商汤科技最关键的业务。

但大模型狂飙3年后,一个实际的问题出现:“除了特定场景的单点突破,AI如何真正走进物理世界、成为改变生产生活的实用工具?”

这也是商汤在每一次技术迭代中都在追问的核心命题。

随着具身智能成为下一代AI革命的主赛场,近日,大晓机器人公司成立,由商汤联合创始人、执行董事王晓刚出任大晓机器人董事长,正式入局具身智能战场。

王晓刚告诉硬氪,大晓机器人成立的初衷,并非是跟风“本体内卷” 或 “复杂技能炫技”,而是要回归真正的痛点,并提出“以人为中心(Human-centric)”的全新研究范式。在提供专注于构建能理解物理世界规律的“大脑”基础之上,最终输出一个适配真实场景需求的软硬一体产品。

这也是行业趋势。去年尚在探索移动稳定性与适用场景的具身智能行业,短短一年,已是截然不同的景象。有公司拿下动辄数亿元的订单,走进深圳、上海、苏州的机器人工厂车间,让具身智能不再只是To VC的故事。

AI技术演进正在从“数字智能”走向“物理智能”。身处其中的老牌AI公司们,会发现自己身处又一次重要转型中。

商汤2025年上半年净亏损为11.62亿元、同比下降50%,研发投入也还在增长,它需要找出更落地的方向。

通用智能的突破,不在于一步登天的AGI幻想,而是从真实交互中沉淀可复用的能力。机器人的终极价值不在于形态的酷炫,而在能否解决实际物理世界的难题。从视觉AI、大模型再到具身智能,商汤以大晓机器人为支点,正试图撬动的,不仅是一个千亿级的具身智能市场,还是AI与物理世界深度交互的可能。

以下是硬氪同王晓刚的对谈实录,内容经编辑:

不做单纯的具身大脑公司

硬氪:今年被普遍认为是具身智能落地元年。为什么商汤会选择在这个节点成立大晓机器人切入具身赛道?

王晓刚:主要基于产业化落地与技术范式两个维度的考量。

在产业化方面,具身智能是一个规模达数十万亿级、乃至更大发展空间的广阔赛道。正如英伟达创始人黄仁勋所言,未来每个人都可能会拥有一个或多个机器人,其数量有望超越手机,而单体价值可与汽车相媲美。

对商汤而言,过去我们聚焦To B软件领域,若要进一步扩大企业规模,实现软硬结合的业务升级,机器人赛道的垂直整合属性是重要突破口。同时,基于此前在各垂直行业的积累,团队理解用户痛点与需求,相较于对场景理解不足、难以解决实际问题的具身企业,商汤的场景落地能力更受期待,产业化推进速度也有望更快。

从技术范式来看,传统具身智能的发展存在明显短板。

机器人本体硬件发展迅速,但 “大脑”端的智能能力相对欠缺,核心问题在于采用了 “以机器为中心(Machine-centric)” 的技术路线;即先设计形态、参数差异巨大的各类机器人本体,再通过本体采集数据训练通用模型。这种思路并不成立,正如自然界中人与动物无法共享同一大脑,不同结构的机器人如灵巧手、夹爪、不同数量的机械臂等,也难以适配统一模型。

硬氪:大晓机器人团队所采用的技术方案有何差异性?

王晓刚:我们提出的是 “以人为中心(Human-centric)” 的新的技术范式。先研究人类与物理世界的互动方式、运动规律,通过穿戴式设备、第三视角设备等多元工具,结合视觉、触觉、力学等多维度数据,记录人类在真实生产生活中的行为、尤其是复杂的常识性行为。

通过将上述数据输入世界模型,让模型深度理解物理世界规律与人类行为逻辑,从而构建出强大的机器人“大脑”。同时,成熟的世界模型反过来还能指导硬件设计,让硬件形态更贴合实际应用需求。

今年八九月份,特斯拉、Figure AI等企业宣布摒弃真机路线,转向基于第一视角摄像头的视觉方案,但其本质仅是通过视觉记录人类行为,并未涵盖力、触觉、摩擦等关键维度,但这些维度正是具身智能与物理世界发生三维接触的核心需求。

仅靠视觉技术,机器人可实现跳舞、打拳等模仿类动作,但在挪瓶子、拧螺丝等需要与物理世界交互的场景中,难免面临技术瓶颈。

目前,大晓机器人所提出的Human-centric范式已得到了实践验证。此前,大晓机器人核心教授成员刘子纬教授团队合作构建了一个EGO life数据集,包含300小时第一视角与第三视角的人类真实行为数据;期间,基于该数据集研发的具身视觉模型,经实测,可以有效解决现有数据多为简单无意义行为、难以支撑复杂运动学习的痛点。

大晓机器人团队成员:一排从左往右依次为李鸿升、陶大程、王晓刚、潘新钢;二排从左往右依次为吕健勤、赵恒爽、刘子纬、刘希慧(图源/企业)

硬氪:公开数据显示,2024年中国具身智能市场规模已突破8000亿元,近两年具身领域涌入了数百家初创主体。在这一背景下,大晓机器人对自身在行业的生态位是怎么定义的?

王晓刚:大晓团队的最终目标,是输出软硬一体的产品,能针对性解决各场景下的实际问题,而不是单纯做模型的公司。

在这个过程中我们发现,现有硬件设计往往难以匹配场景需求,这也推动团队走上联合研发、定制化制造硬件的道路。

以机器狗产品为例,业内传统机器狗的摄像头视角窄、安装位置低,导致其在路口无法精准识别行进方向,过马路时难以捕捉红绿灯信号。我们与Insta360合作了一款全景相机模组,能实现360度全视角覆盖,解决视野局限问题。

此外,当前不少机器狗仍存在防水性能不足、算力平台成本高、续航能力有限等痛点,均无法满足实际场景的常态化使用需求。

硬氪:联合开发的具体落地中,双方的合作模式是怎样的?

王晓刚:我们的强项在于大脑端的模型、导航能力、操作能力。过去,公司虽然有B端的软件服务、大装置提供底层设施,但在端侧并未形成标准化的产品形态。

依托前两年商汤投资布局的多家本体硬件及零部件企业,大晓团队采用生态合作模式,提供硬件设计规范、跟伙伴联合设计和开发硬件本体;同时,在模型端我们也保持开放态度,提供基础模型和素材方案。

硬氪:商汤在安防、自动驾驶等领域有丰富的数据与技术沉淀,这些资源在向具身机器人领域迁移延伸时,哪些核心能力可以直接复用?

王晓刚:两方面的核心能力。第一是研发体系与安全标准。自动驾驶与具身机器人均需依赖海量数据驱动技术迭代,其沉淀下来的研发体系、数据闭环、数据飞轮经过验证,能有效提升机器人技术的迭代效率。同时,自动驾驶领域对安全性、数据质量的严苛标准,也可迁移至具身机器人的研发中,为产品可靠性提供保障。

第二,应用功能。我们在智慧城市中积累的方舟平台拥有上百种不同应用功能,以前主要服务于固定摄像头场景。如今,将其与具身机器人打通,当设备走到户外时,借助平台的后端分析能力就可以无缝迁移,拓展功能边界。

“一两年内,Human-centric将在机器狗中最先规模化”

硬氪:回顾商汤科技过去十一年,其恰好见证并参与了视觉AI大规模落地、到如今具身智能爆发的完整变迁。如何理解各阶段技术迭代的差异化路径及其背后的底层逻辑?

王晓刚:商汤的发展历程,清晰地勾勒了AI技术从1.0到3.0形态的演进脉络。

2014年公司成立之初,AI处于1.0时代,以人脸识别为代表实现技术超越肉眼的识别率。彼时的“智能”来源于人工标注,通过为图像添加标签,给原本无智能属性的图像注入 “认知能力”。

但由于标签信息量少、针对性强等局限,不同任务需单独标注对应的图像与视频,出现了“有多少人工就有多少智能”的情况。受限于数据维度,因此当时的模型不仅体量小,也很难实现跨场景、跨行业的泛化应用。

进入2.0大模型时代,情况发生根本性转变,核心区别在于数据本身所含的智能变多了。我们使用互联网上的文字和图文数据,一首诗、一篇文章、一段代码中,它记录了人类数千年积累的大量行为智能,远高于简单标签的智能含量。

大模型配合这些数据实现智能化爆发,使模型能够跨越不同场景和行业,具备较强的通用性。

然而,互联网数据的价值正逐渐被“榨干”,通用性的边际效应也逐渐放缓。

进入我们正在迈向的3.0具身智能时代,将转向与物理世界的直接交互。要构建理解世界物理规律、人类行为逻辑的“世界模型”,仅靠研读文字和图文数据远远不够,必须深入物理世界展开实际交互。无论是收拾房间、提供服务等具体场景,都蕴含着复杂的实时智能。通过与世界的直接接触与互动,AI将突破现有数据的局限,产生新的智能增长路径。

硬氪:从行业趋势观察,具身智能赛道的研发热度已从去年聚焦“具身大脑”,转向如今对“小脑”运控能力的探索,这一方向转变背后的本质原因是什么?

王晓刚:我认为核心原因是,大家的研究范式仍然是以机器为中心(Machine-centric)。

在这种范式下,机器的交互自然地变成了运控、即小脑,因为它与底层的硬件密切相关;然而,也正是由于不同的机器人本体采集的数据不同,导致无法形成通用的、统一的大脑。

其次是无法生成复杂活动。传统依赖真机操控采集数据的模式存在明显局限,只能生成拾取、移动、放置等十几秒钟就能完成的简单动作数据,但像收拾房间、提供服务等复杂的、需要长时间驱动的活动,是无法完成的。

这也佐证了我们提出以人为中心(Human-centric)、通过环境式采集来训练世界模型的必要性。

硬氪:与目前已有的世界模型相比,大晓机器人提出的“开悟”世界模型3.0 (Kairos 3.0),在底层的逻辑上有什么区别?它是如何解决物理世界幻觉问题的?

王晓刚:我们构建的世界模型与Sora、李飞飞World Labs团队提出的Marble等现有基于合成数据的模型不同,区别在于,开悟3.0采用了“多模态理解融合 — 合成网络 — 行为预测”三段式架构。

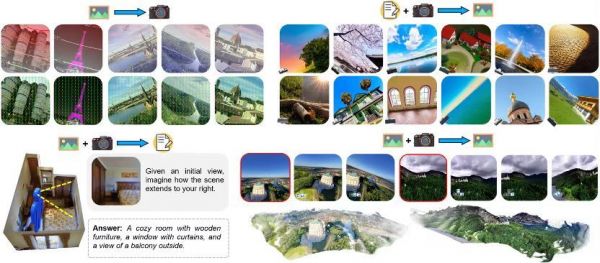

其模型统一了以相机为中心的多模态理解与生成,支持空间想象、并实现灵活的跨视角应用如世界探索(图源/企业)

我们的模型分为三个部分。第一部分是多模态理解与融合;现有模型主要依赖图像、视频及文字描述作为输入,而我们的输入体系更丰富,涵盖图像、视频、相机位姿、目标3D轨迹、触觉力学等多模态信息,这使模型能够更好地理解物理世界。

例如大晓与南洋理工的合作研究中,模型可通过单张照片反推摄像机位姿;当机械臂腕部摄像头捕捉到图像时,能精准定位机械臂位置,并根据图像变化反向推导机械臂的运动轨迹,实现对物理世界交互逻辑的深度理解。

第二个是合成网络;基于第一步的理解融合,开悟世界模型3.0可以合成各种视频,包括能选择不同类型的机器人进行操作任务的合成。

第三个是预测;接收指令后,模型能够预测机械臂下一步应该如何操作,从而指导机器人去操作。这使得我们的模型可以模拟动态场景,将动态目标分开,并能灵活地替换场景中的各种元素,比如换瓶子、换手机、换桌面、甚至换房型等。

这些都是现有的世界模型做不到的,真正从“认知与模拟”延伸至“实际执行”,形成从理解到操作的完整闭环。

硬氪:这种“以人为中心(Human-centric)” 范式在数据效率提升、跨场景泛化能力突破及多模态融合落地层面,具体如何解决行业核心瓶颈?

王晓刚:具体表现为“环境式采集 + 世界模型”的组合模式。这里的“环境”,特指人类所处的生活与生产场景,“世界模型”也聚焦于人与周边环境的交互规律,而非自动驾驶关注的道路场景或水下等特定领域。

Human-centric的优势是数据采集效率高,且所有数据均源自真实场景。同时,除视觉数据外,还整合了力学、触觉等多维度信息,人类多年积累的人体工程学成果,也能在此基础上得以应用,这是实现快速增长的前提,也是此前Machine-centric研究路径所不具备的。

硬氪:Human-centric有望在多长时间内,带来类似自动驾驶领域技术范式确立后的爆发式价值增长?

王晓刚:短期内,Human-centric在四足机器人(机器狗)将最先实现规模化应用。

当前业界的机器狗普遍受限于自主导航与空间智能能力,多依赖人工遥控或固定路线作业,应用场景被严重束缚。大晓团队的方案可以突破这一局限。

一方面,我们在设备上搭载了大晓机器人的自主导航技术,可通过机管平台实现多机协同调度,接收百度地图导航指令自主执行任务,还支持语言、多模态大模型等灵活交互方式;例如可根据指令识别特定人群提供帮助、拍摄违章车辆车牌号等。

另一方面,机器狗与商汤方舟视觉平台深度打通,能借助方舟的视频分析、目标检测、异常事件处理能力,识别打架斗殴、垃圾堆积、未牵绳宠物、违规无人机等场景化问题,并将数据实时回传后台。

这种“自主导航 + 场景智能识别”的组合,配合云端管理平台,可大幅增加其巡检等应用规模。一两年之内,我们能够看到机器人进入部分工业场景。

硬氪:具身智能的商业化落地正遵循梯度推进逻辑,从中长期来看,还有哪些场景值得重点关注?

王晓刚:中期来看,商业服务场景的前置仓物流将成为规模化突破点。

相较于工业场景存在的跨产线复制难问题,前置仓物流的需求具有高度一致性,随着线上购物的普及,各地闪购仓的分拣、打包等环节存在标准化的自动化需求。

目前行业的痛点是,前置仓内SKU数量多达上万种,依赖真机采集数据的传统模式难以覆盖。而我们通过环境式采集积累的海量数据,能有效训练通用模型,实现跨仓快速复制,满足行业规模化落地的核心诉求。

从长期视角出发,家庭场景将是具身智能的重要方向,但落地周期相对更长,安全性问题是核心挑战。机器人进入家庭后,需应对碰撞避让、物品安全等多重风险,类似自动驾驶从L2到L4的责任界定与安全保障难题。

不过,当前行业也在进行积极探索,例如Figure AI基于视觉路线开展环境式采集,与拥有上百万种户型的房地产基金合作,积累家庭场景中的人类行为数据,逐步实现全场景渗透。

相关推荐

“具身智能机器人”如何改变世界?

“万亿”具身智能的师徒“江湖”

巨头搅局具身智能,世界机器人大会看什么?

从地平线拆分后,地瓜机器人怎么做具身智能卖水人丨具身智能对话

清华成立具身智能与机器人研究院,张涛带队,孙富春任副院长

布局具身智能:京东向左,美团向右

世界机器人大会风靡,具身智能如何落地?

【关注】世界机器人大会开幕 具身智能机器人发展十大趋势发布

朱啸虎批量退出,具身智能是“泡沫”吗?

“大模型+机器人”,具身智能开启人机融合新时代

网址: 硬氪专访|商汤联创王晓刚带队具身智能新业务,要帮机器人重新理解真实世界 http://m.xishuta.com/newsview145275.html