DiT在数学和形式上是错的?谢赛宁回应:不要在脑子里做科学

本文来自微信公众号:机器之心 (ID:almosthuman2014),编辑:冷猫,+0,作者:机器之心

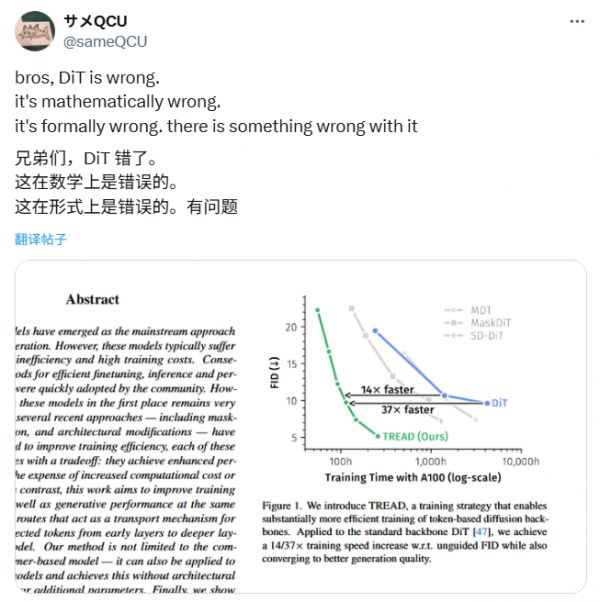

「兄弟们,DiT是错的!」

最近一篇帖子在X上引发了很大的讨论,有博主表示DiT存在架构上的缺陷,并附上一张论文截图。

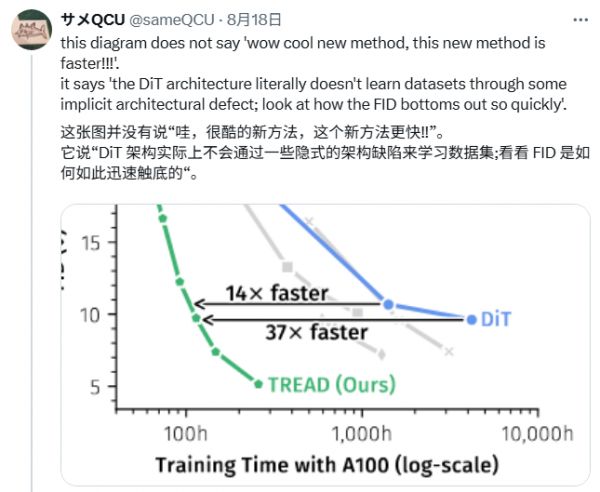

图1.我们引入了TREAD,这是一种能够显著提升基于token的扩散模型骨干网络训练效率的训练策略。当应用于标准的DiT骨干网络时,我们在无引导FID指标上实现了14/37倍的训练速度提升,同时也收敛到了更好的生成质量。

图中横轴代表训练时间(以A100 GPU的小时数为单位,log尺度,从100小时到10000小时),纵轴代表FID分数(越低越好,代表生成图像质量越高)。

博主认为,这个图的核心信息不是TREAD的速度优势,而是DiT的FID过早稳定,暗示DiT可能存在「隐性架构缺陷」,导致其无法继续从数据中学习。

博主提到的论文发表于今年1月(3月更新v2),介绍了一种名为TREAD的新方法,该工作通过一种创新的「令牌路由」(token routing)机制,在不改变模型架构的情况下,极大地提升了训练效率和生成图像的质量,从而在速度和性能上都显著超越了DiT模型。

具体而言,TREAD在训练过程中使用「部分令牌集」(partial token set)vs「完整令牌集」(full token set),通过预定义路由保存信息并重新引入到更深层,跳过部分计算以减少成本,同时仅用于训练阶段,推理时仍采用标准设置。这与MaskDiT等方法类似,但更高效。

论文标题:TREAD:Token Routing for Efficient Architecture-agnostic Diffusion Training

论文地址:https://arxiv.org/abs/2501.04765

代码:https://github.com/CompVis/tread

博主在后续回复中逐步展开了对DiT的批判,并解释TREAD如何暴露这些问题。

博主指出,该论文揭示了DiT模型的设计缺陷。具体来说,研究发现在训练过程中,如果将模型中的一部分计算单元替换为「恒等函数」(Identity Function)——也就是让这些单元什么计算都不做,仅仅是「直通」数据,相当于被临时禁用了——模型的最终评估分数反而会提高。

接着博主指出DiT的两个「可疑」的设计:

整个架构都使用「后层归一化」(Post-LayerNorm)

博主认为DiT使用了一种已知不太稳定的技术(后层归一化),来处理一个数值范围变化极其剧烈的任务(扩散过程)。

adaLN-zero

博主认为,这个模型虽然整体上自称是「Transformer」架构,但在处理最关键的「指导信息」(即条件数据)时,并没有使用强大的Transformer,而是用了一个非常简单的MLP网络(多层感知机)。

更具体地,adaLN-zero通过完全覆盖注意力单元的输入,并注入任意偏置来覆盖输出,这限制了模型的表达能力,相当于「讨厌注意力操作」(hate the attention operation),从而削弱了DiT的整体潜力。

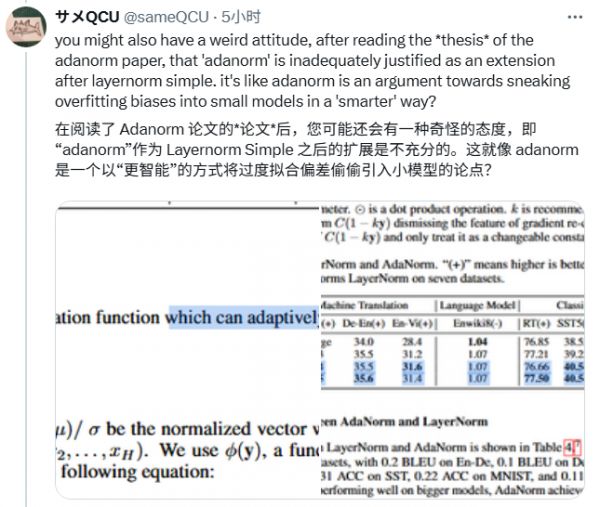

博主还提到与早期论文相关的LayerNorm研究,指出LayerNorm的偏置和增益参数可能对梯度调整影响更大,而非真正改善模型性能。他认为,adaLN-zero正是利用了这一点,名为「梯度调节」,实则像是在「给小模型偷偷注入过拟合的偏置」。

论文标题:Understanding and Improving Layer Normalization

论文地址:https://arxiv.org/abs/1911.07013

看了这篇帖子,DiT的作者,纽约大学计算机科学助理教授谢赛宁有些忍不住了。

在2022年,谢赛宁发表了DiT的论文,这是扩散模式首次和Transformer相结合。

论文标题:Scalable Diffusion Models with Transformers

论文链接:https://arxiv.org/pdf/2212.09748

在DiT问世之后,Transformer逐步代替原始扩散模型中的U-Net,在图像和视频生成任务中生成高质量的结果。

其核心思想是采用Transformer代替传统的卷积神经网络作为扩散模型的主干网络。

这一方法业已成为Sora和Stable Diffusion 3的基础架构,同时也确定了DiT的学术地位。

在DiT论文刚刚问世时,就已接连受到质疑,甚至以「缺乏创新」为由被CVPR 2023拒稿。

这一次面对DiT在数学和形式上都「是错的」的论调,谢赛宁发推做出了几点回应。

从字里行间来看,谢赛宁对这个帖子多少有些情绪:

我知道原帖是在钓鱼骗点击率,但我还是咬一下钩……

坦白讲,每个研究者的梦想其实就是发现自己的架构是错的。如果它永远都没问题,那才是真正的大问题。

我们每天都在用SiT、REPA、REPA-E等方法试图打破DiT,但这需要基于假设、做实验、进行验证,而不是只在脑子里扮演式地做科学……否则,你得出的结论不仅仅是错的,而是根本连错都谈不上。

也难怪谢赛宁语气有些不善,原帖博主的一些说法可能有些拱火的嫌疑:

谢赛宁也从技术角度对于原帖子提出的一些问题进行了回复,在对原帖的部分问题进行了反驳后,他也同样说明了DiT架构目前存在一些硬伤。

截至今天,DiT的问题:

tread更接近于stochastic depth,我认为它的收敛性来自正则化效应,这让表示能力更强(注意推理过程是标准的——所有模块都会处理所有token);这是非常有意思的工作,但和原帖说的完全不是一回事。

Lightning DiT已经是经过验证的稳健升级版(结合了swiglu、rmsnorm、rope、patch size=1),有条件就应该优先使用它。

没有任何证据表明post-norm会带来负面影响。

过去一年最大的改进点在于内部表示学习:最早是REPA,但现在有很多方法(例如tokenizer层面的修正:VA-VAE/REPA-E,把语义token拼接进噪声潜变量、解耦式架构如DDT,或者通过分散损失、自表示对齐等正则化手段)。

始终优先采用随机插值/流匹配(SiT在这里应该是基线)。

对于时间嵌入,使用AdaLN-zero;但遇到更复杂的分布(如文本嵌入)时,应采用交叉注意力。

不过要用对方式——采用PixArt风格的共享AdaLN,否则会白白浪费30%的参数。

真正的「硬伤」其实是DiT里的sd-vae:这是显而易见却长期被忽视的问题——它臃肿低效(处理256×256图像竟需要445.87 GFlops?)、不是端到端的。像VA-VAE和REPA-E只是部分修复,更多进展还在路上。

评论网友也对回应中提到的技术细节感兴趣,谢赛宁也都对相关疑惑做出了回复:

算法的迭代进步总是伴随着对现有算法的质疑,虽说所谓「不破不立」,但DiT仍然在擂台中央,不是么?

相关推荐

谢赛宁否认系Sora发明人之一:一点关系都没有

谢赛宁否认系Sora发明者之一:没有一点关系,不要误传了

技惊四座的Sora模型,参数只有30亿?

OpenAI首席科学家Ilya离开OpenAI了吗?

四款视频大模型5大场景测评:Sora到底有多炸裂?

数学和计算机领域有优势!华裔群体在AI战场展露锋芒

这只是开始的结束

36氪首发|「赛宁网安」完成2亿元C轮融资,目标成为网络靶场全球第一品牌

专注提供网络靶场产品及解决方案,「赛宁网安」完成8000万元C+轮融资

谢绍敏和谷爱凌

网址: DiT在数学和形式上是错的?谢赛宁回应:不要在脑子里做科学 http://m.xishuta.com/newsview140686.html