DeepFake又添劲敌:谷歌开源新数据集,将成为鉴伪存真的有力武器

编者按:本文来自微信公众号“将门创投”(ID:thejiangmen),36氪经授权发布。

From: Google等编译: T.R, Ace

From: Google等编译: T.R, Ace

深度学习的飞速发展让我们的生活在短短几年内发生了翻天覆地的变化。最新的生成模型让人们感受到了AI真正的魔力,可以合成从图像到声音甚至视频的各种复杂的数据。它们在各个领域有着广泛的应用,例如文本语音生成和为医学图像处理生成训练数据。

但技术是一把双刃剑,善恶总会在新技术上被表现得淋漓尽致。 前两年出现的DeepFake换脸技术就将AI伦理再次带入了风口浪尖的舆论漩涡。

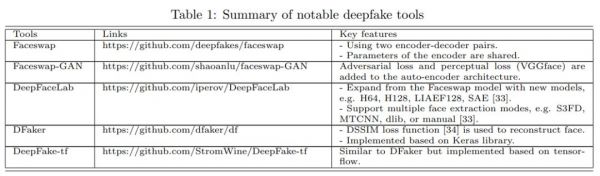

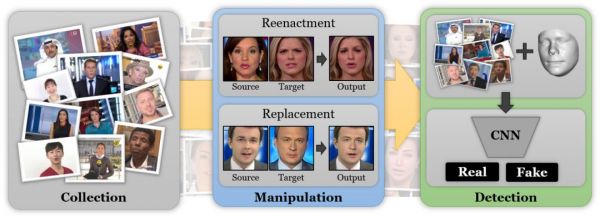

目前主流的运用DeepFake的几个工具

目前主流的运用DeepFake的几个工具自从2017年多个人脸生成模型开源后,网络上出现了大量的合成多媒体片段,其中大部分是为了搞笑和幽默,让不少明星和美国政客深受困扰。

而在中国,几周前一夜爆火的换脸视频ZAO充分迎合网友喜欢新鲜、热爱跟风的心理,利用换脸技术让普通人能变成明星或者跟自己的偶像同框演出。但是有些明眼人很快看出了问题,一张质疑用户隐私协议的朋友圈评论图又马上站在了跟风族的对立面。

吃瓜群众可能会觉得那些善意的提醒是过于敏感、小题大做。但当你了解过视频换脸可能造成什么后果之后,可能就不会觉得这是一件小事情了。

人们都利用DeepFake都做过哪些事情?

在打假之前,我们再来回顾下人们都利用DeepFake做过哪些“骇人听闻”的事情。

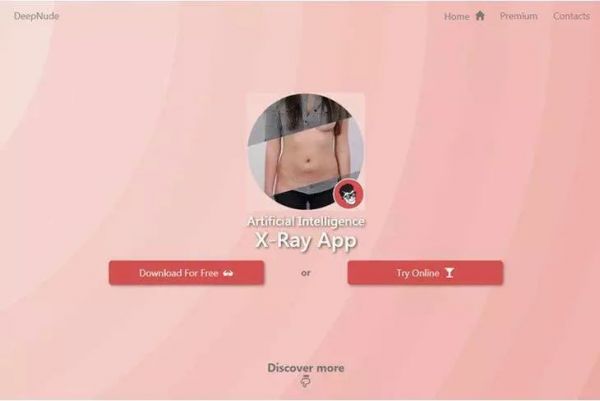

顶风作案,「AI将你看光光」上线几小时下架

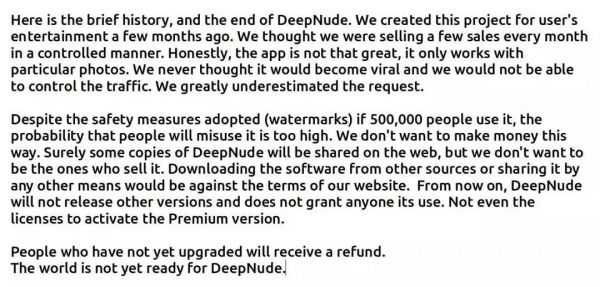

果然,上线几小时后这款APP便匆忙下架,但它下架的原因 并不是遭到大量抵制,而是因为太受欢迎? !创建团队在Twitter上表示,大家对于这个网站的热情真的大大超出了我们的预料…所以他们很有自知之明地停止出售和更新迭代,还警(qiu)告(qiu)大家不要再网上分享了。

果然,上线几小时后这款APP便匆忙下架,但它下架的原因 并不是遭到大量抵制,而是因为太受欢迎? !创建团队在Twitter上表示,大家对于这个网站的热情真的大大超出了我们的预料…所以他们很有自知之明地停止出售和更新迭代,还警(qiu)告(qiu)大家不要再网上分享了。 最后的结尾也透露除了一丝丝的不舍与无奈,DeepNude还是个孩子,世界还没有做好接受它的准备。

最后的结尾也透露除了一丝丝的不舍与无奈,DeepNude还是个孩子,世界还没有做好接受它的准备。色情视频造假,明星是受害者,也是对每个人的威胁

熟悉AI电影的朋友可能都知道《她》这部电影,斯嘉丽·约翰逊曾为这个美貌绝伦的AI助理配音,而DeepFake流行起来的这几年中,这位全世界片酬最高、被誉为最性感女星的“黑寡妇”自然成为无数匿名创作者的幻想对象,将她的脸拼接到很多影片的性爱场景当中。 在一次采访当中斯嘉丽坦率承认了对抗DeepFake被错误使用的案例非常困难,需要对多个国家和地区的相关视频合法性发起挑战。

在一次采访当中斯嘉丽坦率承认了对抗DeepFake被错误使用的案例非常困难,需要对多个国家和地区的相关视频合法性发起挑战。

互联网是一个巨大的黑洞,不停地吞噬自己。造假视频对我的影响没有很大,因为大家都知道色情视频里的人并不是我。真正可怕的是,在网络上暗藏着更多比这件事更令人恐慌的事情。

连美国政坛都敢碰?!

对于新兴技术,总有些人自诩有着更高的道德追求,不跟低俗的色情视频一般计较,转而将目光转向了国际政治领域,美国政坛首当其冲。

今年四月,利用DeepFake的造假视频展现美国前总统奥巴马用污言秽语侮辱其继任者特朗普。下图中左边的奥巴马其实是由右边的“替身”fake过来的。 再来看里根总统杯换上奥巴马的脸,也是毫无破绽,比六耳猕猴还像孙悟空。

再来看里根总统杯换上奥巴马的脸,也是毫无破绽,比六耳猕猴还像孙悟空。

普通的娱乐也就算了,更有甚者拿类似技术来进行间谍活动!比如下面这位来自俄罗斯的金发碧眼美女,非常符合美剧中艳美间谍的形象。

30岁左右,在顶级智库工作,拥有由高级专家和权威人士组成的关系网,与一名副国务卿、一位参议员高级助理和有望加入美联储的高级经济学家Paul Winfree都有connection。但美联社已确认,这位看似神通广大的美女并不存在,只是潜伏在LinkedIn上的大量虚假人物之一。这些虚假人物利用LinkedIn的庞大人脉网络,伪造出看似合理真实的身份,与他人建立联系、套取机密。

这下美国人真急了。众议院情报委员会在一份声明中表示:“DeepFakes 引发了有关国家安全和民主治理的深刻问题,个人和选民在评估他们在屏幕上所见内容的真实性时,无法再相信自己的眼睛或耳朵。”纽约州众议员 Yvette Clarke 提出一项新法案《DEEPFAKES Accountability Act》,要求任何创建合成媒体文件的人,必须用“不可删除的数字水印以及文本描述”来说明该媒体文件是篡改或生成的,否则将属于犯罪行为。

自此,滥用DeepFake技术的严重性已经不只限于对个人隐私的侵犯和骚扰,更有民众可能因为虚假视频造成的虚假新闻而影响对国内的民主和政治的舆论走势。美国国会正在担心如果不对DeepFake加以限制和禁止,将有可能影响2020年美国总统大选的走向,届时甚至将对现存国际体系造成影响。

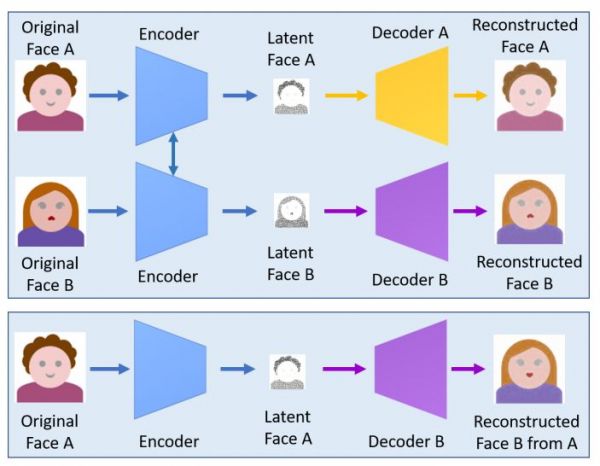

基于DeepFake的应用之所以层出不穷、日新月异,源于该技术本身并不复杂: 将A解码器接到B解码器就能得到一张假脸了。 识别虚假视频,谷歌开源数据集

识别虚假视频,谷歌开源数据集科学家们也在不断的进行深入研究,期待开发出高性能的合成视频检测方法以解决这个问题。谷歌一直认真对待这些问题,在去年《人工智能七原则》中提出:

我们致力于开发AI最佳实践,减少AI技术滥用所带来的伤害和滥用。为了促进这一领域的发展,谷歌发布了合成语音数据集,支持开发高性能合成音频检测的国际挑战赛,今年谷歌进一步开发了 合成视频数据集,期待为视频鉴别的发展贡献更多的力量。

通过与Jigsaw合作,谷歌发布了一个大规模的可视化DeepFake数据集,同时将合并到FaceForensics数据集中去。这一数据集将由慕尼黑工大与那不勒斯费德里科二世大学共同维护,并向全世界研究这一领域的科学家和技术人员开源。

数据集中包含了丰富的真实视频和合成视频数据。为了制作这一数据集,研究人员与众多演员录制了数百个视频,随后利用公开的DeepFake工具创造出了数千个合成视频。这些由真实视频和合成视频组成的数据集可以用于DeepFake的检测和识别。

在创建合成视频的过程中,模型随机选取两个演员的视频,并对他们的脸部进行不同程度的交换合成以获取庞大的合成数据。

上图显示了真实数据(上)和合成数据(下)的样本对,二者之间可能存在变化。合成数据的改变程度决定于拍摄视频的演员。

上图显示了真实数据(上)和合成数据(下)的样本对,二者之间可能存在变化。合成数据的改变程度决定于拍摄视频的演员。

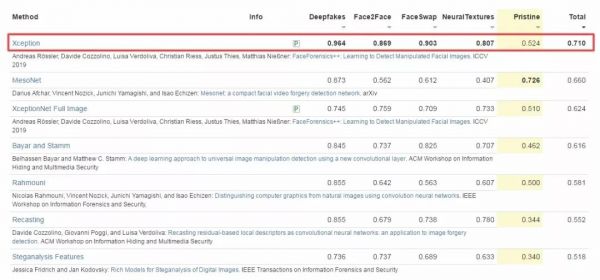

这一领域的发展十分迅速,世界各地的研究人员提出了多种方法来对合成数据进行检测。目前在这个数据集基准上已经有多个方法,最高的是Xception在DeepFakes方法上达到了96.4%的检测精度。

这一领域的发展十分迅速,世界各地的研究人员提出了多种方法来对合成数据进行检测。目前在这个数据集基准上已经有多个方法,最高的是Xception在DeepFakes方法上达到了96.4%的检测精度。

如果想上手训练自己的合成视频检测器,那就访问下面的网站获取数据吧:

https://github.com/ondyari/FaceForensics/

先前还有哪些尝试?

Google研究员不是第一批“视频打假卫士”了,让我们再看看之前还有哪些有益的尝试?

放大镜般识别面部细节,揪出缺陷

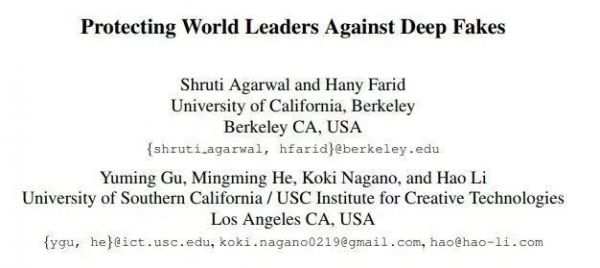

再天衣无缝的虚假视频也不可能比真的更真,来自加州大学伯克利分校和南加州大学的研究人员正是抓住了这一点,打造出一款AI识别系统,能从虚假视频制造者未能察觉的面部细节入手,“揪出”假视频。知己知彼、百战不殆,他们首先复盘了制造奥巴马假视频的全部过程,再训练AI来寻找每个人的“软性生物识别”标签。

什么意思?每个人在说话、行动时,都会在潜意识的指导下以独特微妙的方式移动自己的身体,头部、胳膊、手、眼球、嘴巴都会产生类似的运动。而这种潜意识里的运动正是DeepFake没有考虑到的事情,因此容易造成百密一疏。

这项研究在实验中准确发现假视频的成功率达到了92%,而研究人员表示,接下来他们打算通过识别人声音的节奏和特征来进一步提高AI识别假视频的成功率。可能是为了不忘他们的初心,正如研究的标题——《保护世界领导人免受DeepFake的伤害》。

简单两步算法,虚假图象无处遁形

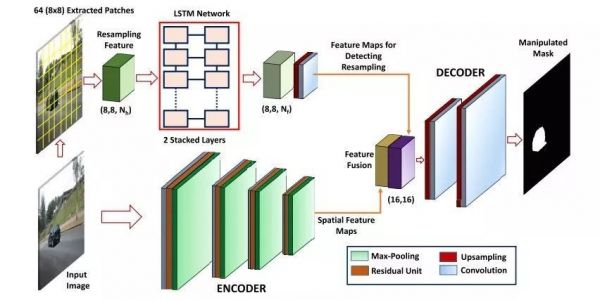

来自加州大学河滨分校的研究人员提出一种基于神经网络的方法,两步算法找出虚假图像。第一步,预处理目的是检测和裁剪,递归神经网络将问题中的图像分成小块(patch),将人脸排列在一系列的帧上,然后逐个像素地去观察这些小块。

第二步是区分处理过的和真实的人脸。通过一系列编码过滤器传递整个图像,然后算法把从逐个像素输出的结果和更高层次的编码滤波器分析结果进行比对。当这些并行分析在图像的同一区域触发红色标记时,就会被标记为“可能是DeepFake”。

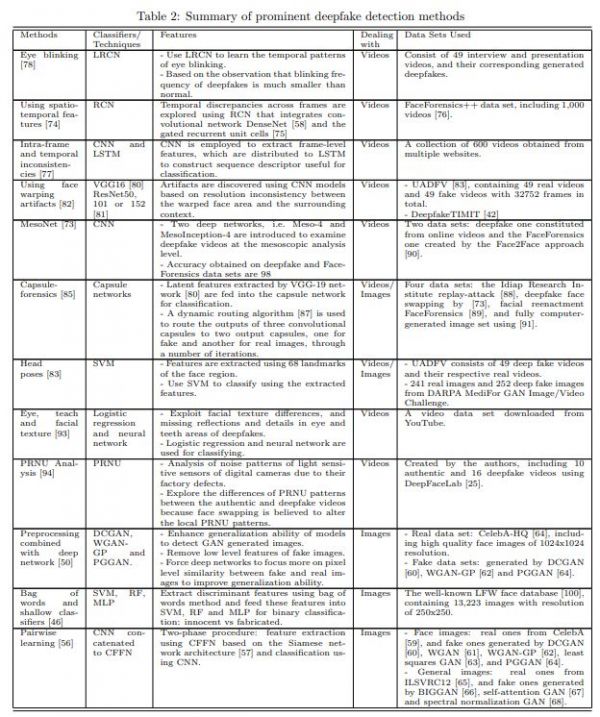

更多关于打假DeepFake的方法如下表总结:

强烈建议对该领域感兴趣的同学研读这篇论文:

强烈建议对该领域感兴趣的同学研读这篇论文:

https://arxiv.org/pdf/1909.11573.pdf

期待未来研究员们贡献更多脑洞大开的打假方法,毕竟有句话说得很耐人寻味:雪崩发生的时候,没有一片雪花是无辜的。

防微杜渐,人人有责。

参考资料

https://arxiv.org/pdf/1901.08971.pdf

https://arxiv.org/pdf/1909.11573.pdf

https://github.com/ondyari/FaceForensics/tree/master/dataset

https://github.com/ondyari/FaceForensics/

http://kaldir.vc.in.tum.de/faceforensics_benchmark/

https://jigsaw.google.com/challenges/

http://kaldir.vc.in.tum.de/faceforensics_benchmark/documentation

相关推荐

DeepFake又添劲敌:谷歌开源新数据集,将成为鉴伪存真的有力武器

为什么我们对deepfake技术又爱又恨?

一个模型击溃12种AI造假,各种GAN与Deepfake都阵亡

Deepfake AI换脸,一场“猫和老鼠”的追击战

Deepfake阴影下的“人脸识别时代”全面到来,我们可能遭遇什么危险?

推特发布首个反Deepfake策略草案:换脸一时爽?推文火葬场

迪士尼开发换脸技术,用deepfake拍电影可以安排了?

破局“眼见为假”: 谁在磨砺刺破Deepfakes之剑?

窥探神秘的Deepfake“军备竞赛”

谷歌发布世界最大任务型对话数据集SGD,让虚拟助手更智能

网址: DeepFake又添劲敌:谷歌开源新数据集,将成为鉴伪存真的有力武器 http://m.xishuta.com/newsview10570.html