新型AI工具允许艺术创作者掩盖个人风格,以防止被AI公司抓取

一种新工具可以让艺术家在他们的作品中添加不可见的像素变化,如果作品上传到网上,并被抓取到人工智能模型的训练集中,它可能会导致最终模型以混乱和不可预测的方式崩溃。

这款名为 Nightshade 的工具旨在反击人工智能公司,这些公司在未经创作者许可的情况下使用他们的作品来训练模型。

使用它来“毒害”这些训练数据,可能会破坏图像生成人工智能模型未来的迭代,包括 DALL-E、Midjourney 和 Stable Diffusion 等知名工具,其破坏方式是将模型的输出变得无用,例如将狗变成猫,汽车变成牛等等。《麻省理工科技评论》获得了该研究的独家预览,该研究已提交给计算机安全会议 Usenix 进行同行评审。

OpenAI、Meta、谷歌、Stability AI 等人工智能公司正面临着艺术家的大量诉讼,他们声称自己的版权作品和个人信息在未经同意或补偿的情况下被抓取。

美国芝加哥大学教授 Ben Zhao 领导了 Nightshade 的开发团队,他表示,希望借此来威慑不尊重艺术家版权和知识产权的行为,从而让权力平衡从人工智能公司转向艺术家。Meta、谷歌、Stability AI 和 OpenAI 没有回应《麻省理工科技评论》的置评请求。

Zhao 的团队还开发了一款名为 Glaze 的工具,该工具允许艺术家“掩盖”自己的个人风格,以防止被人工智能公司抓取。

它的工作方式与 Nightshade 类似:通过以人眼看不见的微妙方式改变图片的像素,再操纵机器学习模型将图像里的东西解释为错误的东西。

该团队打算将 Nightshade 整合到 Glaze 中,让艺术家可以选择是否使用“数据中毒”工具。该团队还将开源 Nightshade,这将允许其他人完善它并制作他们自己的版本。

Zhao 说,使用它并制作定制版本的人越多,这个工具就会变得越强大。大型人工智能模型的数据集可能包含数十亿张图像,因此被收入模型的有毒图像越多,该技术造成的损害就越大。

针对性攻击

Nightshade 利用了生成式人工智能模型中的一个安全漏洞,这个漏洞源于它们是在大量数据上进行训练的(在这种情况下,是从互联网上抓取的图像),而 Nightshade 可以搅乱这些图像。

(来源:STEPHANIE ARNETT/MITTR | REIJKSMUSEUM, ENVATO)

(来源:STEPHANIE ARNETT/MITTR | REIJKSMUSEUM, ENVATO)想要在网上上传作品,但又不希望自己的图像被人工智能公司随便收集的艺术家可以将作品上传到 Glaze,并选择用与自己不同的艺术风格进行掩盖。

他们也可以选择使用 Nightshade。一旦人工智能开发人员从互联网上获取更多数据来调整现有的人工智能模型或构建新的模型,这些有毒的样本就会进入模型的数据集,并导致模型出错。

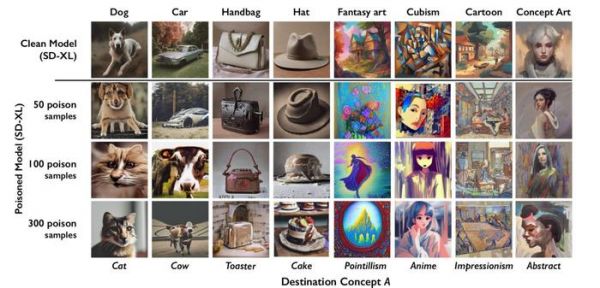

有毒的数据样本可以操纵模型的学习结果,例如,将帽子的图像识别为蛋糕,将手袋的图像视为烤面包机。被污染的数据很难删除,因为这需要科技公司大费周章地找到并删除每个有毒的样本。

研究人员在 Stable Diffusion 的最新模型和他们从头开始训练的人工智能模型上测试了这种攻击。当他们给 Stable Diffusion 软件训练了仅仅 50 张有毒的狗的照片,然后让它自己画狗的照片时,输出的照片开始看起来很奇怪,变成了有太多肢体和卡通面孔的动物。

使用 300 个中毒样本数据训练后,攻击者就可以操纵 Stable Diffusion,使狗的图像看起来像猫。

(来源:COURTESY OF THE RESEARCHERS)

(来源:COURTESY OF THE RESEARCHERS)生成式人工智能模型非常擅长在单词之间建立联系,这有助于“毒素”的传播。 Nightshade 不仅感染了“狗”这个词,还感染了所有类似的概念,如“小狗”“哈士奇”和“狼”。

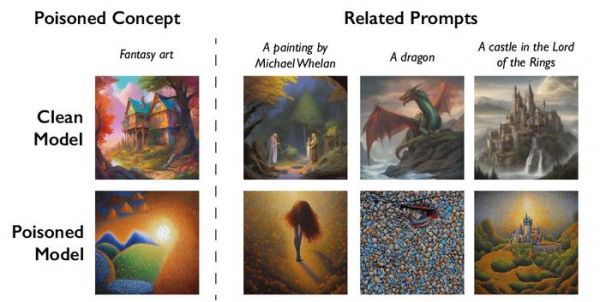

这种攻击也可以作用于概念相关的图像。例如,如果模型为提示“幻想艺术”抓取了一张有毒的图片,那么提示“龙”和“指环王中的城堡”也会被类似地操纵成其他东西。

(来源:COURTESY OF THE RESEARCHERS)

(来源:COURTESY OF THE RESEARCHERS)Zhao 承认,人们可能会恶意使用这种数据中毒技术。然而,他表示,攻击者需要数千个有毒样本才能对更大、更强的模型造成真正的损害,因为它们是在数十亿个数据样本上训练的。

我们还不知道针对这些攻击的强大防御措施。美国康奈尔大学研究人工智能模型安全的教授维塔利•什马蒂科夫(Vitaly Shmatikov)表示:“我们还没有在现实世界中看到针对现代(机器学习)模型的中毒攻击,但这可能只是时间问题。”什马蒂科夫补充道:“现在是时候加强防御了。”

加拿大滑铁卢大学研究数据隐私和人工智能模型鲁棒性的助理教授高塔姆·卡马斯(Gautam Kamath)认为,这项工作“非常棒”。他没有参与这项研究。

卡马斯说,研究表明,这些新模型的漏洞“不会神奇地消失,实际上它们只会变得更加严重。随着这些模型变得越来越强大,人们对它们的信任也越来越高,这一点将变得更严重,因为风险只会随着时间的推移而增加。”

强大的威慑

美国哥伦比亚大学计算机科学教授 Junfeng Yang 主要研究深度学习系统的安全性,但他没有参与这项工作。他表示,如果 Nightshade 能让人工智能公司更加尊重艺术家的权利,比如更愿意支付版税,那么它可能会产生重大影响。

开发了生成式文本到图像模型的人工智能公司,如 Stability AI 和 OpenAI,已经提出让艺术家选择不提供他们的图片来训练未来版本的模型。

但艺术家们表示,这还不够。插画家兼艺术家伊娃·图伦特(Eva Toorenent)使用过 Glaze,她说选择退出政策要求艺术家跳过各种障碍,同时仍然把所有的权力留给科技公司。

图伦特希望 Nightshade 能改变现状。

她说:“这会让人工智能公司三思而后行,因为它们有可能在未经我们同意的情况下拿走我们的作品,但这会毁掉它们的整个模型。”

另一位艺术家奥特姆·贝芙利(Autumn Beverly)说,像 Nightshade 和 Glaze 这样的工具给了她再次在网上发布作品的信心。在发现自己的作品在未经同意的情况下被抓取到流行的 LAION 图像数据库后,她选择了将自己的作品从网上删掉。

她说:“我真的很感激有这样一个工具,可以帮助艺术家们把处置自己作品的权力交还给他们自己。”

作者简介:梅丽莎·海基莱(Melissa Heikkilä)是《麻省理工科技评论》的资深记者,她着重报道人工智能及其如何改变我们的社会。此前,她曾在 POLITICO 撰写有关人工智能政策和政治的文章。她还曾在《经济学人》工作,并曾担任新闻主播。

支持:Ren

运营/排版:何晨龙

发布于:北京

相关推荐

新型AI工具允许艺术创作者掩盖个人风格,以防止被AI公司抓取

AI终结艺术

不足50元就能做一个“AI孙燕姿”,谁分到了AI音乐的蛋糕?

漫威新剧被骂惨,罪魁祸首是AI ?

AI巨头们,都在用盗版书籍训练模型?

我在AI训练库里,找到200多张周杰伦的照片

全球拒绝赋予AI知识产权,太过墨守成规?

看完 50000 张专辑封面后,AI 设计师疯狂输出

AI时代,一种新型创业公司形态即将到来

当人工智能成为艺术工具,人类的创造力如何长存?

网址: 新型AI工具允许艺术创作者掩盖个人风格,以防止被AI公司抓取 http://m.xishuta.com/newsview95193.html