蚕食OpenAI

本文来自微信公众号:未尽研究 (ID:Weijin_Research),作者:未尽研究,题图来自:《奇异博士》

很多人开始怀疑,GPT-4的服务变差了。人们原本把生成式AI当成实习生,常犯错误,但很勤快,指导一段时间就会足够胜任常规知识性工作。但最近几个月,很多人抱怨最优秀的“实习生”越来越笨了。为了验证他们的主观感受是否准确,斯坦福大学和加州大学伯克利分校研究发现,在数学与代码等任务上,它的输出质量确实比刚推出时要差。

一种猜测是,监管正在收紧,误伤了大模型。不说最严厉的欧盟——不仅严于律己,还在游说亚洲国家效仿——相对宽松的美国政府,也已经多次找这些顶级AI公司谈话。本周,OpenAI等七家公司面向白宫,自愿承诺未来会增加对安全、保障与信任的投入。不合理的安全过滤,可能影响质量,更多大模型公司需要直面这一症结。

另一种猜测则是成本削减,因为算力实在太稀缺太昂贵了;还有猜测它的能力,转移到更先进的“GPT-4.5”上了,逼着大家使用新功能。

OpenAI一直否认对自己的GPT-4动了手脚,表示会调查一下,到底发生了什么。尽管也有部分学界专家,质疑这篇论文不够严谨,但他们也承认,OpenAI缺乏必要的透明性,这使得结果不可重复也不可验证;部分业界专家则担心,在一个每隔几个月就会以完全没有记录和神秘方式变化的平台上,难以构建可靠的软件。

微软会只绑定OpenAI一个吗?本周,它尝试拥抱了Meta的Llama2。与OpenAI的封闭不同,这是一个开源模型,甚至允许商用。升级后的“大羊驼”,预训练语料库大小增加了40%,上下文长度翻倍,性能表现接近闭源的GPT-3.5。用户可以在Azure上配置Llama2,但那些坐拥超过7亿用户的巨头不行,那些想拿它来改进其他大模型的想法也不被允许。

差不多直接报谷歌的名字了。谷歌正在追赶,Bard开始接入旗下产品与服务,第一批9个,包括谷歌地图、Youtube等用户规模庞大的应用。谷歌还拥有安卓系统攒下的开发者生态。与OpenAI相比,它需要一个更强大的大模型留住他们。谷歌联合创始人谢尔盖·布林已经重返一线,开会,挖人,投身于GPT-4最强对手的Gemini的研发。

另一家拥有庞大开发者生态的巨头也有动作了。苹果正在研发Apple GPT,预计明年推出消费级产品。目前,主管这一项目的高管直接向库克汇报。

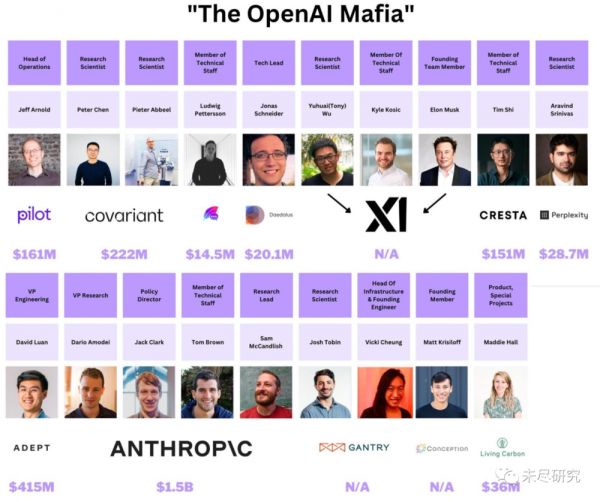

到目前为止,微软+OpenAI的产品服务仍是最好的。但从OpenAI离开的员工,也正在为全球用户提供更具竞争力的应用,仅披露的融资已经远超20亿美元。谁拥有更好的用户体验,解决市场痛点,谁就拥有未来。

中国大模型则在不断刷新各种榜单。IDC新发布的《AI大模型技术能力评估报告2023》,提到了14家企业,均来自中国本土。其中,百度拿下了11项中的7项满分,综合评分第一;阿里拿下了6项满分,服务能力第一。在缺乏面向普通消费者的产品与服务,企业应用场景也仍在合作试水的时候,外界近距离观察中国大模型,最直接的方式就是摸一摸各式各样的测评,还有企业的宣传,然后拼凑出一个大概的印象。

中国的开源模型是参与全球竞争的主力。在SuperCLUE开放式多轮测评上,最新发布的Baichuan-13B-Chat,领先国内的百亿级开源模型,接近GPT-3.5与Claude基础版。王小川透露,刚刚发布的Llama 2,有9个技术创新点,百川智能已经做到了6个,自己的下一个开源模型,一定会超越 Llama 2;百川智能还将在下半年发布一个1750亿级闭源大模型。他还指出OpenAI在大模型的应用方面正在遇到问题,应用的优势会在中国。

上周,还有这些发生在AI领域的事件值得关注:

一、风险、监管与伦理

OpenAI等向白宫承诺负责任地开发AI。美国白宫公告称,亚马逊、谷歌、微软、Meta、Anthropic、Inflection和OpenAI七家主要人工智能公司做出自愿承诺,强调了未来人工智能开发的安全、保障和信任的基本原则,包括对网络安全、歧视研究和新的水印系统的投资。此外,OpenAI内部备忘录显示,它愿意公开其用于训练图像生成器的数据;该公司还支持这样的想法:未来想要开发先进基础模型的机构需要获得政府许可。

欧盟游说亚洲国家效仿其AI监管。欧盟至少已与10个亚洲国家就管理人工智能的使用进行谈判,包括印度、日本、韩国、新加坡和菲律宾,但遭到冷遇。本周,新加坡发布了AI训练中个人数据使用指南草案,旨在阐明当公司使用个人数据训练人工智能模型和系统时,新加坡的法律将如何适用。但指导方针不具有法律约束力,也不会补充或改变任何现有法律。

谷歌披露“AI红队”信息。继提出安全人工智能框架(SAIF)后,谷歌披露其AI红队(Red Team)由一个黑客团队组成,他们模拟各种各样的对手,包括民族国家、高级持续威胁(APT)组织、黑客活动分子、个人罪犯甚至恶意的内部人员。谷歌发布报告,介绍了快速攻击、训练数据提取、模型后门、对抗性示例、数据中毒和泄露等演习清单。

WormGPT放大了大模型安全风险。网络安全公司 SlashNext 在研究生成式 AI 在网络犯罪方面的潜在风险时,发现了 “专为恶意活动而设计”的WormGPT。它在恶意软件相关的数据上训练,而且输出没有道德限制,可以被要求执行各种恶意任务。它生成的诈骗邮件,被系统标记为可疑邮件的可能性大幅降低。

逾8500名作家要求AI公司赔偿版权损失。玛格丽特·阿特伍德、詹姆斯·帕特森和强纳森·法兰森等8500多名作家签署一封信,要求微软、OpenAI、IBM、Meta、Alphabet、Stability AI等科技公司的领导者,如果没有获得他们的同意(consent)、署名(credit)和补偿(compensation),就不能使用他们的作品;不管是过去还是现在,在生成式AI程序中使用他们的作品,需要公平地补偿他们

二、中美科技巨头

微软宣布支持Llama 2大模型。在Microsoft Inspire大会上,微软宣布用户能够在Azure上轻松安全地微调和部署70亿参数、130亿参数和700亿参数的Llama 2模型,快速构建适用于自身业务的专用大模型。此外,微软还宣布Microsoft 365 Copilot全面商用,每位用户30美元/月;重视商业数据保护的Bing Chat Enterprise,5美元/月;Bing Chat支持多模态,推出图像搜索。

Apple GPT或于明年发布。该项目代号Ajax,因为它基于Google Jax机器学习框架构建,目前由机器学习和AI战略高级副总裁John Giannandrea和软件工程师高级副总裁Craig Federighi共同领导,两人直接向库克汇报。公司内部都将其称为AppleGPT,预计明年将推出消费级产品。

特斯拉洽谈将FSD技术授权给大型车企。马斯克称,就像北美充电标准(NACS)一样,特斯拉对将自己的FSD自动驾驶硬件和软件授权给其他汽车公司持开放态度,并且已经与一家大型OEM就使用FSD进行了早期讨论。

OpenAI推出“自定义指令”功能。当开启该功能之后,每次对话都会记住预先设定好的“人设”和回复的偏好。用户使用订制指令获得的信息,也将被用来优化模型性能,除非用户不启用该功能。OpenAI还将使用审核API,对订制指令进行审核,如果这些指令的回答违反了公司政策,ChatGPT可以拒绝保存这些指令。

谷歌正测试“负责任”的AI新闻写作产品。该工具内部代号为“Genesis(创世纪)”,已向《纽约时报》《华盛顿邮报》和拥有《华尔街日报》新闻集团的高管进行了演示。它可以接收时事新闻信息,并自动生成新闻稿件。谷歌认为,该工具可作为记者的个人助理,自动完成一些任务。谷歌还认为,该工具会非常“负责任”,能够帮助出版业者“远离AI陷阱”。

百度腾讯试水AI虚拟社交。百度在日本等地上线了名为“SynClub”的AI社交产品,用户可与专属于自己的AI虚拟对象沟通;腾讯音乐推出的未伴APP,允许用户根据自己偏好,创建AI好友。

三、大模型和行业应用

麦肯锡宣布与Cohere达成合作。AI大模型初创企业Cohere,将为咨询巨头麦肯锡的企业客户提供AI解决方案,涵盖金融服务、零售等各个行业,但没有透露客户公司名字。目前,多家咨询公司已拥抱AI。埃森哲宣布投资30亿美元;普华永道三年内投资10亿美元;贝恩咨询已与OpenAI合作;德勤与英伟达合作。

Stability AI推出以图绘图工具Stable Doodle。用户可以绘制简单的草图,细节优化、填色等任务则由AI完成,并按用户需求生成不同风格的图片。用户也可以通过文字对图片内容进行调整。

GitHub推出AI编程聊天机器人公测版。该公司宣布新的Copilot Chat功能,将通过微软的Visual Studio和Visual Studio Code应用程序,作为有限的公开测试版,向所有企业用户开放。该功能可以帮助开发者在几分钟内构建整个应用程序或调试大量代码,能够根据上下文感知输入到代码编辑器中的代码和任何错误消息。

LG发布多模态大语言模型EXAONE 2.0。该韩国公司的第二代大模型,专注于预防幻觉,数据集包括4500万篇论文、专利和文献以及3.5亿张图像。LG还推出了三个相关平台Universe、Discovery和Atelier,分别对应专业科研信息问答、新材料与新药开发、营销与艺术创作。

四、资金流向

Lepton AI已完成天使轮融资。开源深度学习框架Caffe创立者、原阿里巴巴集团副总裁贾扬清为联合创始人。创始成员来自机器学习社区ONNX联合创始人、分布式系统研发平台etcd的创始人等。该公司旨在建立高效的 AI 应用平台,已完成首轮天使轮融资,由Fusion Fund基金等投资。

Vellum.ai种子轮融资500万美元。这家公司致力于帮助企业改进生成式人工智能提示。该公司提供了一种并列比较模型输出的方法,还设计了提示分类,筛选适合输入大型语音模型的问题。目前已有40家付费客户,每月收入增长约25%至30%。

英伟达3亿美元入股Lambda Labs。Lambda labs是一家美国AI 云服务初创公司,宣传能提供全世界价格最低的英伟达A100、H100算力资源。本轮投资后,该公司估值可能超过10亿美元。年初,它获得了OpenAI 联合创始人 Greg Brockman的4000万美元投资。今年以来,英伟达已经投资了OmniML、Adept、CoreWeave、Cohere、Synthesia、Arm与Recursion。

Figure完成900万美元追加融资。这是一家开发多用途的人形机器人构建软件和硬件设施的企业。今年5月,该公司融资了7000万美元,本次获得英特尔资本的900万美元。

Causaly完成6000万美元B轮融资。该公司致力于帮助研究人员加速药物的开发和测试,希望根据不同的化学排列及在不同环境中的作用方式快速建模计算药物的疗效,从而降低研发失败的概率。

合肥发起聚焦人工智能的天使投资基金。该基金由合肥人工智能与大数据研究院联合科大硅谷引导基金组建,是安徽省首个专注于“下一代人工智能”“下一代工业软件内核”的天使投资基金。

美团入股大模型公司智谱AI。据36氪,清华系初创企业智谱AI已完成B-2轮融资,金额为数亿人民币,由美团战投独家投资,该轮投后估值为近5亿美金。该公司合作研发了双语千亿级超大规模预训练模型GLM-130B,还推出了认知大模型平台Bigmodel.ai。

铭顺科技完成超千万级别Pre-A轮融资。这是一家数字人私有化部署方案提供商,旗下产品包括数字人克隆系统、数字人直播系统、数字人短视频创作系统和声音克隆系统等。募集资金将主要用来加速公司AI驱动的数字人产品的迭代。

五、基础设施

台积电高雄工厂提前进入2nm制程。为了应对AI浪潮,台积电改变高雄建厂计划,由原来的成熟制程改为2纳米制程,预计2025年下半年量产。但目前台积电为苹果生产的3 纳米制程晶圆良率只有 55%。此前,有消息称,台积电开始准备为苹果和英伟达试产2纳米产品,预计2024年试产。

Cerebras和G42推出全球最大AI训练超算。AI芯片独角兽Cerebras Systems和阿联酋技术控股集团G42推出的全球最大的AI训练超级计算机Condor Galaxy 1(CG-1),拥有4EFLOPs算力,针对大型语言模型和生成式AI进行了优化。Condor Galaxy网络将会有9台互连AI超级计算机,2024年初会在美国再部署CG-2和CG-3,均为4EFLOPs算力。

高通下一代手机平台将支持70亿参数大模型。据该公司高管在2023世界半导体大会上的发言,AI计算将从云端逐步到云的边缘甚至终端迁移,高通正在推出能够支持超过100亿参数的大数据模型的新一代智能座舱平台,预计下一代手机平台将有能力支持50亿到70亿参数的大数据模型。

未来一年Dojo超算投入将超10亿美元。马斯克在财报电话会议上称,Dojo超级计算机正被设计用于处理大量数据,包括来自特斯拉汽车的视频,这些数据是创建自动驾驶软件所需要的。他预计将投入10亿美元,推进Dojo与神经网络训练。此外,目前特斯拉已经生产了10台Optimus机器人。

六、论文

Transformer的取代者? 微软研究院和清华大学的研究者,试图解决Transformer架构在进行并行计算时的低效推理问题,他们提出了retentive网络(RetNet), 引入了一种多尺度retention机制来替代多头注意力,它有三种计算范式:并行、循环和分块循环表征。实验结果表明,RetNet在scaling曲线和上下文学习方面始终具有竞争力。

此外,RetNet的推理成本与长度无关。对于7B模型和8k序列长度,RetNet的解码速度是带键值缓存的Transformers的8.4倍,内存节省70%。在训练过程中,RetNet也能够比标准Transformer节省25-50%的内存,实现7倍的加速,并在高度优化的Flash Attention方面具有优势。此外,RetNet的推理延迟对批大小不敏感,从而实现了巨大的吞吐量。

统一12种模态, 利用一个固定的编码器,在没有任何配对的多模态训练数据的情况下执行多模态感知。来自各种模态的原始输入数据被映射到一个共享的词元空间,允许后续具有固定参数的编码器提取输入数据的高级语义特征。

Meta-Transformer是第一个使用非配对数据执行跨12种模态统一学习的框架。在不同的基准测试中实验表明,Meta-Transformer可以处理广泛的任务,包括基本感知(文本、图像、点云、音频、视频)、实际应用(X射线、红外线、高光谱和IMU)和数据挖掘(图形、表格和时间序列)。Meta-Transformer标志着利用Transformer开发统一的多模态智能的未来前景充满希望。

LLama2, 改变大模型格局?Meta以Llama 1的预训练方法为基础,使用了优化的自回归Transformer,训练出了这个完全免费可商用的开源大模型。Meta执行了更稳健的数据清理,更新了混合数据,训练token总数增加了40%,达到2万亿;上下文长度翻倍。并采用了分组查询注意力机制。精调Chat模型是在100万人类标记数据上训练的。

以语言模型统一强化学习智能体:这个利用了大语言模型和视觉语言模型的框架,将语言作为智能体的核心,在这个统一的框架中,为了以语言形式描述从RGB相机获取的视觉输入,该研究使用了大型对比视觉语言模型CLIP,然后由语言模型进行推理并输出,产生行动指令。大语言模型可以探索、重用过去的经验数据、调度和重用技能以及从观察中学习。框架可用于释放机器人智能体的终身学习能力:连续学习的任务越多,学习下一个任务的速度就越快。

七、人才与其他

谷歌联合创始人谢尔盖·布林重返一线。布林去年底曾经在谷歌办公室参加有关AI的会议,但现在他参与的频率和强度都有所提高。布林与一群研究人员密切合作,打造谷歌AI模型Gemini。布林还涉及了人事事务,比如聘用抢手的研究人员。

OpenAI离职员工融资超20亿美元。据The Belamy统计,目前已有超过30位OpenAI高管/工程师/研究员等离职创业,而Chief AI Offcicer计算总融资超20亿美元。其中,Anthropic融资15亿美元,Adept融资4亿美元,Covariant融资2亿美元。

本文来自微信公众号:未尽研究 (ID:Weijin_Research),作者:未尽研究

相关推荐

蚕食OpenAI

起诉OpenAI

2万字复盘:OpenAI的技术底层逻辑

她35岁,OpenAI神秘CTO

马斯克硬刚OpenAI,殃及池鱼

谷歌内幕揭秘:被OpenAI抢占先机的原因,比想象中复杂

OpenAI正在杀死创业公司?

微软与OpenAI,远没有看起来“亲密无间”

谷歌和OpenAI,没有护城河

OpenAI成长史:冲突,抉择与权力斗争

网址: 蚕食OpenAI http://m.xishuta.com/newsview84259.html