又一届国际AI顶会被“攻占”:华人学者占据半壁江山,清华腾讯团队纷纷拿奖

就在今天下午,自然语言处理领域的顶级学术会议、有NLP界奥斯卡之称的ACL 2023 在加拿大多伦多揭晓了三篇”年度最佳“学术论文,其中有两篇都有华人研究者的身影。

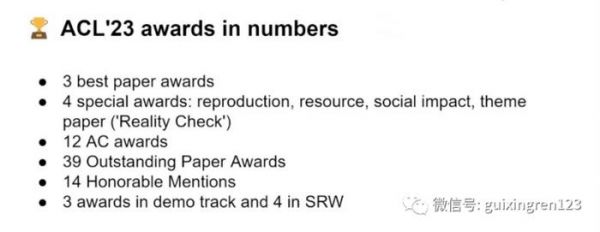

今年,除了最重磅的年度最佳论文由过去的一篇增至了三篇之外,ACL也大幅度增加了优秀论文的奖项设置和获奖比例,颁发了四大单项奖、39篇杰出论文和12大细分领域的最佳论文等奖项。ACL组委会表示,今年获奖论文达到了总提交论文数的1.5-2.5%。

作为对比,去年ACL所有获奖论文加总仅有12篇,获奖数量还不到今年五分之一,由此可见今年的ACL有多热闹!很多人甚至形容今年的ACL就像是AI圈的“火人节”,来自世界各地的AI研究者们都激情四溢,从7月9日开始,在加拿大多伦多进行着一场为期5天的AI狂欢派对。

值得注意的是,不仅是最佳论文,在此次的所有获奖论文中,有华人学者参与和由华人团队领导的研究几乎占据了半壁江山。

华人研究者成为ACL的“中流砥柱”

在39个杰出论文中,全部都由华人研究者组成的研究团队达到了六个,有华人参与的杰出论文占一半以上。这些研究者所来自的中国机构既有清华大学、复旦大学、南京理工大学等高校,也有华为、腾讯等大型企业。

在细分领域的主席奖中,来自清华大学和武汉大学的华人团队摘得了“情感分析、文体分析和论点挖掘”领域的最佳论文,来自中科大、北京交通大学、微软亚洲研究院的华人团队摘得了“自然语言处理应用”领域的最佳论文。除了这两个领域之外,其他4个的领域中也有华人研究者的身影。

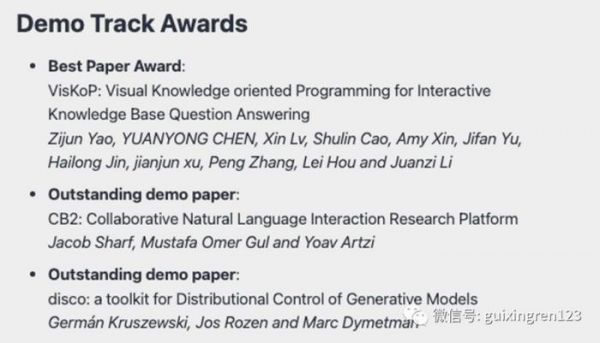

在最佳演示论文奖中,由中科大、清华大学、智谱AI、财智科技的研究者组成的团队斩获了唯一一篇最佳论文奖项。最佳学生研究奖项中,来自中国的学术团队也位列其中。而在四个特别单项奖中,有华人研究者身影的奖项达到了三个。

总体来看,无论是作为参与者还是研究领导者,华人研究者这次在ACL的存在感都特别强。

3篇年度最佳论文,分别都在研究什么?

本次获奖的三篇年度最佳论文包括:

Do Androids Laugh at Electric Sheep? Humor “Understanding” Benchmarks from The New Yorker Caption Contest论文作者:Jack Hessel(艾伦人工智能研究所), Ana Marasovic(犹他大学), Jena D. Hwang(艾伦人工智能研究所), Lillian Lee(康奈尔大学), Jeff Da(华盛顿大学), Rowan Zellers(华盛顿大学), Robert Mankoff(Air Mail and Cartoon Collections) 和 Yejin Choi(华盛顿大学)

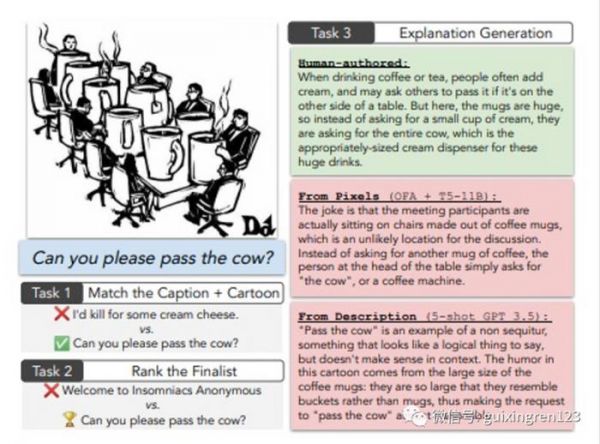

篇论文主要探讨了人工智能是否真正理解了幽默。研究者通过三个有关《纽约客》漫画标题比赛的任务来挑战AI模型,包括将笑话与漫画配对、识别出赢得比赛的标题,以及解释为什么赢得比赛的标题是有趣的。

研究团队表示,这三个任务的复杂度是逐渐进阶的,关键点在于测试AI对于图像和标题之间复杂性的理解,以及对人类经验和文化的模仿和应用。团队在研究中使用了多模态和单一语言两种模型进行测试,但最后研究发现,两种类型的模型在所有三个任务上都存在困难。

图片截自于论文正文

图片截自于论文正文例如,最好的多模态模型在匹配任务上的性能比人类低30个准确性点,即使提供了真实的视觉场景描述,人类编写的解释也在大于2/3的情况下优于机器编写的。但同时团队也指出,这个研究结果是在比较少的GPT-4模型下所得出的。

虽然这篇论文的作者分属于不同机构,但总体来看这也是一篇由OpenAI强参与的研究,论文作者中 Jeff Da, Rowan Zellers 和 Yejin Choi 都在 OpenAI 工作。

What the DAAM: Interpreting Stable Diffusion Using Cross Attention论文作者:Raphael Tang(康卡斯特应用AI团队), Linqing Liu(伦敦大学学院), Akshat Pandey(康卡斯特应用AI团队), Zhiying Jiang(滑铁卢大学), Gefei Yang(康卡斯特应用AI团队), Karun Kumar((康卡斯特应用AI团队), Pontus Stenetorp(伦敦大学学院), Jimmy Lin(滑铁卢大学) 和 Ferhan Ture(康卡斯特应用AI团队)

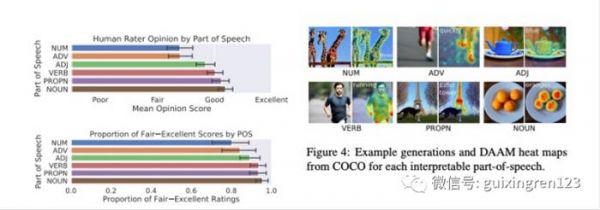

这篇论文主要关注了大规模扩散神经网络在文本到图像生成中的应用,研究团队认为虽然目前文本到图像模型已经取得了重要的里程碑式成就,但从学术研究的角度人们对它们仍然缺乏深入认知和可解释性分析。

为了解决这个问题,研究团队基于最近很火的开源模型Stable Diffusion进行了文本-图像归因分析。他们提出了一种名为DAAM的方法,通过放大和聚合去噪子网络中的交叉注意力单词-像素得分,以生成像素级的归因图。

图片截自于论文正文

图片截自于论文正文最后,他们使用DAAM研究了几种语义现象,重点是特征纠缠,其中,他们发现共同词素降低了生成质量,而描述性形容词关注得过于广泛。研究团队表示,他们的研究是首次从视觉语言角度来解释大型扩散模型,这可能为未来的研究开辟了新的道路。

该研究主要由全美最大有线电视、第二大互联网服务提供商Comcast集团的AI研究团队领导,在该研究团队中,有一半以上的作者都是华人。

From Pretraining Data to Language Models to Downstream Tasks: Tracking the Trails of Political Biases Leading to Unfair NLP Models论文作者:Shangbin Feng(华盛顿大学), Chan Young Park(卡耐基梅隆大学), Yuhan Liu(西安交通大学) 和 Yulia Tsvetkov(华盛顿大学)

这篇论文主要研究了预训练语言模型(LMs)中的政治偏见,及其对下游自然语言处理(NLP)模型公平性的影响。研究团队开发了新的方法来测量在多样化的数据源(如新闻、论坛、书籍、在线百科全书等)上预训练的LMs中的政治偏见,其中特别关注了仇恨言论和误信息检测这两个高风险的社会导向任务。

该研究的发现预训练的语言模型确实存在政治倾向,不仅加强了语料库中存在的极化,还将社会偏见传播到了仇恨言论预测和误信息检测器中,论文讨论了这些发现对NLP研究的重要影响,并提出未来的方向以减轻不公平性。

其中,根据公开信息显示,这篇文章的第一作者Shangbin Feng本科就读于西安交通大学,于去年开始在华盛顿大学攻读博士学位,师从Yulia Tsvetkov。

NPL界的顶流大会,孕育无数AI新技术、新业态

ACL(Association of Computational Linguistics)起源于1962年,源自美国一个小而专注的学术组织,其宗旨是推动计算语言学的发展。在当时,计算机科学才刚刚起步,人工智能更是还处于婴儿阶段的学术概念,但ACL早在60多年前就已经预见了的科技的巨浪,今年已经是第61届大会。

如今,在人工智能、特别是研究自然语言处理领域有四大顶级会议,分别是ACL、NAACL、EMNLP、COLING。而除了COLING 之外,其他三大会议均由ACL(Association of Computational Linguistics)主办。

几十年来,随着技术的进步和AI研究的深入,ACL逐渐发展成为全球最重要的自然语言处理领域的学术会议。作为AI领域里的“奥斯卡奖”一般的存在,ACL可以说是所有自然语言处理领域研究者们所向往和奋斗的方向。

ACL会议每年都会产生大量的顶级研究论文,推动了自然语言处理技术的快速发展,这些新思想、新技术往往也会被业界快速应用和商业化。最重要的是,ACL培育了一代又一代的AI领袖和研究者,是全球AI领域最重要的人才池。

ACL大会的举办地点在每年都会变化,遍及北美、欧洲、亚洲等地,以尽可能吸引全球各地的研究者参与,每年的会议地点都由ACL的组织委员会提前选定并公布。今年的举办地则放在了AI研究前沿、有“深度学习之父”Geoffrey Hinton坐镇的加拿大多伦多。

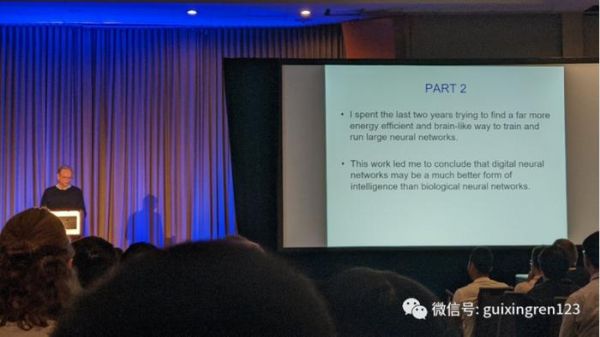

Geoffrey Hinton在ACL开幕上发表演讲,图片来自推特

Geoffrey Hinton在ACL开幕上发表演讲,图片来自推特或许是受AI浪潮的影响,今年的大会氛围尤其热烈。全球各地的AI研究者们前来“朝圣”和分享、交流,谷歌、微软、亚马逊、IBM等大型科技企业也都在ACL上设置了展位,跟研究者们进行面对面交流。

知名的专家和研究者将进行一系列的主题演讲,各国年轻的学者们也将对最新研究成果进行分享和研讨,参会者能够深入地参与特定主题。此外,ACL还设置了企业展示和招聘环节连接学术界和工业界,促进AI技术的落地转化。

发布于:北京

相关推荐

又一届国际AI顶会被“攻占”:华人学者占据半壁江山

又一届国际AI顶会被“攻占”:华人学者占据半壁江山,清华腾讯团队纷纷拿奖

NeurIPS 2019放榜:华人作者贡献42%,谷歌170篇屠榜;国内清华第一,腾讯领衔产业界

IEEE技术领域大奖公布:大陆唯一获奖学者来自清华

顶级AI视觉领域教授,朱松纯回国任教清华

清华最强本科毕业生Top10出炉:从没有什么天才学霸

清华最强本科毕业生Top10出炉,「从来没有什么天才学霸」

ICLR 2020 全析解读:华人作者贡献60%,谷歌、卡内基梅隆和清华大学领跑前三

1955-2019:从钱学森之问到AI突围

IEEE旗下AI顶会CVPR力挺华为:多位主席联名,支持自由审稿参会

网址: 又一届国际AI顶会被“攻占”:华人学者占据半壁江山,清华腾讯团队纷纷拿奖 http://m.xishuta.com/newsview82337.html