英伟达:CPU 已落伍,用 GPU 训练大语言模型成本可降低 96%

来源:品玩

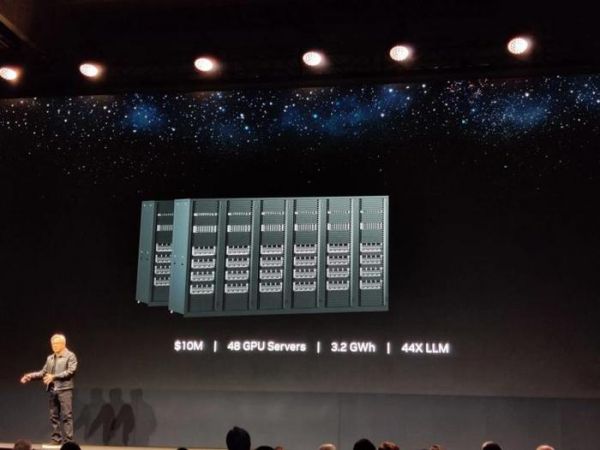

品玩 5 月 29 日讯,据英伟达在 2023 年台北电脑展会上的演讲,该公司宣称其 GPU 可以大幅降低训练大型语言模型(LLM)的成本和耗能。

黄仁勋在演讲中,向 CPU 行业发起了挑战,他认为生成式人工智能和加速计算是未来计算的方向。他宣布传统的摩尔定律已经过时,未来的性能提升将主要来自生成式人工智能和基于加速计算的方法。

相比之下,如果保持成本不变,购买一个价值1000万美元的GPU集群,可以在同样的成本和更少的电力消耗(3.2千兆瓦时)下训练44个LLM。如果转而保持电力消耗不变,那么可以通过GPU集群实现150倍的加速,以11千兆瓦时的电力消耗训练150个LLM,但这需要花费3400万美元,此外这个集群的占地面积比CPU集群小得多。最后,如果只想训练一个LLM,那么只需要一个价值40万美元、消耗0.13千兆瓦时电力的GPU服务器就可以了。

英伟达所要表达的意思是,相比 CPU 服务器,客户可以以 4% 的成本和 1.2% 的电力消耗来训练一个 LLM,这是一个巨大的成本节省。

发布于:江西

相关推荐

英伟达:CPU已落伍,用GPU训练大语言模型成本可降低96%

英伟达:CPU 已落伍,用 GPU 训练大语言模型成本可降低 96%

英伟达帝国的一道裂缝

为什么科技巨头纷纷选择英伟达AI,而GPU同样出色的AMD“无人问津”?

英伟达发布首个 CPU,集齐“三芯”叫板英特尔?

叫板英特尔,英伟达发布首个 CPU,集齐“三芯”!

教主黄仁勋亮相GTC China:英伟达已售出15亿块GPU,重磅发布TensorRT 7

十年磨一剑,英伟达能否掌控人工智能的未来?

揭竿而起,他们都想干掉英伟达

大模型热到芯片暴涨,阿里百度成了英伟达的打工仔

网址: 英伟达:CPU 已落伍,用 GPU 训练大语言模型成本可降低 96% http://m.xishuta.com/newsview76983.html