虚拟人是坐不了牢,但企业可能替它坐牢

出品|虎嗅ESG

作者|袁加息

头图|《底特律:变人》游戏截图

本文是#ESG进步观察#系列第021篇文章

本次观察关键词:负责任AI、可信虚拟人

AIGC大模型放飞了市场对虚拟人的想象。

给ChatGPT穿一个“皮套”,应该就是个很好用的虚拟人了。再想多一点,我可以拿自己所有的历史数据,训练出来一个我的虚拟分身,让这个“我”做我的秘书。分布式、定制化的AIGC,世界上每一个人都可以拥有一个虚拟分身。一些不重要的工作和社会交际,就让分身们在虚拟空间里面自动完成。

再往下设想,事情就会变得狂野。一个现成的担忧来自电影《流浪地球》:人类把太多决策交给了人工智能,结果人工智能掐指一算,发现干掉人类才是世界的最优解。

MOSS计算发现,保存人类文明的最优选择是毁灭人类。 | 图片来源:《流浪地球2》剧照

我们还没有为一个充斥着虚拟人的世界做好伦理上的准备。

这确实关系到虚拟人治理与合规的未来趋势。最近,官方开始把关注的目光聚焦于AI的应用层面。一个重要的事件是本月底,欧盟议会计划就《人工智能法》举行投票。而前日信通院发起的《可信虚拟人生成内容管理系统技术要求》标准制定项目,并且正在筹备《可信虚拟人白皮书》,更是把目标直指虚拟人AIGC。

虚拟人如果获得了更强大的智能内核,它应该遵循怎样的社会责任逻辑?

治理虚拟人,本质上还是治理真人

一位游戏从业者告诉虎嗅,“虚拟人有很多定义和应用场景,但归根到底虚拟人可以分成两种,有灵魂的和没有灵魂的”。

目前而言,虚拟人的“灵魂”是很贵的。它一方面需要技术的解决方案,另一方面需要内容方面的持续投入。在C端消费市场,“灵魂”或曰“人格”是虚拟人IP的核心竞争力:让虚拟人拥有一个好看的皮囊并不难,有趣的灵魂才能吸引粉丝持续地关注。这往往需要背后一整个内容的策划与生产团队,以及一些合格的“中之人”。部分虚拟偶像还需要用户共创和用户生成内容来起到充实人格的作用。所以它们的内核依然是PGC或UGC。此外,虚拟人要在表情、声音、动作、交互上显得有灵气,需要相当大的技术投入。在这些成本的约束下,即便是大厂旗下的虚拟人也不可能在以上所有方面都擅长。

虚拟人成为怎样一个“人”,这是个运营问题,而非技术问题——在目前以及可预见的将来都是如此。虚拟人的人格是由运营商、用户、中之人赋予的,技术只是实现的手段。于是针对虚拟人的治理,主要还是管理虚拟人背后的真人。

目前国内的互联网生态,已经开始处理这一类问题原初版本。比如在2020年,著名主持人何炅将一家技术公司告上法庭,原因是该公司的APP产品为用户提供了定制聊天机器人的服务,于是有用户用何炅的姓名和肖像“调教”出来一个聊天机器人。最终北京互联网法院认定,被告公司的产品不仅侵犯了何炅的肖像权,而且还对原告的人格自由和人格尊严造成潜在负面影响,判决被告赔礼道歉、赔偿损失。

聊天机器人也好,更复杂一些的AI应用也好,涉及到一些用现有逻辑就能解决的法律问题。监管和执法部门只需要把从前给传统媒体和互联网治理画的“红线”稍微再画长一点,就能把AIGC、虚拟人也涵盖进去。

2023年1月10日,网信办、工信部、公安部联合发布的《互联网信息服务深度合成管理规定》(以下简称为《规定》)开始实施。该法规的关键词“深度合成”(Deep Synthesis),指的是用深度学习或虚拟现实方法生成数字作品的技术,涵盖AI生成的文字、图像和声音,也包含合成人声、换脸、仿真空间等数字产品——这主要是AI领域在两年前出圈的应用,但也能够将AIGC纳入合规范围。

《规定》中的具体内容主要是从前监管要求的必要延伸。比如,传统上的信息服务,需要保证产品的信息安全属性,不侵犯他人的隐私、肖像权、人格权、知识产权;这些原则现在也按《规定》适用于深度合成的产品或者服务。类似地,《规定》还要求内容平台履行审核义务,保证平台上发布的深度合成作品符合法律法规、不危害国家安全和社会稳定。

从现有的新规和判例可以看到,虽然目前虚拟人在版权、人格权、内容安全等方面存在争议,但这些争议在多数情况下没什么好争的。线问题上,没有新鲜事。业内需要的只是一套明确的合规原则和责任认定,然后在各自的角色上继续开展工作。

商汤科技是AI数字人技术的一个领军企业,其发言人告诉虎嗅:“《规定》给出了比较符合当前业务逻辑的责任划分,为‘技术支持者’、‘内容提供者’及其他行业主体提供了比较明确的合规预期,并且也有助于规范市场,提升消费者的信心。”

不要被科幻带跑

担忧虚拟人伦理风险的言论很有市场。但杞人忧天的角色不适合由政府监管来领衔。虚拟人的社会责任探索,还是需要由企业和市场更自发地完成。这里面,企业社会责任有很大的发挥空间。

这里有一个新鲜出炉的反面教材:欧盟的《人工智能法》。这部法律草拟于2021年,即将在3月底(也就是本文发稿的几天后)拿到欧洲议会上投票。

但是,投不投票已经不重要了。因为ChatGPT的面世,已经颠覆了《人工智能法》的一部分初衷。比如,欧盟《人工智能法》提议禁止一些有悖人权的人工智能应用,比如某些人脸识别应用。但是像ChatGPT这种泛用途的生成式AI,很难用原有的立法思路去判定它的风险性。顺着《人工智能法》的精神,欧盟可以权且把GPT判定为“高风险AI”。但这无异于固步自封。

其实即便在ChatGPT问世之前,欧洲议会的议员已经提出反对意见,指《人工智能法》对AI的应用管得太细,将阻碍欧盟的科技创新。

一位AI伦理的研究者告诉虎嗅,其实欧盟的立法从2018年生效的《通用数据保护条例》(GDPR)开始,就已经对AI技术的发展产生实质上的阻碍作用了。很多技术企业由于这部数据安全法的限制,而难以实现技术上的创新。

《人工智能法》又一次实践了欧盟立法机构的行事风格:快速介入、保护人权、对技术保持充分的不信任。欧盟在AI技术还在急速演化的阶段,就仓促立法规范,导致《人工智能法》陷入如今的尴尬局面。这说明,现阶段的AI伦理方面的治理还是需要由企业来主导。

虽然立法和行政部门不宜在AI治理领域介入过多,但是法律的保守立场是一贯的。

具体到虚拟人议题上,法律在未来可预见的时间里,应该不会把AI和虚拟人当人看待。换句话说,再完善的人工智能,法律也不会认为它具备能动性和自主动机;AI和虚拟人牵涉的各种风险,最终都要追责到相关的个人或者组织头上。

这看起来或许非常不浪漫。在各种科幻作品中的人工智能造物,乃至真实投入市场的虚拟偶像、虚拟网红,都被营造出一种“有自己独立的想法和人格、能自主决策”的样子。但是从当下法学的主流态度来看,法律是不会把虚拟人当作责任主体的。虚拟人所犯的所有错误,都需要背后的技术供应商、内容供应商、运营商等实体来承担。我们短时间内不能指望虚拟人会依法承担任何责任,抑或享有任何经济和政治权利。虚拟人只是作品,一如你早上煎的鸡蛋也是作品。作品原本就不应和“坐牢”扯上关系。作品出了问题,只能是你的责任。

至此,我们可以把“如何给虚拟人一个合格的灵魂”这么一个浪漫的问题,简化成一个企业治理和社会责任问题。

负责任AI,一个企业治理话题

经过几年的讨论和积淀,人类对AI的一般伦理要求,通常总括为“负责任AI”(responsible AI)或“可信AI”(trustworthy AI)这两个概念。两个表述也可以套用到AI的各个子产物上。正如信通院要制定的那个标准,说的是“可信虚拟人内容生成”。

“负责任”或“可信”的总要求,又可以拆分成几条具体的原则。不同科技公司有不同的拆法,但基本上大同小异。就拿行业先驱微软为例,它把负责任AI归纳为6个原则:公平性、安全与可靠、隐私与数据安全、包容性、透明性、可问责性。

还拿《流浪地球》举例,电影中的MOSS人工智能通过常人无法理解的计算,得出“保存人类文明的最优选择是毁灭人类”的结论。从可信AI的原则上讲,MOSS首先是不透明的,是一个计算黑箱,很难看出她是哪根筋搭错了,才得出那样逆天的结论;同时也是不安全、不可靠、不可控的;最后她还是不可问责的,MOSS给作品中的人类社会造成种种问题,但人们却拿她一点办法没有。

电影中的这种AI很能创造戏剧冲突,但现实中的AI伦理工作,与其假想出这样一个逆天的AI,然后再感到茫然无措,不如从一开始就杜绝失控的苗头。

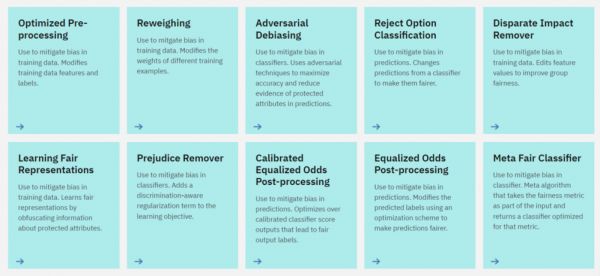

产业链上比较大的技术供应商通常都设有专门的AI伦理部门,他们依据对可信AI的原则拆分,开发出促进公平、安全、透明等特性的技术解决方案,并将方案开源。比如下图是IBM开源出来的一些促进AI公平性的算法。

来源:IBM可信AI官网

但技术远不是全部。正如信通院和京东探索研究院的《可信人工智能白皮书》所说,没有完美的技术,关键在于如何使用技术。

可信AI也是一套企业的工作方式,乃至是企业文化。微软在公司的负责任AI办公室网站上透露,团队在设计和研发AI产品时都会围绕前述的“负责任AI六原则”进行脑暴,分析可能的问题与疏漏,并且在运营中持续监测其表现。微软也建议AI的运营使用者也这么做。

单靠公司内部脑暴还是不够的。正如OpenAI的首席技术官Mira Murati在采访中表示,由于GPT是一个非常泛用的工具,开发者其实很难事先知道它的所有潜在影响力和缺陷。所以公司才将GPT的部分功能开放给公众,以探索这项技术的潜在问题。

可信虚拟人有什么特别的治理问题

具体到结合AIGC的虚拟人,会引发什么特殊的治理问题吗?目前业界存在一些社会责任思考,只不过这些思考的体系化和行业共识程度低一些。对此,商汤科技作为《可信虚拟人生成内容管理系统技术要求》的主要编制单位之一,向虎嗅透露了参与该项目的一些初衷。

关于可信虚拟人的特殊问题,商汤提到,当AIGC技术被用于虚拟人生成之后,尤其当拥有ChatGPT那样的智能交互能力之后,虚拟人可以实现“超写实”的效果。让人真假难辨的虚拟人,可能会放大相关的风险,加重给当事人可能造成的危害。在这种情况下,除了现行的AIGC管理方式之外,负责任的企业可以同时利用一系列技术方案来加固虚拟人的可信力度。公司希望今年就这个问题推进行业内达成共识。

据商汤科技介绍,在虚拟现实与元宇宙产业联盟(XRMA)中,成员企业一致认同“可信”问题是与产业发展同等重要的,技术推进与社会责任不可偏废。此外另一个共识在于“虚拟人不与现实脱钩”——AIGC不与真人的意愿脱钩,虚拟人的权属不与现实约束脱节,且产业不与监管脱节。这些共识,预计会在“可信虚拟人AIGC”以及今后的各个行业标准中,得到进一步的阐发。

相关推荐

虚拟人是坐不了牢,但企业可能替它坐牢

新加坡通过新法律:传播假信息,或坐10年牢

困在To B的虚拟人创业

虚拟人:「虚火」过旺

元宇宙,虚拟人To B赛道的照妖镜

2022,李佳琦的对手是虚拟人

AI换脸也算虚拟人?元宇宙不带这么玩的

数字孪生时代,崛起的虚拟人

百万代言费背后,虚拟人的“代言风口”来了?

普通人实现「虚拟人自由」

网址: 虚拟人是坐不了牢,但企业可能替它坐牢 http://m.xishuta.com/newsview69217.html