Netflix是如何做决策的?(二):什么是 A/B 测试?

神译局是36氪旗下编译团队,关注科技、商业、职场、生活等领域,重点介绍国外的新技术、新观点、新风向。

编者按:决策是行动的指南。不管是个人还是企业,每天都要面临着无数的决策。决策的好坏会对结果产生巨大影响,如何做好决策是每个人都要上的一门必修课。在Netflix这里,他们采用了一种以实验为导向的决策流程,先小范围地对不同方案进行测试,根据对比效果调整,从而摸索出普遍适用的决策。他们为此还在官方技术博客推出了关于Netflix如何用A/N测试做出决策的系列文章。本文是系列文章的第二篇。后续文章还将介绍支持 A/B 测试的统计数据、实验在 Netflix 中的作用、Netflix对基础设施的投资是如何为实验提供支撑和扩展的,以及 Netflix内部实验文化的重要性。

划重点:

A/B 测试是简单的受控实验

A/B测试仅改变受测项,其他一切都保持不变

一切都要从想法开始

Netflix 是如何做决策的?(一):介绍

A/B 测试其实就是一个简单的受控实验。比方说,我们做出了一个假设!— 我们想知道一种把 TV UI 里面所有的盒子都倒置起来的新产品体验对我们的会员是不是有好处。

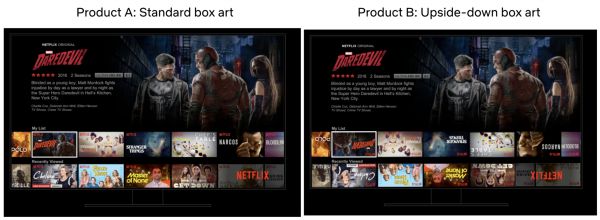

图 1:我们是怎么确定产品体验 B(倒置的的盒子艺术)对我们的会员来说是不是会体验更好

为了进行这个实验,我们会取出会员的一个子集,这通常是一个从所有会员中随机提取的简单样本,然后采用随机方式将将该样本平均分配成两组。“A”组(通常叫做“控制组”)看到的仍然是基本的 Netflix UI 体验,而“B”组(通常称为“治疗组”)会给予改进该会员的特定体验的假设获得不同的体验(后面还会谈到具体的假设)。在本例中,B 组收到的是倒置的盒子艺术。

接下来我们就是等,然后把 A 组中的各种指标跟 B 组中的各种指标进行对比。部分指标会跟特定假设相关。对于 UI 实验来说,我们会研究跟新功能的各种变体的互动情况。对于旨在在搜索体验当中提供更相关结果的实验,我们会衡量会员是不是通过搜索找到了更多的可观看内容。在其他类型的实验里,我们可能会关注更加技术性的指标,比方说应用加载所需的时间,或者我们在不同网络条件下所能够提供的视频质量情况。

图 2:一个简单的 A/B 测试。我们利用随机分配将 Netflix 会员的随机样本分为两组。“A”组收到的是当前的产品体验,而“B”组收到的是我们认为会改进Netflix 体验的变化。在本例中,“B”组收到了“倒置”的产品体验。然后我们再对比两组之间的指标。至关重要的是,随机分配确保了就平均而言,两组之间的其他一切都保持不变。

通过包括倒置的盒子艺术这个例子在内的众多实验,我们需要仔细思考指标告诉了我们什么。假设我们审视的是点击率,这个指标衡量的是每一种体验下点击了一部作品的会员占比。光靠这个指标本身来衡量新 UI 是否成功可能会造成误导,因为会员可能只是为了看作品更轻松点(让倒置的变成正常)而点击了它。在这种情况下,我们可能还希望评估一下有多少会员随后就离开此作品了而不是继续播放的。

在所有情况下,我们还会考察更综合的指标,希望能够捕捉到 Netflix 为我们的会员提供的快乐和满足感。这些指标包括会员与 Netflix 互动程度的衡量标准:我们正在测试的想法是不是有助于我们的会员在任何特定的晚上把 Netflix 当作自己的娱乐目的地?

这其中还涉及到很多的统计数据——差异大到什么程度才可看作显著?测试需要多少会员才能检测出给定量级的影响?怎么才能最有效地分析数据?我们会在后续文章里面介绍其中的一些细节,重点会放在高级直觉上。

让其他一切保持不变

因为我们是用随机分配的放肆创建的对照组(“A”)和治疗组(“B”)的,所以我们可以确保平均而言,两组中的个体在可能对测试有意义的所有维度上都是均衡的。比方说,随机分配可确保 Netflix 会员的平均租期在对照组和治疗组之间没有显著差异,在内容偏好、主要语言选择等方面也没有显著差异。两组之间唯一剩下的区别就是我们正在测试的新体验,确保我们对新体验影响的评估不会存在任何偏见。

为了理解这一点的重要性,我们不妨思考另一种做出决定的方式:我们可以向所有的Netflix 会员推出新的倒置盒子艺术体验(如上所述),看看我们其中的一个指标是不是会发生重大变化。如果出现了好的变化,或者没有出现任何有意义的变化的证据,我们将保留新的体验;如果出现不好变化的证据,我们就回滚到之前的产品体验。

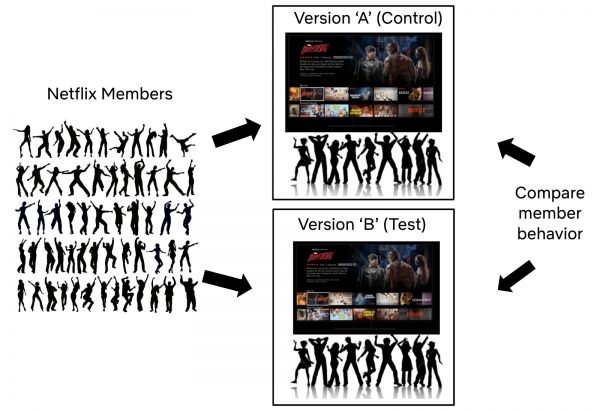

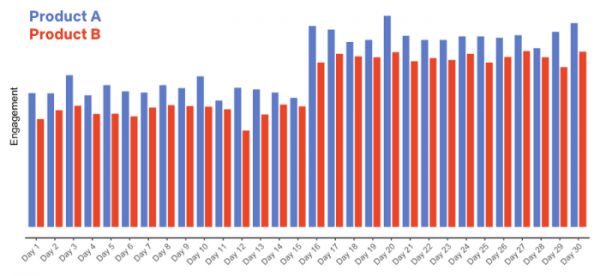

假设我们这么做了(再次地——这是个假设!),并且在当月的第 16 天切换到倒置体验。如果我们收集到以下数据的话,你会怎么做?

图 3:第 16 天发布的全新倒置盒子艺术产品体验的假设数据。

数据看起来挺不错:我们发布了新的产品体验,会员的参与度大为提高!但是,如果你有了这些数据,再加上产品 B 将 UI 里面所有的盒子艺术倒置过来的知识的话,你对新产品体验是不是真的对我们的会员有好处这一点又有多大信心呢?

我们是真的知道新产品体验是导致会员参与度提高的原因吗?还存在哪些可能的解释?

如果你还了解到, Netflix 在(假设的)推出全新倒置产品体验的同一天还发布了一部热门作品,比如新一季的《怪奇物语》(Stranger Things)或《布里杰顿》(Bridgerton),或者像《活死人军团》(Army of the Dead)这样的热门电影的话,又该怎么说? ? 现在我们对会员参与度提高可能就有不止一种解释了:也许是因为新产品体验,也许是因为社交媒体上对热门作品的讨论,也可能两者兼而有之。或者可能完全是别的东西。关键是我们不知道新产品体验是不是导致了参与度的提高。

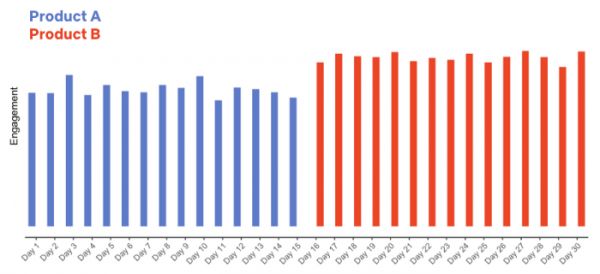

反过来,如果我们对倒置盒子艺术产品体验进行 A/B 测试,让一组会员接收当前的产品体验(“A”),另一组会员这一整月收到的都是倒置产品体验(“B”)的话,又会怎样?以下是收集到的数据:

图 4:新产品体验 A/B 测试的假设数据。

在这种情况下,我们得出了一个不一样的结论:倒置产品导致参与度普遍较低(这并不奇怪!),而且随着热门作品的发布,两个群体的参与度都增加了。

A/B 测试让我们可以做出因果陈述。我们仅向 B 组引入了倒置产品体验,并且由于我们是把会员随机分配到 A 组和 B 组的,因此两组之间的其他一切都保持不变。所以,我们可以得出倒置产品很可能导致参与度降低的结论(下一次再详细介绍)。

这个假设的例子很极端,但一条普遍适用的经验是总有些事情是我们无法控制的。如果我们针对所有人推出一种体验,并在改变前后简单地衡量一个指标的话,那么这两个时间段之间可能存在的相关差异就会阻止我们得出因果结论。也许出现了一个正在变火的新作品。又或者是新的产品合作解锁了更多的用户。总会有一些我们不知道的事情。在可能的情况下,进行 A/B 测试可让我们证实因果关系,并自信地对产品进行变更,因为我们知道,我们的会员会用自己的行为对改变进行投票。

一切从一个想法开始

A/B 测试从一个想法开始——我们可以对 UI进行修改、帮助会员查找内容的个性化系统、针对新会员的注册流程,或我们认为会对会员产生积极影响的Netflix 体验的任何其他部分。我们测试的某些想法是渐进式的创新,比方说改进Netflix 产品中出现的文案的手段;有些更为雄心勃勃一些,比方说让Netflix最终在用户界面中呈现“十大排行版”的测试。

跟面向全球 Netflix 会员推出的所有创新一样,Top 10 一开始只是一个想法,后来变成了可检验的假设。此处的核心思想是将每个国家/地区流行的作品呈现出来可在两个方面令我们的会员受益。首先,通过呈现流行内容,我们可以帮助会员分享体验并通过对相关流行作品的讨论而建立相互的联系。其次,我们可以通过满足人类成为共同对话的一部分内在愿望,帮助会员选择出一些精彩的内容来观看。

图 5:Web UI 上的Top 10 体验示例。

接下来,我们就把这个想法变成一个可检验的假设,也就是“如果我们进行 X 变更,它将会以某种方式改善成员体验,从而令指标 Y 得到改善”。在Top 10 这个例子当中,我们的假设如下:“向会员展示Top10 体验将帮助他们找到值得观看的内容,增加会员的快乐和满意度。” 这一测试(以及众多其他测试)的主要决策指标是衡量会员跟 Netflix 的互动度:我们正在测试的想法是不是有助于我们的会员在任何特定晚上选择 Netflix 作为自己的娱乐目的地?我们的研究表明,从长远来看,该指标(细节此处不谈)与会员保留订阅的可能性是相关的。我们对其他业务领域,比方说注册页面体验或服务器端的基础设施等的测试,采用的是不同的主要决策指标,但原则是一样的:就是要看我们在测试期间可以测量的东西哪些从长期来看能为我们的会员提供更多价值。

除了测试的主要决策指标以外,我们还考虑了很多次要指标,还要看这些会如何受到我们正在测试的产品功能的影响。这里的目标是把从用户行为如何响应新产品体验到我们主要决策指标的变化的整条因果链表述清楚。

阐明产品变更与主要决策指标变化之间的因果链,并监控这一链条上的次要指标,可以帮助我们建立信心,让我们确信主要指标的任何变动都是我们假设的因果链的结果,而不是新功能的某些意外后果的结果(或误报——在后面的系列文章里面我们会详细介绍!)。对于Top 10 的A/B测试来说,参与度是我们的主要决策指标——但我们也会检查其他一些指标,比如Top 10排名当中出现的那些作品的作品级浏览,也就是源自那一行而不是UI的其他部分的浏览量占比等等。如果符合假设的话,提供Top 10的体验应该对我们的会员是有好处的,预期治疗组中出现在Top 10的作品的浏览量应该会增加,而且往往是因为那一行的参与度普遍较高。

最后,因为并不是我们测试的所有想法都会成为赢家,赢得会员青睐(有时新功能会有bug!)我们还会检查充当“护栏”的指标。我们的目标是限制任何的负面后果,并确保新产品体验不会对会员体验产生意外影响。比方说,我们可能会将服务对照组和治疗组的客户服务联系人进行对比比,看看新功能是否没有增加联系率,因为练习率的增加可能表明会员感到困惑或不满。

总结

这篇文章的重点是建立直觉:A/B 测试的基础知识,为什么要跑 A/B 测试,而不是推出功能然后对比变更前后的指标,以及我们如何将想法变成可检验的假设。接下来,我们将介绍用来对比治疗组与控制组体验指标的的基本统计概念。

译者:boxi。

相关推荐

出海企业如何做战略选择和决策

Amazon和Netflix的个性化推荐是如何工作的?

揭秘Google、FB、Netflix、亚马逊的通用增长神器

为什么互联网巨头如此热衷于A/B测试?

硅谷重塑好莱坞,Netflix创始人是如何做到这一切的?

A/B测试成为字节跳动投入toB市场的法宝

Netflix知道自己的敌人是谁

做好To B,靠的是利他思维

Netflix、Snapchat 新发的财报透露了什么?

对话Netflix首任CEO:这是罅隙中崛起的秘径

网址: Netflix是如何做决策的?(二):什么是 A/B 测试? http://m.xishuta.com/newsview55499.html