对于特斯拉、Facebook等公司来说,AI的缺陷已越来越难以忽视

神译局是36氪旗下编译团队,关注科技、商业、职场、生活等领域,重点介绍国外的新技术、新观点、新风向。

编者按:从新兴技术的应用进程来看,Gartner的炒作周期曲线还是挺准的。人工智能经过前几年的炒作之后,在对大众有关键影响的应用上,这项技术正在被泼冷水。在无人驾驶、社交媒体内容审核以及医疗保健上,人类还不能放心交给AI。原因是什么?AI还不够智能,夸大其词的炒作太多,研究人员把太多的注意力放在了模型而不是数据上。到底什么时候AI才能达到预期?不知道。本文来自编译。

划重点:

人工智能在无人驾驶、社交媒体、医疗保健等关键应用上未达预期

人工智能未达预期的原因在于技术营销的夸大宣传以及人工智能科学家对数据的忽视

但大量资金仍源源不断地涌入人工智能领域

Facebook联合创始人马克·扎克伯格与特斯拉的首席执行官埃隆·马斯克,这两个人有什么共同点?两人都在跟一些大问题缠斗,而这些问题至少部分是源于对人工智能系统的信任,但后者辜负了这份信任。扎克伯格要应付没能阻止有害内容传播的算法;马斯克的软件的驾驶技术还没能达到他经常许下的承诺。

从他们遇到的问题我们可以吸取什么教训?人工智能还没做好准备去迎接黄金时段。而且,也很难知道什么时候能准备好。公司应该考虑把注意力放在形成高质量的数据——而且是大量这样的数据上——同时雇用人工来完成人工智能还没做好准备的工作。

深度学习 AI 系统原来是想大致模拟人脑,现在这种系统已经可以发现肿瘤、驾驶汽车还有写作,在实验室环境下,它们展现出惊人的结果。但问题就在这儿。在不可预测的现实世界里面应用这种技术时,人工智能有时候会达不到预期。当有人吹嘘它可以用于医疗保健等高风险应用时,这种情况令人担忧。

就像最近一名举报人披露的内部文件所揭示的那样,社交媒体的风险也很高,社交媒体的内容可能会影响到选举,并造成心理健康障碍。但 Facebook 对人工智能的信心在自家的网站上表露得很明显,网站往往先突出介绍自己的机器学习算法,然后才会提到自己还有一支庞大的人工审核队伍。2018 年的时候,扎克伯格还曾告诉美国国会,人工智能工具可以“大规模”地识别有害内容。在发现裸体以及恐怖主义相关内容方面,这些工具做得不错,但仍然难以阻止错误信息的传播。(2)

问题在于人类的语言总是在变。反疫苗活动人士用类似输入“va((ine”)之类的技巧来避免被发现,而私人枪支销售商则在 Facebook Marketplace 上发布空箱子的图片,然后附上“PM me”(私信我)的文字。旨在阻止违规内容的系统被骗了,更糟糕的是,AI 还经常推荐这类内容给用户。

这也就难怪聘请来给 Facebook 的算法提供支持的约 15000 名内容审核员工作会过量。去年,纽约大学斯特恩商学院曾进行过一项研究。研究建议,如果 AI 不能胜任内容审核这项任务的话,Facebook 应该将这些员工增加一倍至 30000 人,这样才能作为帖子的监控。 《数学杀伤性武器》(Weapons of Math Destruction)的作者凯茜·奥尼尔(Cathy O’Neil)十分直截了当,她说 Facebook 的人工智能“没用”。扎克伯格也告诉国会议员,由于语言的微妙,人工智能很难对帖子做出正确的审核。

马斯克对人工智能的过度承诺更是已经变成传奇。 2019 年,他告诉特斯拉的投资者说,自己“很有信心”,很快就会有 100 万辆 Model 3 无人驾驶机器人出租车上路。什么时候:2020 年。现在2021年就快过去了,特斯拉客户目前得到的只有支付 10000 美元购买特殊软件的特权。什么特殊软件?有朝一日(又叫做天知道什么时候)可提供全自动驾驶功能的特殊软件。直到那时,汽车才可以自行停车、变道,驶上高速公路,只是偶尔才会出现严重错误。马斯克最近在一条推文中也承认,通用自动驾驶技术是“一个难题”。

更令人惊讶的是:人工智能在医疗保健方面也一直表现不佳,本来这个领域对于AI技术而言是最有希望的。今年早些时候,《自然》杂志上的一项研究分析了数十种旨在检测 X 射线以及 CT 扫描当中存在的 COVID-19 疾病迹象的机器学习模型。研究发现,由于各种缺陷,没有一种模型可用于临床环境。上个月发表在《英国医学杂志》(British Medical Journal)上的另一项研究发现,94% 的人工智能系统在扫描乳腺癌征兆的准确度上低于放射科医生个体的分析。 该研究的负责人,华威大学人口健康教授泰勒-菲利普斯( Sian Taylor-Phillips )说:“大量炒作说[放射学人工智能扫描] 时代即将到来,但从某种程度来说先到的是炒作而并不是结果。”

政府顾问将根据她的研究结果来决定此类人工智能系统是不是利大于弊,并因此可供使用。就这方面而言,危害似乎并不明显。毕竟,用于发现乳腺癌的人工智能系统在设计上过于谨慎,导致漏报肿瘤征兆的可能性要高于误报。但是,即便乳腺癌筛查的召回率(美国为 9%,英国为 4%)仅增加很小的百分比,也意味着成千上万的女性因误报而变得更加焦虑。泰勒-菲利普斯说:“也就是说,就为了实施新技术,我们接受了对被筛查女性的伤害。”

出现错误的似乎不仅限于少数研究。 AI 市场情报公司 Cognilytica 的执行合伙人凯思林·沃尔克( Kathleen Walch )说:“几年前,大家对 AI 把守放射科的第一道关抱有很大希望和炒作。但现在我们看到,人工智能在检测这些异常方面并没有提供任何有用的帮助。”

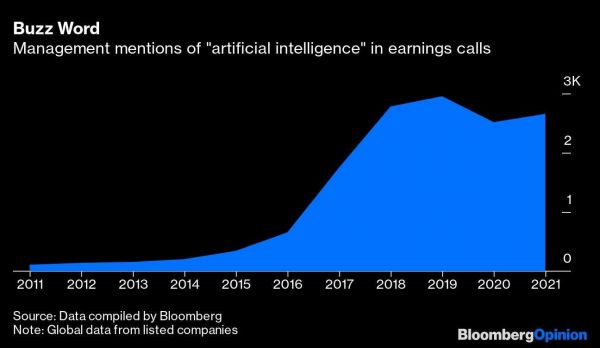

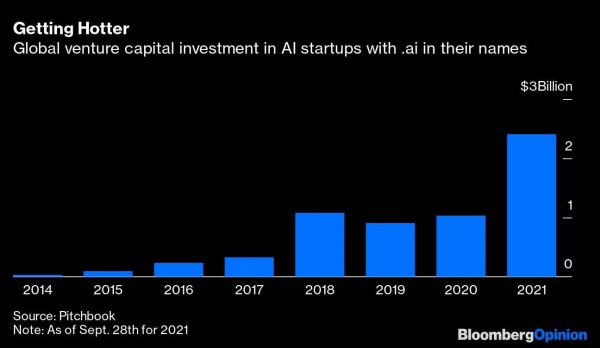

尽管如此,这些危险信号都没能阻止大量资金不断涌入人工智能领域。根据追踪私人资本市场的 PitchBook Data的数据,在经过一段时间的稳步攀升之后,全球对人工智能初创企业的风险资本投资在过去一年出现了飙升。根据彭博社对文字记录的分析,在过去十年的时间里,企业财报电话会议提到“人工智能”的次数一直在稳步上升。

“人工智能”是最近几年的热词

可是既然有这么多的投资,为什么人工智能还没有达到我们希望的状态?部分问题在于技术营销的夸大宣传。但人工智能科学家本身也可能难辞其咎。

人工智能投资热也高烧不退

这些系统要取决于两样东西:能用的模型,以及用于训练该模型的基础数据。为了开发出可用的人工智能,程序员需要把绝大部分的时间(可能约占 90%)都花在数据上——收集数据、对数据进行分类,然后清洗数据。这项工作既枯燥又艰难。可以说,目前的机器学习社区也忽视了这一点,因为科学家们更加重视 AI 架构的复杂性,或者模型的复杂程度。

其中的一个结果是:根据麻省理工学院科学家最近的一项研究,用于开发人工智能系统(比如计算机视觉和语言处理)的那些最流行的数据集里面到处都是错误。热衷搭建模型的文化实际上阻碍了人工智能。

但也出现了一些令人鼓舞的变化迹象。 谷歌的科学家最近在一篇会议论文中抱怨了模型与数据的问题,并提出了各种办法来制定更多的激励措施以解决这个问题。

企业也正在将注意力从“人工智能即服务”供应商身上转移。尽管这些供应商承诺自己的服务开箱即用,就像魔术一样。 PitchBook 的高级分析师 布兰登·布尔克(Brendan Burke )表示,现在他们征兆把更多的资金投入到数据就绪软件上。他表示,Palantir与C3.ai等纯粹的 AI 公司“取得的成果不算出色”,而 Databricks等数据科学公司“正在取得更高的估值以及出色的成果。”

人工智能偶尔会在低风险的场景下搞砸,比如推荐电影不靠谱,或用你的脸解锁不了智能手机。但在医疗保健和社交媒体内容等领域,AI仍然需要更多的训练,更好的数据。企业不应该现在就打算让 AI 发挥作用,而应该用数据和人员奠定基础,让AI在不远的将来(希望如此)发挥作用。

译者:boxi。

相关推荐

对于特斯拉、Facebook等公司来说,AI的缺陷已越来越难以忽视

AI错删YouTube机器人视频,背后是人类难以消弭的身份焦虑

美监管机构指责特斯拉和苹果忽视司机安全,称特斯拉系统不够完善

酷炫如特斯拉的大屏,也难逃这三个设计缺陷

36氪首发 | 已实现工业AI多维缺陷检测跨行业落地,「东声智能」完成千万元人民币天使轮融资

对于初创企业来说,什么才是有效的流量池?

特斯拉 AI 芯片的真正实力

美政府:特斯拉Autopilot设计缺陷导致车祸

股价上天但问题频出的特斯拉,该踩踩“刹车”了

悬赏1000万美元,打假AI换脸,Facebook发起Deepfakes检测挑战赛

网址: 对于特斯拉、Facebook等公司来说,AI的缺陷已越来越难以忽视 http://m.xishuta.com/newsview52999.html