苹果高管为隐私改革辩护:技术已足够成熟 可在保护儿童和隐私之间找到平衡

腾讯科技讯 8月11日消息,苹果公司最近宣布了一系列针对在其设备上保护儿童安全的新功能,它们将于今年晚些时候向用户推出。虽然这些功能的目标被普遍认为是好的,包括保护未成年人和限制儿童性虐待材料(CSAM)的传播,但苹果使用的方法却饱受非议。

美国当地时间周二,苹果隐私主管埃里克·纽恩施万德(Erik Neuenschwander)接受专访,谈到了苹果为其设备推出的新功能。他详细解答了人们对这些功能的诸多担忧,并讨论了它们推出后可能引发的问题。纽恩施万德还谈及这些功能的推出情况,它们看似紧密交织在一起,但实际上是各自完全独立的系统,只是有着相似的目标。

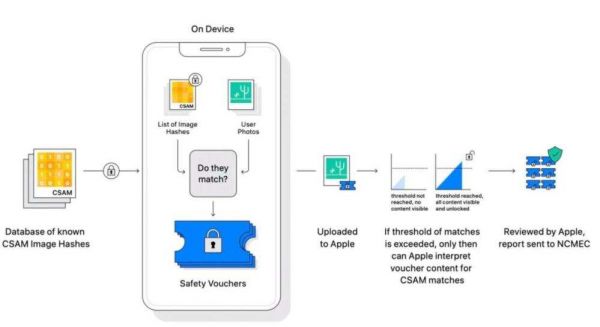

第一个功能是iCloud Photos CSAM检测功能(CSAM detection in iCloud Photos):名为NeuralHash的检测系统创建的标识符可以与美国国家失踪和被剥削儿童中心和其他实体的ID进行比较,以检测iCloud Photos图片库中已知的CSAM内容。大多数云服务提供商已经在用户图片库扫描这些信息,苹果的系统不同之处在于它在设备上进行匹配,而不是在云端。

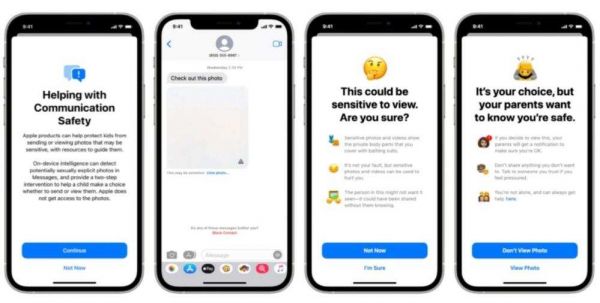

第二个功能是信息通信安全功能(Communication Safety in Messages):父母选择在其iCloud家庭帐户上为未成年人开通这项功能。当检测到他们要查看的图像含有CSAM内容的图片时,该功能会提醒孩子和家长。

第三个功能是Siri和搜索干预功能:当用户试图通过Siri和搜索CSAM相关的术语时,该功能将进行干预,同时将通知用户并提供资源。

从个人经验来看,我们知道有些人可能不理解前两个系统之间的区别,或者认为它们可能会导致自己孩子的无辜照片受到审查。然而事实上,这两个系统是完全独立的,CSAM检测会查找与组织已知的、滥用图片精确匹配的内容。第二个功能完全发生在设备上,不向外部报告任何内容,它只是向孩子们发出他们正在或可能正在查看非法图像的标记。此功能由父母选择加入,并且对父母和孩子都保持透明。

苹果的信息通信安全功能

还有关于在设备上对照片进行散列以创建可以与数据库进行比较的标识符问题。虽然NeuralHash可以用于其他功能,比如在照片中进行更快的搜索,但它目前在iPhone上除了CSAM检测之外还没有用于任何其他功能。禁用iCloud Photos后,该功能将完全停止工作。这为人们提供了退出的选择,但考虑到iCloud Photos的便利性和与苹果操作系统的集成,这无疑需要用户付出高昂代价。

以下为纽恩施万德专访全文:

问:大多数其他云服务提供商已经扫描CSAM有一段时间了,但苹果却没有。显然,目前还没有规定你们必须在自己的服务器上查找它,但在欧盟和其他国家已经推出有些令人不安的规定。这就是促使你们采取行动的动力吗?为何选择现在行动?

纽恩施万德:为何选择当前这个时机,可以归结为这样一个事实,即我们现在已经拥有了相当成熟的技术,能够在保护儿童安全和用户隐私之间找到平衡。这是我们已经关注了很长时间的领域,包括目前涉及在云服务上扫描用户图片库全部内容的先进技术。正如你所指出的那样,查看用户的iCloud照片是我们从未做过的事情。这个系统也不会改变这一点,它既不会查看设备上的数据,也不会查看iCloud Photos中的所有照片。相反,它为我们提供了一种新的能力来识别开始收集已知CSAM的帐户。

问:因此,这种新的CSAM检测技术取得进展是现在推出这项技术的分水岭。苹果觉得自己可以用一种让自己感觉舒服的方式来做这件事,但这对你们的用户来说是最好的吗?

纽恩施万德:的确如此。我们这里有两个相等的目标:一是提高平台上的儿童安全,二是保护用户隐私。我们能够跨越所有这三个功能的是,将让我们实现这两个目标的技术结合在一起。

问:同时发布信息通信安全功能和iCloud Photos CSAM检测功能,似乎让人对它们的能力和目标产生了混淆。同时宣布它们是个好主意吗?如果它们是独立的系统,为什么要同时宣布呢?

纽恩施万德:虽然它们是两套系统,但它们也与我们将在Siri和搜索领域增加的干预措施融为一体。识别已知的CSAM图片库在苹果的iCloud Photos服务中存储在哪里同样重要,但努力摆脱这种已经很可怕的情况也很重要。因此,CSAM检测功能意味着,已经有已知的CSAM通过了报告过程,并且正在被广泛分享,在最初创造这些材料的创建者不得不碰巧发生的虐待之外,儿童可能再次成为受害者。

要做到这一点,我认为这是重要的一步,但同样重要的是,当人们开始进入这个有问题和有害的领域时,或者如果已经有施虐者试图梳理或将儿童带入可能发生虐待的情况,采取措施进行干预也很重要,信息通信安全以及我们对Siri和搜索的干预实际上打击了这一过程的某些环节。因此,我们实际上是在试图扰乱CSAM的传播途径,然后CSAM最终可能会被我们的系统检测到。

苹果在iCloud Photos系统中检测CSAM的过程

问:世界各地的政府和机构不断向所有为其用户启用任何形式的端到端加密甚至部分加密的大型组织施压。他们经常依靠CSAM和可能的恐怖主义活动作为主张开设“后门”或反对加密的理由。将新功能和此功能与设备上的散列相匹配,是不是在努力避免这些请求,并证明你们能够提供追踪和阻止CSAM传播所需的信息,而不会损害用户的隐私?

纽恩施万德:首先,我想强调的是,按照设计,这些新系统不会像人们传统上认为的那样,显示与设备匹配的结果,或者将结果显示给苹果。苹果无法处理这些个人信息;相反,我们系统的所有属性意味着,只有当账户积累了与非法的、已知CSAM图像相关的图片库后,我们才能了解用户账户的任何信息。

至于为什么要现在这样做,这是因为,正如你所说,这将在保护用户隐私的同时提供检测能力。我们的动机是需要在整个数字生态系统中为保护儿童安全做更多的事情,我认为我们的三个功能都在这个方向上采取了非常积极的步骤。与此同时,我们将为所有没有参与非法活动的人保留隐私不受干扰。

问:为此,创建允许扫描和匹配设备上内容的框架,以及创建供外部执法部门应对的框架,是不是旨在说明:‘我们可以给你提供列表,我们不想查看所有用户的数据,但我们可以给你提供我们希望你匹配的内容列表’。如果你可以将其与此内容相匹配,就可以将其与我们要搜索的其他内容相匹配。这怎么能不破坏苹果目前的立场呢?苹果向来宣称不能解密用户的设备。”

纽恩施万德:这丝毫改变不了这一点。苹果设备仍然是加密的,我们仍然没有持有密钥,系统被设计为基于设备上的数据运行。我们设计的是一个设备端组件,以改善隐私安全。另一种选择是在服务器上浏览并尝试评估用户数据,实际上更容易在用户不知情的情况下进行更改,而且对用户隐私的保护较少。

我们的系统既包括设备上组件(创建凭证),也包括服务器端组件,当凭证与数据一起发送到苹果服务,并跨帐户进行处理时,我们就可以了解是否存在非法CSAM图片集。这意味着,它是一项服务功能。我知道这是个复杂的属性,服务的功能有一部分是在设备上生成凭证,但同样,对设备上的内容一无所知。

实际上,正是凭证的生成让我们不必开始处理服务器上的所有用户内容,而这是我们从未在iCloud Photos上做过的事情。我认为,当涉及到隐私属性时,或者在没有任何用户洞察力或知识的情况下如何更改这些系统,以做除设计目的之外的事情,这类系统才是更令人担忧的。

问:对这些新系统更大的质疑在于,苹果表示,如果政府或其他机构要求其妥协,将不是CSAM的东西添加到数据库中,以便在设备上检查它们,苹果会拒绝采取行动。有些例子表明,如果苹果想要在国际市场运营,它必须在最高层遵守当地法律。那么,如果政府施压或要求苹果妥协系统,我们怎么能相信苹果会遵守这种拒绝干预的做法呢?

纽恩施万德:首先,这些新功能只适用于美国的iCloud账户,因此不存在上述假设的情况。其次,即使我们讨论的是某些试图改变系统的情况,它也有些内置的保护措施,这使得它在试图识别持有特别令人反感的图像的个人时没有多大用处。哈希列表内置于操作系统中,而我们只有一个全局操作系统,无法针对单个用户进行更新,因此当系统启用时,哈希列表将由所有用户共享。

第三,该系统要求超过图像的阈值,所以试图从一个人的设备或一组人的设备中查找哪怕是一张图像都不会奏效,因为该系统根本不会向苹果提供任何关于存储在我们服务中的单张照片的信息。第四,该系统内置了一个手动审查功能,如果一个账户被标记了一系列非法的CSAM材料,苹果团队将在向任何外部实体推荐之前进行审查,以确保它与非法的CSAM材料正确匹配。

所以假设需要跳过很多障碍,包括让苹果改变其内部流程,提交不违法的材料,比如众所周知的CSAM,我们不相信在美国人们能够提出这样请求的基础。最后我想补充的是,它仍然保留用户的选择,如果用户不喜欢这种功能,他们可以选择不使用iCloud Photos,如果iCloud Photos没有启用,整个系统都不起作用。

问:也就是说,如果iCloud Photos被禁用,系统将无法工作,这是常见问题解答中的公共语言。我只想特别问一句,当你禁用iCloud Photos时,这个系统会继续在设备上为你的照片创建图片库,还是在那个时候完全不活动?

纽恩施万德:如果用户没有使用iCloud Photos,NeuralHash将不会运行,也不会生成任何凭证。CSAM检测是与作为操作系统映像一部分的已知CSAM哈希数据库进行比较的图片库。如果你不使用iCloud Photos,那么这一部分或其他任何部分,包括创建安全凭证或将凭证上传到iCloud Photos,都无法正常工作。

问:近年来,苹果经常倾向于这样一个事实,即设备上的本地处理保护了用户隐私。在我能想到的几乎所有案例中,这都是真的。例如,扫描照片以识别其内容,并允许我们搜索它们。我宁愿在本地完成,而不是发送到服务器。然而,在这种情况下,似乎实际上可能有一种相反的效果,因为你是在本地扫描,而不是针对外部使用情况进行扫描,也不是针对个人使用进行扫描,这在许多用户心目中造成了一种“不太信任”的情况。除此之外,每个其他云提供商都会在他们的服务器上扫描它,问题是,为什么你们的方法与大多数公司都不同,应该产生对用户的更多信任,而不是更少呢?

纽恩施万德:我认为,与行业标准相比,我们正在提高标准。任何一种处理所有用户照片的服务器端算法都会使这些数据面临更大的泄露风险,而且从定义上说,在用户库上所做的事情也不那么透明。因此,通过将其构建到我们的操作系统中,我们获得了操作系统的完整性已经在许多其他功能中提供的相同属性,一个对所有下载和安装它的用户都是相同的全局操作系统,因此在一个属性中它更具挑战性,即使它针对单个用户。在服务器端,这实际上非常简单。能够拥有一些属性,并将其内置到设备中,并确保所有启用了这些功能的用户都是一样的,这就提供了很强的隐私属性。

其次,你指出了使用设备上的技术是如何保护隐私的。在这种情况下,这是我再次向你说明:这真的是一种替代,用户的图片库必须在不那么私密的服务器上处理。

关于这套系统,我可以说的是,对于没有参与非法行为的其他用户来说,它完全不会侵犯隐私,苹果不会获得关于任何用户云库的额外信息。由于这个特性,用户的iCloud图片库无需被处理。相反,我们能够做的是创建这些加密安全凭证。它们的数学特性表明,苹果只能解密内容或了解任何有关图像和用户的信息,特别是收集与非法已知CSAM匹配的照片用户。而对于云处理扫描服务来说,每张图像都必须以清晰的解密形式处理,并按例程运行,以确定谁知道什么?在这一点上,很容易确定你想要的任何东西(关于用户的图像)与我们的系统相比,只需要确定哪些图像与一组直接来自NCMEC和其他儿童安全组织的已知CSAM图片相匹配。

问:当设备受到物理危害时,此CSAM检测功能能否保持整体性能?有时密码学在本地被绕过,有人掌握了设备,那里有没有额外的保护层?

纽恩施万德:我认为重要的是要强调这是多么具有挑战性、昂贵和罕见的例外。这对大多数用户来说并不是大问题,尽管我们非常认真地对待它,因为保护设备上的数据对我们来说是最重要的。因此,如果我们假设某人的设备受到了攻击,有很多用户的数据可能会被他们访问。有观点认为,攻击者最有价值的事情是,他们想要触发对账户的手动审查,但这种想法没有多大意义。

因为请记住,即使产生了凭证,而且我们有些由苹果解密的凭证,下一阶段也是手动审查,以确定是否应该将该账户提交给NCMEC,这是我们希望只有在合法的高价值报告的情况下才会发生的事情。我们已经以这种方式设计了系统,但如果我们考虑到你提出的攻击场景,我认为对于攻击者来说,这不会得出非常令人信服的结果。

问:为什么会有图片上报的门槛儿,一条CSAM内容不够吗?

纽恩施万德:我们希望确保我们向NCMEC提交的报告是高价值和可操作的,所有系统的一个重要概念是,图像是否匹配存在许多内在的不确定性。因此,这个门槛儿允许我们达到这样的水平,即我们预计每年每1万亿个账户中就有1个账户审查时会出现虚假报告率。因此,与我们没有任何兴趣查看持有已知CSAM收藏的用户图片库的想法相反,这个门槛儿让我们高度自信。当我们提到NCMEC时,执法部门将能够接管并有效地调查、起诉和定罪那些我们审查的账户所有者。

本文来自“腾讯科技”,审校:金鹿,36氪经授权发布。

相关推荐

苹果高管为隐私改革辩护:技术已足够成熟 可在保护儿童和隐私之间找到平衡

苹果加码隐私保护,但Facebook不会是最大受害者

最前线 | 美国司法部怀疑TikTok违反儿童隐私保护协议,开启调查

苹果走钢丝:为iPhone隐私大战FBI,还是屈服于特朗普?

苹果加倍保护隐私,巩固围墙花园让应用开发者进一步不满

苹果推出iCloud的VPN服务,全系产品强调隐私保护

隐私保护问题的经济学思考

从特斯拉事件到隐私报告,探寻数据和隐私真相

苹果布下的“隐私局”,Facebook没得选

AI基础设施革命?关于数据隐私保护和价值挖掘的实践思考

网址: 苹果高管为隐私改革辩护:技术已足够成熟 可在保护儿童和隐私之间找到平衡 http://m.xishuta.com/newsview48514.html