性虐视频正成为施暴者帮凶,技术公司如何精准“拆弹”,防止受害者视频二次传播

编者按:本文来自微信公众号“大数据文摘”(ID:BigDataDigest),作者:刘俊寰、曹培信,36氪经授权发布。

3月22日,韩国N号房一事被曝光,用裸照威逼利诱女性、对受害者实施性剥削的产业链终于公之于大众,66名与N号房事件有关人士被捕。

韩国警方所掌握线索的被害女性多达74人,其中16人为未成年人,最小年龄受害者为年仅11岁的小学生。

以N号房为代表的性侵事件涉事人数之庞大,韩国并非孤例。

4月9日,据南风窗报道,烟台杰瑞石油服务集团股份有限公司副总裁及首席法务官、中兴通讯的独立非执行董事鲍毓明涉嫌自约2016年起性侵14岁养女李星星,在互联网引起热议。

据报道,近3年来,李星星始终处于半失学状态,期间多次自杀未遂。

根据南风窗消息,李星星曾透露,2016年后,鲍毓明会给她播放未成年人性题材影片,内容涉及爸爸、妈妈和孩子之间的色情场面,并对其进行言语上的“安慰”。

2019年4月9日,这已经是李星星第二次报案,但警方在进行查证时却发现,电视里“儿童色情片”的观看记录“消失”了,电脑里的文件也没找到。由于缺少决定性证据,目前的证据多为孤证,取证难度大,5月,李星星收到《撤案决定书》。

2018年,南韩超过4万名妇女举行抗议,敦促政府採取措施解決涉及偷拍色情照片的罪案问题。

但是,从3月的N号房到如今的李星星,一个月不到的时间内,未成年人性侵案件不断被曝光,让人不禁疑惑,这冰山之下究竟还有多少受害者?

目前,亚马逊、Facebook等技术公司虽然能够识别并侦查相关违禁视频,但仍然无法阻止未成年人性侵视频的上传,甚至是二次传播,技术尚难以从源头上有效规避和禁止,无形中也给受害者造成了二次伤害。

针对弱势群体,技术如何能够更为有效地保护她们,这是每个技术人都需要思考的问题。

无奈的技术公司:为什么不能从源头上禁止这些视频的上传?

N号房的主犯尽管已经入狱,但是,被侵害者的噩梦远没有结束。

数字时代的记忆属性让搜索引擎、社交网络和云存储中都可能成为这些视频和照片存储的角落,也让这些可怕的记录在互联网上流传,寻找着“二次观众”,这些流入互联网洪流的视频像一颗颗隐秘的定时炸弹,随时可能被不法分子引爆。

而这些视频也正成为鲍毓明一类侵犯者的可怕“共犯”。近年来,科技行业意识到了网络上儿童性虐视频的严重性,开始花大力气识别相关视频等材料,但是,效果似乎并不显著。

那么,互联网公司为什么不能提前审核,从源头上禁止这些可怕视频的上传呢?

首先,随着互联网的发展和用户的增加,相关视频的数量正在呈指数级增长。

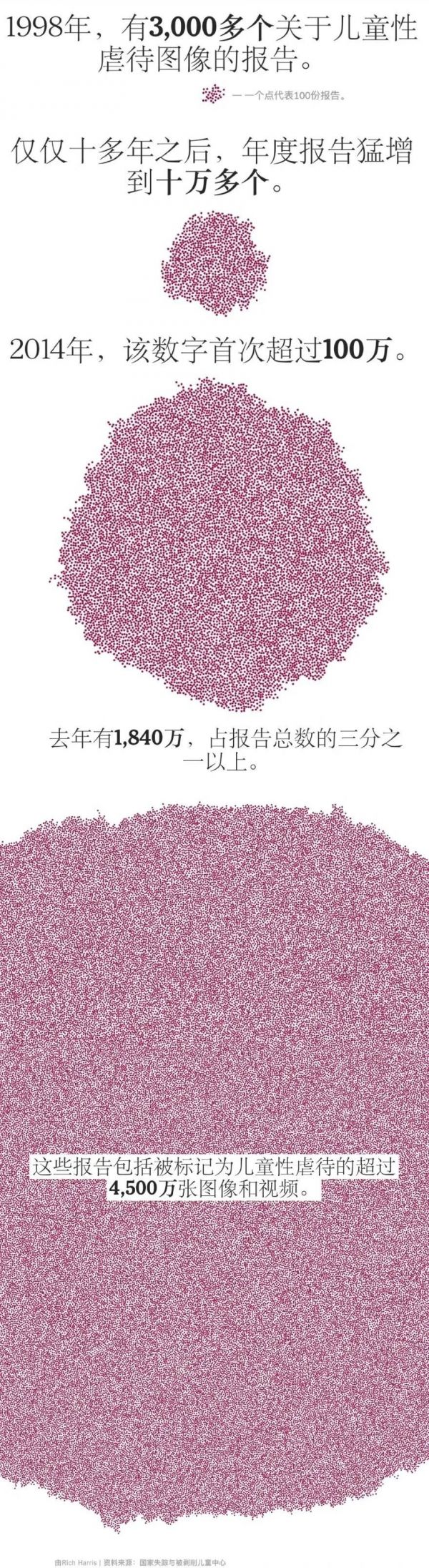

据《纽约时报》报道,仅2018年一年,互联网公司查找到了创纪录的4500万张有嫌疑的照片和视频,数量是上一年的两倍多。

纽约时报用一张非常形象的可视化图,展示了近年来互联网上儿童性侵视频的增加。

可视化作者Rich Harris,数据来源:美国国家失踪与被虐待儿童中心

其次,尽管尽管互联网公司的搜索技术虽然一直在进步,但道高一尺魔高一丈,面对隐藏在暗处、单方面秘密进行的不法分子,总有漏网之鱼。

《泰晤士报》曾经审查了10,000多页的警察和法院文件,发现恋童癖者很容易使用加密软件隐瞒了自己的身份,其中一位恋童癖甚至经营了一个网站,该网站托管了多达17,000张此类图像。

亚马逊的云存储服务每秒处理数百万次的上载和下载,根据联邦当局的说法,Apple不会扫描其云存储,并且会加密其消息传递应用程序,从而几乎无法进行检测。Dropbox,Google和Microsoft的消费产品将扫描非法图像,但只有在当有人共享它们时才扫描,而不是在上载时扫描。

包括Snapchat和Yahoo在内的其他公司长期以来也只对照片进行审核,而根本不审核视频。

最后,隐私的限制也让这些互联网公司束手束脚。

Facebook是世界上最大的社交网络,它会对其平台进行全面扫描,占据了科技公司去年标记的图像的90%以上,但该公司并未使用所有可用的数据库来检测材料。Facebook已经宣布,图像的主要来源Facebook Messenger最终将被加密,从而极大地限制了审核。

“每家公司都在寻求自己的隐私与安全之间的平衡,他们不想在公开场合这样做,”担任Facebook和Yahoo信息安全主管的Alex Stamos说。“这些决定实际上对儿童的安全产生了巨大影响。”

高科技公司更有可能在其平台上查看照片和视频以及其他文件,以进行面部识别,恶意软件检测和版权实施。但是一些企业表示,寻找滥用内容是不同的,因为它可能引起重大的隐私问题。

人们不愿看到科技公司浏览某人的照片和视频,并且自动扫描中标记的图像几乎总是在以后由一个人进行审查。

“一方面,保护个人信息非常重要,”美国司法部副总检察长拉吉(Sujit Raman)在接受《纽约时报》采访时表示,“另一方面,互联网上有太多破坏性的东西。”

科技公司的补救方式就是在视频出现后再全网搜索进行删除,通过将新检测到的图像与材料数据库进行匹配,来阻止滥用图像的再循环造成伤害。

目前检测非法图像的主要方法是由Microsoft开创的PhotoDNA的应用,已经保护了数不清的受侵害者不受到重复伤害。

隐私与技术的平衡:为图片打上专属“指纹”,找出非法图片全网删图

早在2009年,微软就和现任加州大学伯克利分校教授的Hany Farid创建了一款被称为PhotoDNA的应用,可以使用计算机识别照片,甚至可以修改照片,并将其与已知非法图像的数据库进行比较。这项技术可以帮助寻找和删除网络上的儿童性侵和虐待图片。

如今,PhotoDNA已经被世界各地的组织所使用,并且已经帮助发现、删除和报告了数以百万计的儿童性侵和虐待图片。

PhotoDNA的工作原理是这样的,首先,PhotoDNA为创建一个独特的图像数字签名(称为“散列”) ,类似于人的指纹。

然后将数字签名与互联网上其他照片的签名(散列)进行比较,就可以找到同一图像的副本。

当与包含以前识别的非法图像的哈希数据库匹配时,PhotoDNA可以帮助检测、干扰和报告非法图片的分布。

并且从隐私保护来说,PhotoDNA不是一款面部识别软件,不能用来识别图像中的人或物,另外,PhotoDNA创建数字签名的过程是不可逆的,因此不能用来重建图像。

微软已经向国家失踪和被剥削儿童中心(NCMEC)和一些公共组织捐赠了PhotoDNA,以打击儿童性侵和虐待图片。

“我们的目标是阻止这种伤害。通过使用PhotoDNA,我们将能够与全国各地的在线服务提供商合作,匹配这些照片,这样我们就可以停止照片的再分发。”NCMEC的CEO Ernie Allen表示。

防止性侵,AI能做什么?

此前,韩国N号房事件传的沸沸扬扬,一些罪犯通过网络诈骗,以各种理由骗取女生裸露的照片,然后便开始用这些裸照威胁女生从事性工作,其中最小的女生不过才11岁。

面对这些受害者,AI能做些什么?

2018年下半年,微软组织了一次黑客编程马拉松大赛,Facebook、谷歌等公司的工程师与法律专家均参与其中。大赛的初衷就是构建能够有效检测这些“互联网捕食者”的AI工具,以及建立起受害方的信任。

微软还与其他公司进行了进一步的合作来优化AI工具,使它能基于特征对两人的对话进行评估和评级,如果对话内容风险较大,这些会话将被发送给AI审核。

如果系统识别到有侵害未成年人人身安全的风险,例如提到了私下会面等,AI会通知当地的执法机构以及NCMEC(美国国家失踪与受虐儿童援助中心)。

微软首席数字安全官Courtney Gregoire称,对于这个问题他们已经能做到反应和报告,但还不能实现预防。

Facebook全球安全负责人Antigone Davis去年也曾向《金融时报》透露,他们在过去几年中一直在与儿童保护组织合作,开发保护平台上的儿童免受侵害的方法。

Antigone Davis表示,相关措施包括当有人在Messenger和Instagram DM上要求与儿童进行私下聊天,或试图在未成年人多次拒绝的情况下依然要求获取联系方式时进行警报。

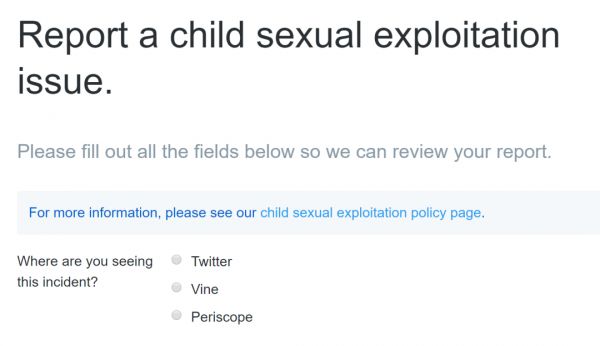

除了Facebook,推特也积极响应着举报有性侵儿童可能的行为的相关政策,推特表示,一旦发现有账号发布儿童色情内容,推特官方会在不通知当事者的情况下第一时间进行删除,对其他用户的举报也会进行及时的审核。

尽管如此,目前的技术仍不能做到防患于未然,但我们依然寄期望于这些科技巨头,但愿能用技术还互联网一片光明。

参考链接:

https://www.nytimes.com/interactive/2019/11/09/us/internet-child-sex-abuse.html

https://techcrunch.com/2019/01/10/unsafe-search/

https://mp.weixin.qq.com/s/4YeU6Wceg78LFPftIcaliA

https://mp.weixin.qq.com/s/vzcAhnzQHAaeLZPVQR0ASw

https://mp.weixin.qq.com/s/SGY1SCj5bQGRFMzed7mYNw

https://www.thepaper.cn/newsDetail_forward_6893688

网址: 性虐视频正成为施暴者帮凶,技术公司如何精准“拆弹”,防止受害者视频二次传播 http://m.xishuta.com/newsview21004.html