谷歌高管自黑:逼得李世石退役的阿尔法狗真的不算啥

编者按:本文来自微信公众号“iFeng科技”(ID:ifeng_tech),作者 霜叶,36氪经授权发布。

阿尔法狗与李世石对弈渲染图

在计算机科学领域,衡量人工智能技术的“智能”是最棘手,也是最重要的问题之一。如果不能确定今天的技术比昨天的技术更聪明,怎么会知道技术有了进步呢?

乍一看,这似乎是一个伪命题。“很显然,人工智能越来越聪明”是一个答案。有大量资金和人才涌入人工智能领域,人工智能也获得了一些里程碑意义的进展,例如战胜顶尖人类围棋选手;一些在10年前还不可能解决的问题,目前已司空见惯,例如图像识别。这些都标志着人工智能取得了很大进步。

另一种答案是,这些进步真心不是衡量人工智能技术“智商”的好指标。在国际象棋和围棋领域超过顶尖人类选手确实很了不起,但如果最聪明的计算机在解决常见问题方面的表现还不如幼儿或小白鼠,这又有什么意义呢?

这是由谷歌软件工程师、机器学习领域大腕弗朗科斯·乔列特(François Chollet)提出的一种观点。乔列特是得到广泛应用的神经网络开发工具Keras的开发者。

在最近发表的一篇标题为《智商的衡量》的论文中,乔列特阐述了一个观点,人工智能领域需要重新关注什么是智商的问题。他说,如果研究人员想要在通用人工智能领域取得进步,他们需要抛弃过去流行的指标,例如视频游戏和棋类游戏,开始考虑使人更聪明的技能,例如归纳和适应的能力。

在接受The Verge电子邮件采访时,乔列特解释了他在这一问题上的想法,阐述了他认为当前人工智能成就具有“误导性”的原因、未来我们应当如何衡量人工智能“智商”,以及对超级人工智能的担忧(代表人物就是埃隆·马斯克(Elon Musk))会限制公众想象力的原因。以下是略经编辑的采访实录:

人工智能框架Keras开发者弗朗科斯·乔列特

问:在论文中,您阐述了人工智能领域两种不同的“智能”概念,一种概念把“智能”视作在多种任务方面表现出众的能力;另一种概念更重视归纳和适应的能力——人工智能对新挑战作出反应的能力。目前哪种概念影响力更大,后果是什么?

答:在人工智能发展的前30年,第一种概念更有影响力:智能表现为一组静态程序和明确的知识。目前,事情发生了180度的变化:人工智能领域对智能的描述是 “白板”。令人遗憾的是,这一框架基本上没有遇到过挑战,甚至基本上没有受到过审视。这些问题有很长的历史——可能是数十年,目前人工智能界对这些历史基本上一无所知,原因也许是目前从事深度学习工作的大多数人都是在2016年以后进入这一领域的。

这种知识垄断不是好事,尤其是对知之甚少的科学问题的答案而言。它限制了人们的质疑,限制了人们创新的空间。我认为目前研究人员应该认清事实。

问:在论文中,您还提出了一个观点:要想进步,人工智能领域需要对智能有一个更好的定义。您认为,研究人员目前专注于静态测试性能,例如在玩游戏和下棋方面战胜人类。您为什么认为这种衡量智能的方法存在不足?

答:问题在于,一旦选定一个指标,人们会想尽一切办法改进人工智能在这一指标上的表现。例如,如果把下国际象棋作为衡量人工智能技术智能的指标(在1970至1990年代期间就是如此),最终会得到一个下棋系统,它不会擅长完成其他任务,对我们了解人类智能没有任何帮助。目前,开发擅长玩《Dota》或《星际争霸》等游戏的人工智能技术,也会落入完全相同的智能陷阱。

这种情况或许不明显,因为对于人类而言,技能和智能密切相关。人类可以利用其通用智能获得与具体任务相关的技能。一个人棋下得很好,会被认为具有相当高的智能,因为我们知道,他下棋的技能并非天生的,而是借助通用智能逐步学会下棋的。他的人生目标不是下棋。我们知道,他可以利用通用智能高效地学会完成其他任务所需要的技能。这就是通用智能的威力。

但机器存在一些限制。一台机器可以设计为专门用来下棋的。因此,我们在人类中获得的推断——“会下棋,所以一定具有智能”——就不成立了。通用智能可以生成完成特定任务的技能,反之则不成立。对于机器而言,技能不等于智能。只要能获得与特定任务相关的无限数据(或投入无限的工程资源),机器就可以掌握完成任务的技能。但这不会使它们向通用智能迈近一步。

关键的一点是,没有一种任务能让机器获得通用智能,除非是元任务——通过解决大量以前未知的问题获得新技能,而这正是我提议的衡量人工智能技术智能的指标。

谷歌旗下人工智能实验室研究人员在观看AlphaStar在《星际争霸II》中与人类玩家对战

问:既然目前这些指标无助于开发具有通用智能的人工智能技术,为什么它们会被广泛应用?

答:毫无疑问的是,在知名游戏中击败顶尖人类玩家的人工智能技术开发,主要是由媒体推动的。如果不是公众对这类华而不实的“里程碑”感兴趣,研究人员会从事其他更有意义的工作。

我认为这是令人悲哀的,因为科学研究应当解决尚未解决的科学问题,而不是作秀。如果着手借助深度学习在《魔兽争霸III》中战胜顶尖人类玩家,只要获得足够的工程技术人才和计算能力,我肯定会成功。不过,即使完成了这一目标,我对智能或归纳会有新的认识吗?这一问题的答案显然是否定的,大不了我只是会对大规模深度学习系统有更多技术方面的了解。因此,我真的不认为这属于科学研究的范畴,因为它没有使我们获得新的知识,没有解决任何悬而未决的问题。

问:您如何看待这些项目的实际成就?对它们的错误认识有多严重?

答:我发现的一个完全错误的认识是,这些会玩游戏的系统,代表着人工智能技术向着能够应对实际世界复杂性和不确定性的真正进步,其实完全不是这样。以OpenAI的OpenAI Five为例,它首先无法应付《Dota 2》的复杂性,因为它是用16个游戏角色训练出来的,而整个游戏包含有逾100个角色。它的训练量相当于人类玩了4.5万年《Dota 2》。

如果希望人工智能技术有朝一日能处理现实世界的复杂性和不确定性,我们现在就必须开始考虑这样的问题:什么是归纳?在学习系统中如何衡量和使归纳最大化?这与利用10倍的数据训练大型神经网络根本不是一回事。

问:更好地衡量智能的指标是什么?

答:总之,我们需要停止评估人工智能技术在完成特定任务中的技能,而开始评估它们获得技能的能力。这意味着仅使用系统之前不熟悉的新任务,衡量系统使用先验知识的能力以及使用样本的效率。为获得给定技能所需要的信息(先验知识和经验)越少,系统就越智能。目前的人工智能系统并非真的非常聪明。

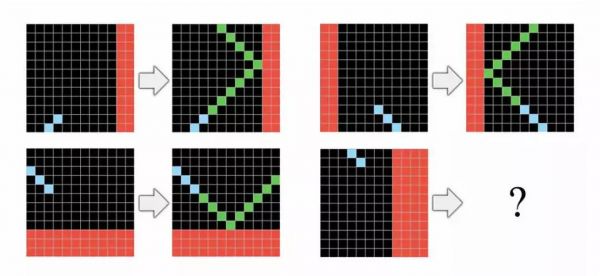

[我最近的一篇论文]提出了新的测试数据集ARC,看起来很像智商测试。ARC包含一系列推理任务,每个任务通过演示进行解释,我们应该利用演示完成任务。目前,ARC可以被人完全完成——即使没有任何口头解释或先验训练,但迄今为止没有一项人工智能技术能通过这一测试。

乔列特的ARC人工智能测试数据集

问:您认为只堆积算力人工智能技术可以继续发展吗?有些人认为,从历史上看,这一直是提高人工智能系统性能的最成功方法。而另一些人认为,如果继续只依靠堆积算力,我们很快会发现收益会出现递减。

答:对于解决特定任务而言,这绝对是千真万确的。在一个垂直任务上投入更多训练数据和算力,将使任务完成得更漂亮。但对于提高人工智能系统的归纳能力来说,增加算力无济于事。

以自动驾驶汽车为例,数以百万计的训练,不足以生成能够安全驾驶汽车的端到端深度学习模式。这就是为什么L5级自动驾驶汽车还没有问世的原因。如果深度学习模型会推理,L5级自动驾驶汽车早在2016年就该问世了。

自动驾驶汽车的发展远慢于许多人的想象

问:鉴于您讨论了当前人工智能系统面临的约束,我想问一下您对超级智能的看法——担心异常强大的人工智能系统,会在不远的将来威胁人类,您认为这样的担心合乎情理吗?

答:这一问题的答案是否定的,我不认为有关超级智能的说法有理有据。我们从未开发出完全自主的智能系统,也没有任何迹象表明我们在可预见的未来能够开发出这样的系统。当前人工智能技术的进步,不会导致这样的系统。即使在遥远的未来能够开发出这样的系统,目前我们也绝对没有办法推测它的特点。

参考资料:

https://www.theverge.com/2019/12/19/21029605/artificial-intelligence-ai-progress-measurement-benchmarks-interview-francois-chollet-google

相关推荐

谷歌高管自黑:逼得李世石退役的阿尔法狗真的不算啥

李世石退役,真的是因为走不出输给阿尔法狗的阴影?

刚刚,那个打败柯洁、李世石的阿尔法狗背后的男人,获得2019 ACM 计算奖

李世石宣布退役,高呼AI不可战胜:将举行史上首次让子人机大战

“阿法狗”之父:关于围棋,人类3000年来犯了一个错

为什么投资有时要追求“平庸的机会”?

李飞飞 PK 赫拉利:机器人要来抢对象了?

英特尔CEO:去年人工智能相关营收38亿美元

中国AI青年科学家:当天才遇上烟火气

那个AlphaGo背后的男人,获得2019 ACM计算奖

网址: 谷歌高管自黑:逼得李世石退役的阿尔法狗真的不算啥 http://m.xishuta.com/newsview15030.html