奥特曼爆冷改口:AGI没用?MIT预测2028年降临,50%概率

【导读】我们越来越接近AGI——至少看起来是这样。时间表从50年压缩到5年,更有大佬预测2026、2028年。可与此同时,AI在ARC测试的得分却是0%,在人类基本能力上依然像个新手。我们是不是太早以为,它已经准备好了?

算力膨胀、模型堆叠,提示词像燃料一样被反复输入。

AI的脚步没有停下,反而越来越快。

有人预言,AGI遥遥无期,至少要等上半个世纪。

可现在,一些关键节点被提前。

这条路,曾被说太远;可谁也没想到,它会走得这么急。

奥特曼最新观点:AGI这一词没啥意义了

十年缩成五年,AGI预言大幅提前

正如MIT Technology Review Insights刚刚发布的一篇名为「The road to artificial general intelligence」所指出的。

我们对AGI的预判,正在经历一次肉眼可见的加速。

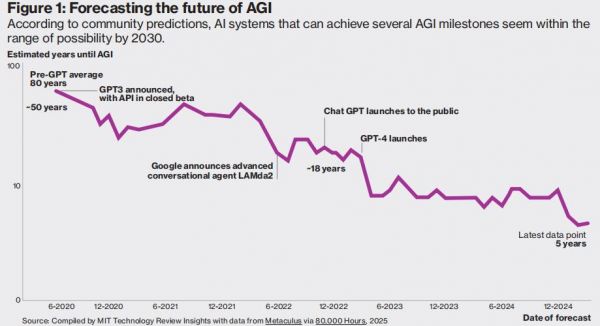

从GPT-3发布时的「50年才能实现」,到如今的「5年内可见雏形」,时间提前了数十年。

对AGI未来的预测

Anthropic联合创始人Dario Amodei提出了一个更实际、更新的表述:「Powerful AI」。

这是一种具备诺奖级智能,能够跨文本、语音与物理环境灵活切换,还能自主设定目标并完成推理执行的模型。

而他对其判断是——最早2026年,它就可能出现。

奥特曼则认为,具备AGI特征的系统「已经初露端倪」,其潜力或将带来堪比电力与互联网的社会变革。

从更宏观的数据看,预测的时间线也在明显前移。

多位预测显示,到2028年,AI实现多个AGI里程碑的概率至少为50%。

到2027年,机器在无人辅助下超越人类完成一切任务的概率约为10%,到2047年可能上升至50%。

这条被认为还需「半个世纪」的路,如今正在被重写。

超能力与短板并存,AI的八宗缺陷

今天的AI,像是一个成绩优异的天才学生。

它能背书,能考试,甚至能在高难度的专业任务中胜出。

可一旦离开考场,它就像丢了魂。

图像识别时,它会把香蕉认成吐司;做导航,它可能直冲墙上;让它接住一杯水、剪断一根线,十有八九会手忙脚乱。

这些不是笑话,而是现实。

AGI真正需要的,不只是逻辑和语言生成的能力,更需要的是「人类默认技能」。

McKinsey曾总结过AGI在模仿人类智能上的8项核心缺陷,它们几乎覆盖了我们与智能体互动的每一个维度:

1. 视觉感知:对颜色和图像变化反应迟钝,容易混淆,缺乏真正的视觉一致性;

2. 音频感知:难以处理声音的空间位置、细节特征,无法识别语调和情绪;

3. 精细动作:无法完成复杂的精细动作,比如穿针引线、外科手术;

4. 自然语言处理:只能理解句法,不理解含义,面对语境和暗示经常「跑偏」;

5. 问题解决:只能应对被定义好的问题,面对新任务几乎无从下手;

6. 导航能力:在动态现实中难以自主规划路线,无法适应环境变化;

7. 创造力:无法提出真正的新问题,也无法优化和改写自己的逻辑结构;

8. 社会与情绪理解:看不懂脸上的情绪、听不出语气的变化,更不会真正共情。

强大,但失衡;聪明,却迟钝。

这就是今天的AI——它站在我们面前,却还隔着一层看不见的玻璃。

既要跑得快,还要会协同,AI背后的算力战

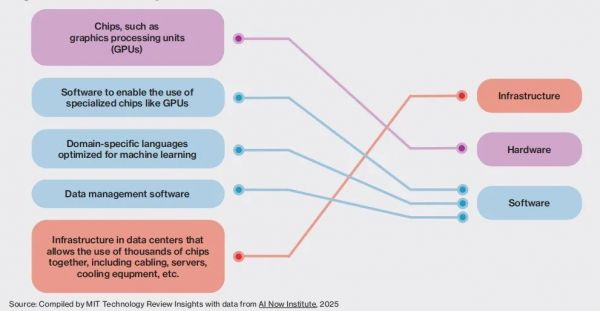

AGI不是靠一颗更大的芯片叠出来的,它需要一整套进化中的计算体系从硬件到底层软件。

从数据中心的能源结构到移动设备的资源调度,层层协同,彼此唤醒。

这场战争,已经悄悄打响。

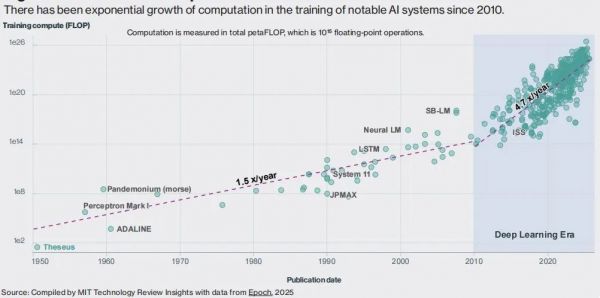

在进入深度学习时代后,AI的计算需求增速从21个月翻倍骤降到5.7个月翻倍,模型体积膨胀百倍,训练成本指数上升。

AI计算需求增长曲线

一些预测甚至认为,未来某些AGI训练任务的算力消耗可能超过一个国家的GDP。

这不仅是硬件的拉锯战,更是架构的重写。

为了适应大规模推理和实时响应的需求,AI系统正全面转向异构计算路径:CPU、GPU、NPU、TPU各司其职,把最合适的算力分配给最合适的任务。

而让这支多芯片协同作战的,是隐藏在系统底层的软件工具和软件框架。

通用AI的计算栈结构

它们负责管理、协调和调度任务,帮助开发者在不重写代码的前提下调用不同硬件、跨平台部署,优化性能同时降低能耗。

但即便如此,想靠现在这套算力栈直接堆出AGI,依旧不现实。

MIT报告指出,真正的问题不只是算得不够快,而是结构不够对。

就像Transformer曾引爆了生成式AI一样,AGI可能也需要一次架构革命。

不是再卷一个更大的LLM,而是去发明一种认知骨架,让模型像人类一样,可以在新环境中学会思考、适应、转移技能、优化自己。

而这也许正是当下最大的悖论——

我们需要更强的计算系统去支撑AGI的形成,却又需要彻底重构智能的底座,来突破单纯堆算力的天花板。

智力的真正考题,AI在ARC测试里惨败

François Chollet,也是ARC智力测试的发起人,提出了一个更苛刻的标准:

「真正的智能,是能把你已知的知识重新组合,去解决全新的问题」。

为了验证这一点,他设计了ARC-AGC的测试。

和传统测试不同,每一道题都是从未出现过的新任务。

考察的是真正的人类式推理——抽象能力、迁移能力、类比能力。

结果出人意料,纯大语言模型的得分是0%。

即便是经过额外推理优化的系统,也只拿到了个位数的成绩。

而人类,几乎能全部做对。

Chollet直白地说:

「这说明目前最强的AI模型,根本不具备灵活重组知识的能力。它们只是记忆力好,但不会真的想」。

这场测试暴露出的,不是参数不够、训练不够,而是根本方向错了。

它不是缺少力量,而是不具备「思考结构」本身。

不是更强,而是更广,AGI的最终拼图

通往AGI的路径,从来就不只一条。

但越来越多的证据开始指向同一个结论:

AGI可能不是某一个技术点的突破,而是一整套异构系统的协同崛起。

它需要更灵活的硬件结构——用对芯片,做对事,CPU、GPU、TPU、NPU各司其职。

它需要更聪明的调度框架,让这些异构芯片动态配合,不浪费一点算力。

它需要新的架构,像Transformer之于GPT,引发一次认知方式的跳跃。

它甚至需要重新建构「智能」本身。

也许通向AGI的,不是某种「更强模型」的出现,而是一次技术的集体转向。

正如MIT报告中所说:

「我们在追寻更聪明机器的过程中,可能也会第一次真正理解聪明意味着什么」

参考资料:

https://wp.technologyreview.com/wp-content/uploads/2025/08/MITTR_ArmEBrief_V12_final.pdf

本文来自微信公众号“新智元”,编辑:倾倾 ,36氪经授权发布。

相关推荐

奥特曼自曝全新GPT5细节:性能跃升超想象,算力可达AGI!

AI加速年代,谁会是降临派?

奥特曼承认了神秘gpt2

“AGI政治家”奥特曼?

奥特曼再谈DeepSeek:肯定开源模型巨大贡献,坚信人类终将实现AGI

奥特曼公布OpenAI新产品,AGI、Agents、成人模式

奥特曼回应Ilya/Jan离职,暗示GPT-5发布会推迟 |笔记

芯片战争来了:100万卡 vs 5000万卡,奥特曼、马斯克“神仙打架”

刚刚,OpenAI放弃营利性转型!奥特曼:AGI造福全人类使命不变

通用人工智能何时到来?

网址: 奥特曼爆冷改口:AGI没用?MIT预测2028年降临,50%概率 http://m.xishuta.com/newsview140414.html