AI 已经在编造历史,别把DeepSeek 们当权威

本文来自微信公众号:APPSO (ID:appsolution),作者:发现明日产品的,原文标题:《AI 已经在编造历史,别把 DeepSeek 们当权威》

最近,一条「有顶流明星在澳门输了10亿」的传闻火了,个中细节写得绘声绘色,网友们纷纷猜测,能抵押豪宅和私人飞机填补赌债的明星到底是谁。

漩涡之中,多位明星被推上了风口浪尖,杰威尔音乐、黄晓明本人下场辟谣。

最终由公安网安部门查明,此事是有人用了AI造谣。

而昨天我们体验的最新Gemini 2.0,突破了AI文生图可控性问题,指哪改哪,但也意味着图文并茂的以假乱真在使用上的门槛已经极低。

太阳底下没有新鲜事,生成式AI的本质决定了,AI有概率生成看似合理但不正确的内容。

但当AI越来越能自圆其说,越来越多的用户将AI生成的答案奉为圭臬,越来越多的有心人故意用AI编造事实,那么AI幻觉的影响,也就更加无法想象。

本就存在很多空白和创造空间的时事历史、社会热点,已经成了AI幻觉的重灾区。

AI拿捏文笔和故事,但容易编造历史

AI容易产生幻觉,是一个客观事实。文笔出众的DeepSeek,同时也有着高幻觉率。

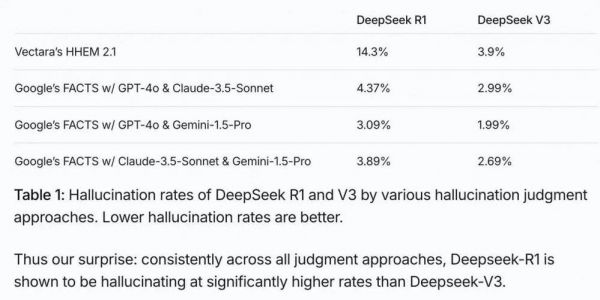

根据Vectara HHEM的AI幻觉测试,DeepSeek-R1的幻觉率达到14.3%,远高于DeepSeek-V3的3.9%。

当我让DeepSeek-R1以三国真实的历史背景写故事时,发现它的文笔和情节设计得不错,但很容易出现时间点的错误。

一个例子是,DeepSeek-R1写的魏文帝曹丕临死前的场景,提到曹丕死时是「建安二十五年冬」,然而,曹丕在黄初七年(226年)去世,建安二十五年(220年)是曹操逝世和曹丕称帝的年份。

文中提到的「十五岁那年......铜雀台大宴群臣」也是错的,曹丕15岁时是建安七年(202年),司马懿在曹操手下担任文学掾是建安十三年(208年),邺城铜雀台始建于建安十五年(210年),前后差了好几年,所以不可能发生这样一幅画面。

同样的问题,出现在DeepSeek写蜀国将领姜维的时候。这个故事的背景是成都之乱,发生在264年,姜维在228年投奔蜀国,成为诸葛亮的部下,但文中提到「二十七年前」,暗示237年姜维还在魏国,显然是不对的。

更离谱的是,当我让DeepSeek帮我想象,在乌孙生活了半个世纪、70岁返回长安两年后就病逝的西汉和亲公主刘解忧,可能会留下什么遗言,虽然奏疏写得情真意切,但它居然提到了东汉末年的蔡文姬,不符合历史顺序。

我这般咬文嚼字,确实有些为难AI。为什么大模型有幻觉呢?这是生成式AI的预测机制决定的。大模型不是数据库,它们学习的是语言模式和概率分布,而非明确存储事实,预测「下一个词最可能是什么」,而不是查询「这个事实是否正确」,它们也并不理解,输出的信息是否是真实的。

而在创意写作时,模型被激励发挥创造性,为了让故事流畅,模型会主动「填补空白」,在历史记录不足的地方创造场景和对话,不会明确区分「我确定知道的历史事实」和「为了故事合理而假设的情节」,又增加了出错风险。

AI出错很正常,但被有心人利用,就是另一回事了。历史博主@知北遊就遇到过这样的糟心事,一个网友发给她AI编的文献资料,行文风格符合当时的年代,直到她发现时间人事对不上,并动用线下的人脉去验证,才肯定都是伪造的。

每个人物的一生,都是历史的一部分。然而,一种使用AI的方式,已经打破了基本的底线。每当明星过世,会出现很多的纪念文章回顾他们的职业生涯,但其中不乏用AI浑水摸鱼的。

比如写方大同的这篇,行文一股DeepSeek味,「最后一条微博」的内容明显是和现实不符的事实错误,文末甚至明目张胆地提及,参考了材料,但进行了文学化改编,揣摩了人物的心理活动。

互联网是有记忆的,更早之前,一篇自称「梁文锋」的知乎回应,也疑似DeepSeek写就。2月6日,DeepSeek团队出来打假,表示官方账号只有三个,微信公众号、小红书、X(Twitter),其他以DeepSeek或者相关负责人名义发布信息的,都是仿冒账号。

怎么治理恶意传播不实信息的AI生成内容,已经成了微博等平台的新问题。

然而,可以想象,以后产出这类信息的速度只会越来越快,越来越多的营销号抱上AI的大腿张口就来,同时,辨别的成本也会变得越来越高,因为我们不可能在每个领域都是专业人士,总有一款虚假信息适合你。

AI的答案不等于知识,追溯源头的事实核查成了刚需

DeepSeek的爆火,真正地让很多用户知道和用上了生成式AI,同时出现了一个奇怪的现象:认为AI说的就是对的,热搜上隔三差五地出现以DeepSeek为主语的热搜,替代了从前的「专家说」。

大模型给出的信息不等同于知识,轻信AI、将AI作为权威的结果是,不走心的人类容易上当受骗。

最近就有一个现身说法的例子,上海译文出版社的陀思妥耶夫斯基精选集,推广文案里引用了「鲁迅」的评价,但这句话并不是鲁迅说的。博主@斯文稗类查证了一番,虽然没有原始出处,但一个模拟鲁迅的文心智能体的回答里,提到了这一句。

幽默的事情发生了,意识到问题后,引用了虚假评价的营销推文,把「鲁迅说」编辑成了「有人说」。

然而,以讹传讹,传的人多了,假的也就成真的了。这条所谓的「名言」已经污染了互联网,去问AI搜索,AI搜索认为是鲁迅说的。

如果虚假信息是有意为之的,那么危害就更加微妙。追踪新闻网站可靠性的NewsGuard,发现了一种引导舆论的新方式:通过大量虚假信息渗透AI模型的检索数据,从而影响这些模型对特定话题的回应。他们调查的一起事件中,AI引用错误信息的概率高达33%。

这也说明,虽然加了联网搜索之后,可以降低AI的幻觉,但也并不是绝对的。

联网搜索可以让AI获取实时信息,克服知识截止时间的局限,对于模型训练数据中罕见的主题,也能获取更准确的信息,但它也引入了新的问题,如果搜索到的信息本身就是错误的,AI可能会放大这些错误,并且难以充分评估检索内容的可靠性。

AI固然能提高效率,但查找资料这件事,反而应该变得更谨慎。我们需要更在意,某篇文章是谁写的,信息的最早出处是哪里。

更值得警惕的,是AI改变了获得情绪价值的方式

AI只是工具,它所导致的问题,根源在于人类自己。生成式AI之前,胡编乱造的信息也并不少,AI起到的作用是,让真假参半的内容生产得更快、成本更低,甚至行文更加有模有样,质量高于很多营销号内容的下限。

AI幻觉,反过来看便是AI的创造力。或者,我们可以将AI幻觉理解为「有逻辑的合理补白」。它的幻觉内容,通常符合语言、逻辑、知识的一般结构,基于训练数据分布,填补了信息空白处的「最可能内容」。

这不禁让我联想,历史有时候比想象的还荒谬、还没有逻辑,不能以常理揣度,钟会为什么反了,曹丕为什么学驴叫,尔朱荣怎么会被元子攸刺杀了......AI的补白,或许就是某种平行时空的可能性、某种历史的如果。

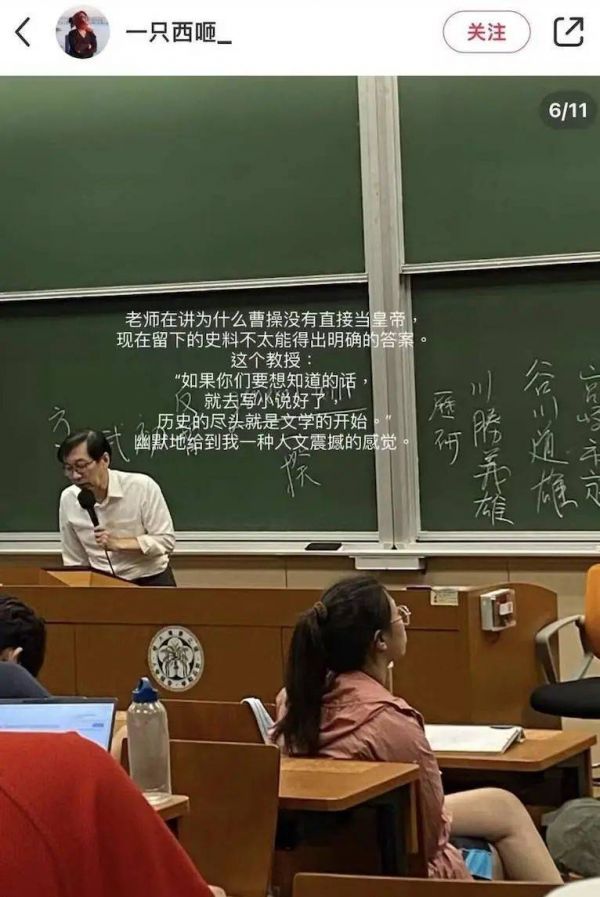

有时候,我们阅读文章和故事,不是为了汲取信息,而是为了获得情绪价值。AI就能很好地承担这个角色,弥补真实历史的遗憾,以及我们内心的「意难平」。就像一位教授所说,「历史的尽头就是文学的开始」。

我曾让DeepSeek模仿李白的风格,给杜甫的《天末怀李白》回一首诗。

我也曾让DeepSeek尝试想象,如果元稹没有死在831年的武昌任上,而是和白居易在洛阳养老,他们会怎样以诗相和。

那些用AI造假明星生平和时事热点的内容,本质也是用情绪挑动读者的神经。

AI提供答案的即时性、吐出各种文体的创造力,总让人着迷。它是很多人的焦虑来源,却也是方便快捷的告慰渠道。这也提醒着我们,警惕一个变本加厉的「后真相时代」。

「后真相」指的是,客观事实在塑造公众舆论方面的影响力,反而低于诉诸情感和个人信仰的内容。它被《牛津词典》评为2016年年度词汇,至今依然适用,甚至变得更加准确——AI内容写得出彩,就存在被传播的可能性,真实与否反而显得不重要了。

当AI可以用更快的速度制造不限量的内容,更轻松,更无痛,更真假难辨,更容易让人高度依赖单一的信息获取方式,比任何的造假信息更值得我们警惕。但这并不是AI的问题,容易失真的镜子里,照见的还是人类对于情绪价值的渴望。

我们正在招募伙伴

简历投递邮箱

hr@ifanr.com

✉️邮件标题「姓名+岗位名称」(请随简历附上项目/作品或相关链接)

相关推荐

AI 已经在编造历史,别把DeepSeek 们当权威

别把B站当“YouTube”了

DeepSeek一骑绝尘,“豆包们”怎么办?

AI手机想借DeepSeek翻红

一夜之间,微软、英伟达、亚马逊全部接入DeepSeek!吴恩达:中国AI正在崛起

苹果发布会有感:千万别把打盹儿的老虎当病猫

AI的胡编乱造,正在淹没中文互联网

DeepSeek什么来头,何以震动全球AI圈?

总台海峡时评:逆流限用DeepSeek,民进党当局搞“认知作战”只会自困井底

诺奖得主DeepMind CEO放话:DeepSeek是中国最好AI模型,但没任何科学进步

网址: AI 已经在编造历史,别把DeepSeek 们当权威 http://m.xishuta.com/newsview133753.html