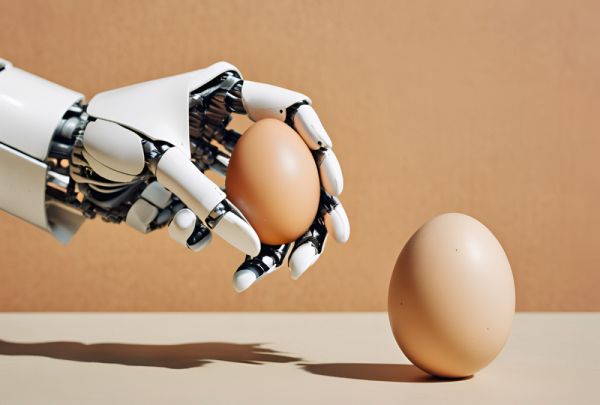

Meta AI的这些新技术,让机器人拥有“触觉”

人工智能机器人发展到今天,其拥有“视觉”或者“听觉”早已经见怪不怪。毕竟,这两种感官几乎是人类感知物理世界最重要的渠道。

而Meta AI的基础人工智能研究团队(FAIR)近日公布的新技术,则为机器人赋予了“触觉”。对此,Meta的愿景是使AI能够“更丰富地了解世界”并“更好地理解和模拟物理世界”。

毫无疑问,这些新技术让机器人又多了一种与世界互动的方式,也让其在“类人”的道路上又向前了一步。

Meta正在与美国传感器公司GelSight和韩国机器人公司Wonik Robotics合作,开发了一系列新技术,致力于将触觉传感器商业化,并将其用于人工智能当中。

这些新技术包括三个研究工具——“Sparsh”、“Digit 360”和“Digit Plexus”,专注于触觉感知、机器人灵巧性和人机交互。此外,Meta还引入了“PARTNR”,这是一种新的基准测试,用于评估人机协作中的规划和推理。

需要注意的是,这些新技术目前并未为消费者推出,而是面向科学家和研究人员的。

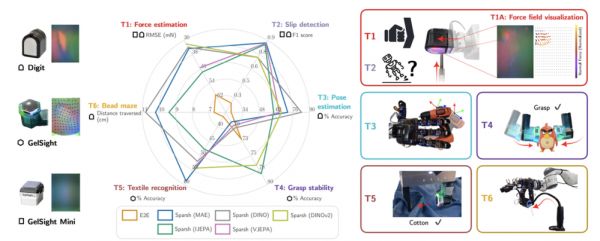

Sparsh是第一个用于基于视觉的触觉感知的通用编码器模型,由华盛顿大学和卡内基梅隆大学合作开发。

听起来似乎有些抽象,既然是“触觉”,为什么又“基于视觉”呢?

实际上,传统方法依赖于特定任务和传感器的手工模型,其需要将物体的“触摸参数”(例如力量、摩擦等等)打包成“感觉标签”喂给机器人,相当于告诉机器人什么是“轻轻地拿”或者“用力地推”。

然而这种方法比较麻烦,因为需要为每个不同的任务和不同的传感器收集很多这样的标签数据。

Sparsh则通过自我监督学习(SSL)从经验中自主学习,不需要告诉它每个动作对应的标签。其在一个包含460000多个触觉图像的大型数据集上进行预训练,这就像是让机器人看很多不同的物体和场景,然后自己学习如何识别和处理这些物体。

简单来说,Sparsh就像是让机器人通过看大量的图片和视频来自学如何“感觉”物体,而不是通过人工给它的“感觉”打标签。这样,机器人就更容易学会如何在不同的任务中使用不同的触觉传感器了。

有趣的是,“Sparsh”这个名字源自梵语,意为“触摸或接触感官体验”,这与它处理数字化触觉信号并实现触摸感知的功能非常贴切。

图片来自:Meta

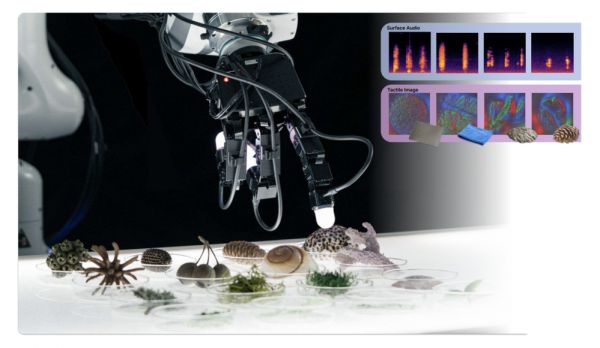

Digit 360是由Meta与GelSight公司联合开发的一种人造手指形状的触觉传感器,它通过以人类级别的精度对触摸进行数字化,能够提供丰富而详细的触觉数据。

Digit 360配备超过18种传感功能,允许研究人员结合各种传感技术或者分离单个信号以深入分析每种模式。

它可以检测空间细节的微小变化,能够捕获小至1毫牛顿的力,并且包含多种传感模式,可以感知振动、热量甚至气味,性能明显优于以前的传感器。

Digit 360触觉传感器(右).图片来自:Meta

Meta AI团队还为其开发了一种宽视场的触摸感知专用光学系统,由超过800万个传感器单元(taxels)组成,用于捕捉指尖表面的全向变形。

此外,借助设备上的人工智能加速器,Digit 360能够快速处理信息,对触摸刺激做出反应,可以充当机器人的周围神经系统。这一设计的灵感来源于人类和动物的反射弧。

显然,除了提高机器人的灵活性以外,这款传感器在医学、假肢、虚拟现实和远程交互等领域都有广阔的应用前景。

图片来自:Meta

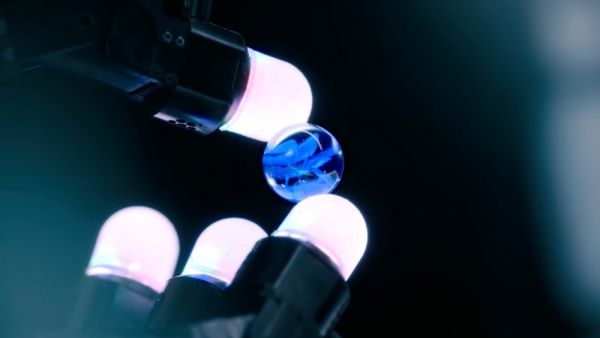

Meta在博客中说道:

人手非常擅长向大脑发出从指尖到手掌的皮肤触摸信息,这使得其在作出决定时能够激活手部肌肉,例如如何在键盘上打字,或者与过热的物体交互。实现嵌入式人工智能需要机器人手上的触觉传感和电机驱动之间的类似协调。

基于这个理念,Meta AI与Wonik Robotics合作,提出并建立了一个标准化软硬件平台Digit Plexus。

它允许将各种指尖和皮肤触觉传感器(例如Digit、Digit 360和ReSkin)集成到一个机器人手中,并通过一根电缆将触觉数据编码并传输到主机计算机中,以实现无缝数据收集、控制和分析。

Plexus系统的设计旨在简化机器人应用的开发,特别是对于那些需要精细触觉反馈的应用。通过使用Plexus,开发者可以更容易地将触觉传感器技术集成到他们的机器人项目中,从而提高机器人的灵巧性和对物理世界的感知能力。

图片来自:Techcrunch

值得一提的是,Meta与Wonik的下一步合作重点是开发Wonik的新一代Allegro Hand,这是一款配备Digit 360等触觉传感器的机器人手,它将在Digit Plexus平台上运行。

图片来自:XELA

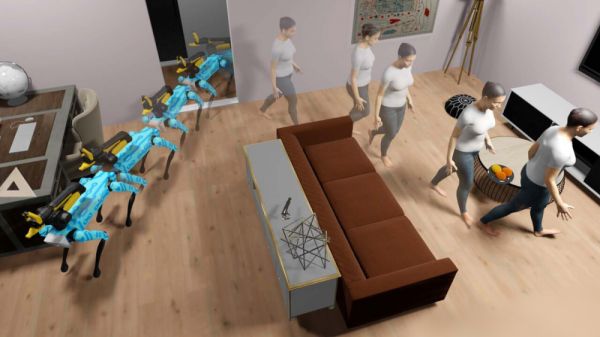

为了研究家庭活动中的人机协作,Meta在Habitat 3.0(一个用于研究家庭环境中人机协作任务的模拟平台)的基础上,发布了人机协作规划和推理任务基准PARTNR。

PARTNR是同类中最大的基准,包含100000个自然语言任务,涵盖60栋房屋和5800多个独一无二的对象。该基准的目标是评估大型语言和视觉模型(LLMs/VLM)通过人机交互工具与人类协作的性能。

通过提供标准化基准和数据集,Meta表示“希望它能使机器人的研究不仅能够独立运行,而且能够围绕人类运行,使它们更加高效、可靠,并且适应每个人的喜好”。

图片来自:LinkedIn

让机器人拥有“触觉”,并不是一座“空中楼阁”。

这些机器人对外界变化拥有远超人类的敏感度,配合高效的软硬件协作系统,他们将会在外科手术或者精密仪器制造场景中大有用武之地。

其实,不仅“视觉”、“听觉”和“触觉”,宾夕法尼亚州立大学的研究人员已经在人工智能模型模拟出了“味觉”;同时,一家名为Osmo的公司已经教会人工智能模型如何模仿远优于人类的“嗅觉”。

也许未来的机器人能够在感官方面完全“复刻”人类。只是他们最好不要再拥有逼真的“人形”,否则,恐怖谷效应要犯了。

相关推荐

Meta启示:AI是通往元宇宙的关键变量

36氪首发 | 触觉传感器公司帕西尼感知科技获陆奇天使轮融资,触感技术是Meta元宇宙重点

Meta 正在研发触觉手套,为元宇宙提供触感交互

发布不到24小时就被打脸,Meta要「改变世界」的元宇宙触觉手套是抄的?

在元宇宙听不懂外语怎么办?Meta:新技术可翻译128种语言

Meta研究类似皮肤新材料和传感器,可帮助实现元宇宙雄心

Meta研究类似皮肤新材料和传感器 可帮助实现元宇宙雄心

机器人也能有触觉:北航造了根机器手指,纹理识别准确率100%

让截肢者能握拳、能撸猫:MIT和上海交大发明充气机械手,还拥有触觉

自研AI触觉芯片,「他山科技」为智能座舱提供更低成本的解决方案

网址: Meta AI的这些新技术,让机器人拥有“触觉” http://m.xishuta.com/newsview127912.html