如何解决大模型的信任问题?

以ChatGPT为代表AI大语言模型(LLMs)是一项具有革命性的技术。它不仅可以像之前的人工智能一样进行分类或预测,还可以通过自然语言与人类对话,生成文本、图像、视频、可执行代码等各种形式的内容,这将对人们的生产生活和社会发展产生深远影响。但是人工智能开发和应用阶段的任何错误都可能是灾难性的。[1]

现在大语言模型已经面临诸多信任挑战,比如人们越来越无法分辨区分出ChatGPT生成的内容与人类生成的内容;大语言模型存在幻觉问题,会生成错误、具有诱导性的内容,那么人们该如何分辨并信任大语言模型生成的内容;大语言模型还存在偏见、歧视、隐私侵犯、有害言论等多方面伦理风险,继而带来一系列信任危机,甚至遭到业界的抵制和封杀。信任是人工智能发展的一个核心问题,人与技术之间信任关系更是技术发展趋势与人类未来的一个核心问题。[2]DeepMind首席运营官Lila Ibrahim表示,AI大模型是一种变革性技术,但它只有在得到信任的情况下才能充分发挥潜力。

过去人工智能科学家和科技企业提出可信人工智能的技术框架并开展了大量研发实践。然而,即使科技企业认为他们的人工智能系统是值得信赖的,个人或团体是否愿意冒险并给予它们信任仍然悬而未决。可见从可信到信任,仍然存在较大鸿沟。AI大语言模型正在引领通用人工智能,甚至超人工智能的到来,但是信任问题正在阻碍大语言模型的技术创新与应用。[3]IBM调研全球近1000名企业高管,研究表明阻碍其企业部署应用AI大模型的主要因素是信任问题。[4]因此,建立信任,已经成为AI大语言模型创新发展与应用的必要前提。

一、从可信AI到信任AI:需要跨越的鸿沟

为了应对AI的信任危机,业内积极开展可信AI的探索,旨在确保AI系统的安全性、可解释性、公平性和隐私保护。但是可信AI的理念和大量实践仍然无法使人们信任AI,也就是说从可信AI到信任AI存在一个一个需要跨越的鸿沟。这里需要厘清信任与可信任的关系,并且回到技术本身,从其技术特性和人机关系来寻找建立大语言模型信任的入口。

(1)可信AI的发展现状及困境

2017年,何积丰院士在全球范围内首次提出“可信人工智能”(Trustworthy AI)的概念。可信AI的研究范畴主要包含安全性、可解释性、公平性、隐私保护等。安全性、可解释性、公平性、隐私保护也成为了评价一个人工智能系统是否可信赖的技术评估标准。[5]由此,“可信AI”逐渐成为了学术界和产业界的共识。

首先,可信人工智能领域论文发展量在人工智能论文发表量占比逐步提升,其中美国、中国、英国是全球可信人工智能论文发表的主要国家,这与国家人工智能科研实力、产业发展和应用水平密切相关。[6]

其次,可信人工智能的专利申请量也在快速增长。[7]在专利技术分布上,隐私保护、安全性方面的专利占据较大比例,可解释性和公平性占比较小。

再次,各国政府、国际标准组织和行业组织积极推动建设可信人工智能原则和标准,比如欧盟《可信人工智能伦理指南》、美国《促进政府使用可信人工智能》、ISO/IEC《信息技术人工智能人工智能可信度概述》、IEEE《可解释性人工智能结构框架指南》和《金融服务可信数据和人工智能系统》、中国人工智能产业发展联盟《可信AI操作指引》等。这些原则和标准,都在指引从业者如何研发设计出一个值得信赖的人工智能系统。甚至其中有些要求变成了硬性的法律法规或者行业的合规要求,比如即将实施的欧盟《人工智能法案》要求高风险的人工智能系统必须进行全面的风险评估,以确保安全性。

最后,人工智能产业积极落地可信AI,贯穿研发、应用、运营等全部流程。比如,可信AI在智能医疗设备、智能驾驶、智能机器人等产品设备领域均已落地,建立了安全性、合规性、可解释性等兼具的功能体系。

虽然业界在可信人工智能方面做了大量的努力,但人们对人工智能的信任状况仍然不容客观。2022年4月,香港消费者委员会发布的一项研究显示,亚洲市场上只有31%的消费者表示他们信任人工智能。[8]2023年,毕马威与昆士兰大学就人们是否信任人工智能联合开展了全球调查研究,选取了17个国家和地区超过17000人口的样本数据,结果显示只有50%的人选择信任人工智能,其中人们通常不信任和接受人工智能在人力资源中的应用。[9]

(2)信任与可信任的混淆与关系厘清

如何跨越可信任到信任的鸿沟,需要厘清信任与可信任之间的关系。可信AI的发展,问题着眼于“是什么让人工智能值得信任”,其理论前提是“我们信任可信任的事物”。然而,信任的运作方式并不如此,这就不免存在混淆信任与可信任的问题。[10]

西方学者关于信任的研究由来已久,比如信任是相信他人未来可能行动的赌博(Coleman 1990)。鲁索(Denise Rousseau)认为:“信任是一种心理状态,包括一方对另一方意图或行为的积极预期,以及愿意接受损失的意愿。”[1998]信任涉及委托人和受托人的关系以及委托人对受托人履行期望的信念,它包含两种要素:信心、承诺。然而,人们可能信任完全不值得信任的事物,也可能不信任完全值得信任的事物。所以,信任与可信任是两码事。[11]

首先,人们信任人工智能可能与可信AI的几大要素毫无关系。比如,企业在设计AI语言助手时,会从声音、外形等角度考虑,使人们更信任AI。电影《切割机器人》导演William Tannen认为,机器人的声音要变得“可爱”,这样才能为人们所接受和信任,而女声比男声有优势,这就是为什么智能助手中女声占绝大多数。[12]又比如,1966年麻省理工大学团队开发的AI聊天系统ELIZA在一场图灵测试中打败了OpenAI开发的最先进的大语言模型GPT 4,获得了更高的通过测试成功率,一些测试者认为ELIZA表现的太差,以至于不可能是当前先进的AI大模型,更可能是一个故意不合作的人类。[13]

其次,信任和可信度是脱节的。某事可能完全值得信任,但人们仍然不会信任它,因为信任是可以赢得的,但也必须被给予。也就是说,可信AI理论设想的“可信任会自动实现信任”并不一定会实现。开发人员在AI产品的可信任方面做出大量努力之后,但用户可能仍然不信任它,更不用说使用它,这会让开发人员非常挫败。[14]

最后,可信任存在被泛化的问题,与建立信任的初衷不一致。不管是可信AI的技术要求,还是各国出台的可信AI指南、原则的文件中,“可信任”都与一系列原则相关联。这里似乎表明了一切被认为“好”的东西都应该促成信任,并且这些“好”的东西被视为AI值得信任的必要条件。这会导致,人们期望可信AI能够符合人们认为在人际、社会和政治层面上应该符合的公平、正义、可控等所有原则,从而将可信任变成了一个不适用或不可操作的流行词。

可见,信任与可信任的关系并不是可信AI理论预设的“可信任的AI会获得人们的信任”,但是这也并不能完全否定可信AI为建立信任的积极作用,应当重新思考人们在何种意义上、何种情况下会信任AI,人与AI的信任关系是什么,除了现有的可信AI,还需要做什么?

(3)作为一种认知技术的大语言模型

为什么可信人工智能领域的诸多努力似乎并没有达成人们信任人工智能的目的?这里可能需要从人工智能这项技术本身来寻求答案。以自动驾驶汽车为例,人对自动驾驶汽车的信任不同于人对传统汽车的信任。公式表达为:

(i)人对传统汽车的信任是“A信任B”;

(ii)人对自动驾驶汽车的信任是“A信任B做X(或不做Y),当Z属于...”;

(iii)A和B是信任关系中的主体和客体,X是一个特定动作,Y是另一个比较类的动作,Z是上下文语境或特定场景。

在传统汽车的信任场景中,人们只需要知道汽车是安全可靠的,便可以信任地驾驶这辆汽车,这种对技术的信任相对简单、易把握;而在自动驾驶汽车的信任场景中,自动驾驶汽车被信任的是执行一项认知任务,如行驶决策等。这里对技术的信任则包含了更多复杂的要素。由此可见,我们需要信任的人工智能不同于以往的技术,它能够执行数据分析、语言理解和生成、知识获取、概率评估、分类、预测、推理和映射等认知任务。马歇尔·麦克卢汉提出“一切的技术都是人的延伸”。人工智能本质上是一种认知技术,是对人的认知能力的延伸和增强。

以ChatGPT为代表的大语言模型作为一种前沿的认知技术,正在引领一场知识和文化的革命。这些模型通过处理和生成自然语言,不仅重塑了知识的生产、获取和传播方式,而且正在渗透到人类文明的核心,影响着我们的思维、信仰和文化构成。前美国国务卿基辛格指出:“ChatGPT为代表的生成式AI将重新定义人类知识,正试图改变人类认知过程,这预示着一场知识革命的到来。”[15]

大语言模型在几乎涵盖了互联网和人类所有知识库的大数据基础上进行训练,具备理解和生成自然语言的能力,它不仅能够捕捉自然语言的复杂性和多样性,而且能够在某种程度上理解语义和语境。语言是构成人类认知和文化的基石,也是人们传递信息、信仰和价值观的主要工具。而ChatGPT和更先进的AI大模型正在以超过人类水平的能力掌握语言,能够理解、生成和处理自然语言就有能力参与到文化创造和传播中。尤瓦尔·赫拉利发出警示:“人工智能大模型入侵了人类文明的操作系统!它将能够改变人类思考、感受和行为的方式,创造一种新的认知和文化。”[16]

人类以“知识--信念”为基础建立了一套认知框架,而文化是在这套认知框架基础上建立起来的“认知符号系统”。它不仅是一套传统、习俗和道德观念,还是一种高度复杂的信息编码方式,可以在人类社会传播,并影响个体和群体行为。文化是人们用来解释、理解和互动现实世界的一种“模拟现实”。每一种文化都是对现实的一种解释和评价,它涉及到价值观、信仰、人类关系,乃至人类与自然、与宇宙的关系。而未来所有知识,无论是过去的、现在的还是未来的,都有可能通过单个通用大模型获得。多明戈斯将其称为“终极算法”。[17]

目前,大模型破解了人类语言,成为知识的新来源,并逐步展示出其作为文化构建者的潜力。不仅未来有可能成为文化的一部分,甚至可能改写人类文化和认知的基础规则。那么,当人们使用大语言模型做某项工作时,按照唐·伊德(Don Ihde)所提出的人与技术关系,人与大模型可能呈现为以下三种关系:1)具身关系[(人—大模型)→世界)],即大模型作为人的功能性延展,去认知世界并实践;诠释关系[人→(大模型—世界)],即人类认知世界,是经过大模型的表征、转换或诠释;它异关系[人→大模型—(世界)],侧重技术的自主性,即大模型成为认知的客体时,透过大模型展现的世界就变成了一种技术人工物。

作为认知技术,大语言模型重塑了人类的认知方式,促使我们重新思考和定义人机关系及其信任基础。因此,构建对大语言模型的信任,应从其技术特性,以及人机关系入手。

二、认知信任:一种对大语言模型的特殊信任

以认知信任的概念和大语言模型作为一种认知技术为基础,文章进一步论证对大语言模型的信任,是一种基于人际信任和技术信任的动态交互、基于有效监督的具有合理性的认知信任。

(1)认知信任的构成

托斯顿·威尔霍尔特(Torsten Wilholt)在探讨科学作为集体认知事业成功运作所必需的要素时,提出了认知信任(Epistemic Trust)的概念,即认知信任是一种严格根据接收者作为信息提供者或知识传递者的能力来分配的信任。[18]按照认知信任的定义,拉蒙·阿尔瓦拉多(Ramón Alvarado)认为,既然人工智能作为一种认知技术,能够扩展增强人类的认知能力,那么人们信任人工智能时就是在相信它作为信息提供者或认知增强工具的能力,因此人们给予人工智能的信任应是一种认知信任。[19]

认知信任包括四个组成部分:信念、沟通、依赖和信心[20]。其中信念和沟通具有独特的认知属性,依赖和信心是构成任何类型信任的核心:

1)信念是认知信任的基础,指信任方(H)对被信任方(S)提供的信息或知识的真实性和可靠性持有的认知态度。这种信念基于对被信任者知识、能力或诚信的评估;

2)沟通是建立和维持认知信任的关键机制,涉及信息的传递和接收。良好的沟通能够增强信任,因为它帮助H理解S的知识基础、推理过程和结论。比如,人工智能的透明度和可解释性;

3)依赖是信任过程中的一个核心要素,指H对S履行其承诺或提供的信息进行依赖。在认知信任中,这种依赖不仅是行动上的,也是认知上的。用户对自动驾驶汽车驾驶决策的安全性的信任体现了对该技术的依赖;

4)信心是H对S将如预期行动的确信度,这种确信基于对被信任者过去行为的观察、评价和预期的一致性。一个长期提供准确预测的AI天气预报系统,能够使用户对其预报内容持有高度信心。

如图1所示,AI大语言模型信任涉及的相关方不仅包含用户与AI,还包括用户与技术研发机构、研发人员、机构管理者等。因此,信念、沟通、依赖和信心等认知信任的四个组成部分,也将在不同的关系之间有不同的含义与呈现。

图1:人与人的关系、人与AI之间的关系、AI背景下人与人的关系

(2)技术信任与人际信任动态交互

人们在使用某项技术工具时,不仅要求该技术工具能够满足他的实际需要,而且需要确定技术是安全可靠的。这种对技术的信任通常关注的是个体对技术能力和性能的信任,即技术信任,它基于技术的可靠性、稳定性和预期的表现。过去在技术信任中,技术被视为一个静态对象,其信任度量基于技术的历史表现和预期的未来性能。然而,AI大语言模型技术极其复杂且具有黑箱属性,技术专家也无法完全确定其内部工作原理,更何况普通用户。只有信任才是应对技术不确定和不能控制未来的至关重要的策略。[21]

虽然以可信AI框架为基础,大语言模型具有稳健性的基础,在帮助人们完成任务这一点被认为是“可靠的”。[22]但此时对大语言模型的技术信任却不是静态的、确定的,抑或是在人们无法充分理解技术的情况下充满了随机性。人—机—环境交互系统的主客体界限常常模糊,具有个别性、人为性、异质性、不确定性、价值与事实的统一性、主客相关性等特点,其中充满了复杂的随机因素的作用,不具备重复性,因此在充满变数的人—机—环境交互系统中,存在的逻辑是与各种可能性保持互动的同步性。[23]比如,人们在与ChatGPT对话时,在不同时间问同样的问题,每次得到的答案都不是完全一样的,这便是由于模型的随机性、训练过程中数据的多样性、输入的变化以及模型运行环境变化等多重因素导致的。

因此,用户与大语言模型之间的信任建立存在一个相互调节的过程。[24]不仅要求大语言模型自身的可信度,还需要用户给予信任,即用户主观感知与大语言模型客观能力的调节匹配。回到图1的视角来看,用户主观感受、给予信任无法隔绝人际信任产生的影响。

人际信任是基于个人之间的关系,涉及对他人善意、正直、可靠性和能力的信任。与技术信任不同,人际信任是一个动态的交互过程,它依赖于持续的社会互动和沟通。人际信任建立在个体间相互了解和信任的基础上,包括了对他人行为的预期和对其意图的理解。例如,一个团队成员可能会基于过去的合作经验和对方展现的诚信来信任其他成员。

在“人—机—人”的关系之中,人际关系不仅包含人与人之间的关系,更涉及技术背景下人与人之间的关系。在使用者、研发者、管理者等之间的人际信任之中,大语言模型技术本身已经成为一个重要的变量深度介入人际信任之中。[25]在充满随机性的环境中,人与大语言模型之间的信任需要人际信任来背书,人与人之间的信任也面临被调节甚或被技术导引、规制的情形。

对大语言模型的认知信任是技术信任与人际信任的综合,即人对技术的心理预期与技术自身效能的一种混合交互、相互调节的结果。人在多大程度上信任人工智能,该对人工智能分配多少信任。在这种模式中,人们对AI的信任不仅基于技术本身的性能和可靠性,也涉及对技术背后人类研发团队的信任,包括开发者的意图、责任感和能力。这种信任是动态的,因为它需要考虑到技术的发展、学习能力和在不同情境下的表现,以及用户与技术之间的互动和沟通。

(3)基于有效监督具有合理性的信任

人与人之间的人际信任可以是无监督的,即无条件信任、盲目信任。但是人对大语言模型的认识信任如果是无监督的,可能导致以下两种不良情形。

a. 没有可信度的信任,即错误的信任。首先,大语言模型能够帮助人们提升生活工作效率,但是它的智能化、自动化特性可能导致人类过度依赖机器,进而侵蚀人的自主性。典型的便是ChatGPT的幻觉问题。AI幻觉主要是指大语言模型出现错误或者偏差,导致生成不准确、错误甚至荒诞的结果,它生成一个看似正确实则错误的答案,让过度信任AI的人产生幻觉,将事实上错误的答案当作是正确的。其次,开发和应用大语言模型的组织往往会标榜其系统是可信任的,能够负责任地处理数据、确保系统安全性和公平性等。用户往往由于该组织过去有较高的商誉而缺乏谨慎态度,选择信任这些组织,而实际上他们并不值得信任,那么人们就会因为错误信任而引发潜在风险。

b. 值得信赖但不被信任,即不合理的不信任。如果技术悲观主义者、或风险偏好较为保守的人们不信任实际上值得信赖的技术,就会承担错失利用好技术的机会成本。与此同时,对新兴技术的不信任不仅限制了其在现有领域的应用,还可能抑制未来创新的动力。当开发者和研究人员感觉到公众对他们的工作持怀疑态度时,可能会减少对具有潜在的革命性技术的研发和投入。

2024年2月,英国政府发布《人工智能保障入门》(Introduction to AI assurance)指南文件,提出建立对人工智能的合理的信任。[26]文件指出,如何保障建立对人工智能合理的信任,人工智能开发及应用的组织必须克服两个关键问题:一是信息问题,组织需要可靠且一致地评估AI系统是否值得信任,以提供人们是否应该信任它的证据基础;二是沟通问题,组织需要将他们的证据传达给其他用户,并在适当的复杂性水平上转译这些证据,以便他们可以相应地决定他们的信任或不信任。文件还提出建立如AI审计师等第三方保障供应商去促成信任的建立。

三、大语言模型信任的建构路线

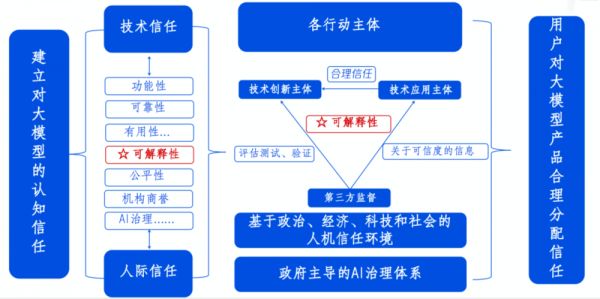

图2:LLMs信任路线图

通过前文的分析总结,将人工智能信任定义为一种涵盖了动态交互的人际信任和技术信任的、基于有效监督的具有合理性的认知信任,进一步提出建构实现大语言模型的信任路线图。路线图主要包括信任要素、信任主体和信任环境、以及信任认知三个方面,并就以上三个方面提出具体实施建议。

(1)搭建以可解释性为核心的信任构成要素

欧盟AI高级别专家组提出人工智能信任应具有三个主要部分:AI技术本身;AI开发、部署和应用背后的设计者和机构组织;AI生命周期涉及的社会技术系统。[27]微软CEO萨蒂亚·纳德拉(Satya Nadella)也明确指出,要利用技术创造积极影响,人们需要能够信任他们使用的技术及其背后的公司。[28]那么,技术及其背后的公司该如何做,或者具有什么要素条件,才能建立信任呢?

彼得(2005)曾经就此提出两类被期望的行为:

第一类,我们可能只期待他人所做行动的工具性品质,包括规律性(有序性、连贯性、一致性、持续性)、合理性(为行动提供依据和正当理由、可接受的论据)、效率(能力、连贯性、纪律、恰当的表现、有效性)。当信任建立在工具性期望之上时,可称之为工具信任,也即技术信任;

第二类,我们可能期望他人的行动具有一些道德品质,包括期望对方是负责任的(合规的、诚实的、正直的),期望对方对我们是好心的、温和的、仁慈的,期望对方是可信的、坦白的,期望对方是公平公正的(采用普适的标准、相同的要求、公正的程序)。当信任建立在道德期望之上时,可称之为价值论信任,也即人际信任。

以此为启发,建立对大语言模型的信任,应当包括技术信任的信任要素和人际信任的信任要素,其中技术信任主要包括功能性、可靠性、安全性、可解释性等要素;人际信任主要包括机构商誉、企业社会责任和形象、公平性、企业AI治理体系和制度等。

在诸多信任要素中,需要以可解释性作为核心,它不仅是技术本身的可解释性,也是信任的可解释性。可解释性作为价值载体,内含透明性、安全性、可理解性、可责性和公正性,并指向技术的可验证、可审核、可监督、可追溯、可预测与可信赖等多个方面,连结与贯通技术信任、人际信任的要素体系,促进技术信任与人际信任的动态交互。

其一,业界研究明确显示,通过AI系统的可解释性,可以增加用户的信任。[29]AI大模型只有有效地“解释”自己,才能取得用户的“信任”,从而产生高效的人机协作。[30]

其二,托马拉和霍夫曼提出作为一种“看不见的假设”的道德信任,委托人与受托人的信任基于共同的权利与义务。“看不见的假设”被转化为语言陈述的过程涉及三方面:其一,需要提高信任的可解释性;其二,涉及可理解的信任形式;其三,期望实现的形式是否可被接受。提高信任的可解释性意味着受托人与委托人关系的高度透明,对其意向、善意等达到深入认识。[31]

其三,根据利益相关者的动机、意图和要求不同,AI解释内容、方法/模型也应不同,应建立基于相关利益者分类的可解释性框架。[32]这里涉及:(a)由谁解释,一般为大语言模型的技术提供者;(b)向谁解释,向利益相关者进行解释,包括用户、政府和社会等;(c)解释什么,主要包括技术原理、功能的等专业性解释,价值与影响等社会普遍关注的价值性解释,涉及安全解释、责任解释、公平解释、影响解释等具体方面;(d)如何解释,各种解释须融入AI大模型全生命周期。

目前通过可解释性建立信任的路径已经获得了官方认同。2023年,亚马逊、Anthropic、谷歌、、Meta、微软、OpenAI、Adobe、IBM、英伟达、Stability等多家公司已签署拜登总统关于人工智能安全自愿承诺协议,其中一大重点便是建立公众对开发该技术的公司的信任,以及它们的工作方式和收集的信息是透明的。

协议规定了旨在建立公众信任的一系列义务,包括:保证人工智能生成的内容添加水印;企业将提供有关其产品功能和局限性的明确信息等。谷歌也随后发布了新技术ASPIRE,该技术的主要原理是让AI模型先回答问题,然后再自己检查答案是否正确。通过这种自我评估,模型能更准确地区分正确和错误的答案并给出信心分数。

无论模型大小,它都能帮助提高准确性。ASPIRE帮助AI模型更好地判断它们的答案是否正确,并且只在比较有把握的时候给出预测。在ASPIRE的帮助下,模型不仅能给出答案,还能同时提供一个与答案配对的信心分数,即模型对自己答案的自信程度。通过提供信心分数,模型能够表达自己对于答案的不确定性。这种透明度对于用户来说是非常有价值的,尤其是在涉及重要决策的情况下。[33]

(2)以政府主导的AI治理体系为基础,建构多主体协同的信任环境

任何信任的建立都离不开一个良好的信任环境。信任环境包括了一系列的社会、文化、经济和技术因素,这些因素共同作用,形成了个体或集体之间建立信任的基础。[34]建构大语言模型的信任则需要政府主导的AI治理体系为基础,多元主体参与,以此达成有效监督。

首先,政府治理和监管对建立大语言模型至关重要。有实证研究显示,人们相信当监管工具到位时,人工智能更值得信任。[35]

其次,多元主体参与的治理机制和工具,将为大语言模型的信任建立提供有效抓手。政府的治理与监管受限于技术和人力投入,因此需要多元主体参与。比如,2021年英国政府发布《建立有效的人工智能认证生态系统的路线图》,计划在未来5年培育一个世界领先、市场规模达到数十亿英镑的AI认证行业,通过中立第三方的AI认证服务(包括审计、影响评估、认证等)来评估AI系统的可信合规性。我国在《科技伦理审查办法(试行)》中明确提出建立人工智能的伦理审查制度,确立人工智能的研发与应用主体责任与问责流程,打造以人为本,负责任的、对人类和生态有益的人工智能。

(3)培养人们对AI大语言模型的信任认知,能够合理分配信任

建立对大语言模型的信任,不仅需要技术研发与应用组织通过提升技术可信度和机构可信度来积极争取,还需要用户基于对技术的认知并给予合理的信任。人们对AI系统的认知和理解程度与能够给予信任密切相关。[36]此前有研究指出,理解和培养人们对AI系统的信任是一个重大挑战,因为人们缺乏对技术的理解和认知。[37]

用户作为大语言模型技术的使用者,也是技术风险的直接承担者。首先,教育和提高公众对AI技术的理解至关重要。用户需要能够客观地评估技术的优势和潜在风险,避免因盲目信任或过度怀疑而做出不合理的决定。正确的认知可以帮助用户在理解技术的同时,对其潜在的影响和风险有一个合理的评估。

其次,信任是一个认知可能风险,并且愿意接受由此带来损失的过程。建立和维持信任需要一个持续的、动态的过程,旨在平衡信任和对风险的认识。而人们往往是风险厌恶型,需要建立正确的信任观。这就需要社会传播普及关于大语言模型的信任与不信任的问题与案例,消除公众对信任的误解。

参考资料:

[1]Jain S,Luthra M,Sharma S,et al.Trustworthiness of artificial intelligence[C]//2020 6th International Conference on Advanced Computing and Communication Systems(ICACCS).IEEE,2020:907-912.

[2]闫宏秀.用信任解码人工智能伦理[J].人工智能,2019,(04):95-101.

[3]Braun M,Bleher H,Hummel P.A leap of faith:is there a formula for“Trustworthy”AI?[J].Hastings Center Report,2021,51(3):17-22.

[4]IBM商业价值研究院.生成式AI市场现状[R/OL].https://www.ibm.com/downloads/cas/7KX4Q06G

[5]陶大程.可信AI的前世今生[J].智能系统学报,2021,16(04):601.

[6]中国信息通信研究院.可信人工智能产业生态发展报告2022[R/OL].http://221.179.172.81/images/20220906/3741662451673713.pdf

[7]中国信息通信研究院.可信人工智能产业生态发展报告2022[R/OL].http://221.179.172.81/images/20220906/3741662451673713.pdf

[8]香港消费者委员会.道德与信心共融促进电子商务人工智能发展[R/OL].https://www.consumer.org.hk/f/initiative_detail/415531/435406/AI%20Study%20-%20Presentation%20(Chinese).pdf

[9]KPMG,University of Queensland.Trust in Artificial Intelligence:A global study[R/OL].https://assets.kpmg.com/content/dam/kpmg/au/pdf/2023/trust-in-ai-global-insights-2023.pdf

[10]Reinhardt K.Trust and trustworthiness in AI ethics[J].AI and Ethics,2023,3(3):735-744.

[11]Daukas N.Epistemic trust and social location[J].Episteme,2006,3(1-2):109-124.

[12]http://sshpw.net/news/?id=390&nm=634476161289

[13]Jones C,Bergen B.Does GPT-4 Pass the Turing Test?[J].arXiv preprint arXiv:2310.20216,2023.

[14]Costanza-Chock,S.:Design Justice:Community-led Practices to Build the Worlds We Need[M].The MIT Press,Cambridge(2020)

[15]Henry Kissinger,Eric Schmidt,Daniel Huttenlocher.ChatGPT Heralds an Intellectual Revolution[EB/OL].2023-02-24.https://www.wsj.com/articles/chatgpt-heralds-an-intellectual-revolution-enlightenment-artificial-intelligence-homo-technicus-technology-cognition-morality-philosophy-774331c6

[16]Yuval Noah Harari.Yuval Noah Harari Argues that AI Has Hacked the Operating System of Human Civilization,[J/OL]The Economist,2023-04-28.https://www.economist.com/by-invitation/2023/04/28/yuval-noah-harari-argues-that-ai-has-hacked-the-operating-system-of-human-civilisation.

[17]佩德罗·多明戈斯.黄芳萍,译.终极算法:机器学习和人工智能如何重塑世界[M].北京:中信出版社.2017.

[18]Wilholt T.Epistemic trust in science[J].The British Journal for the Philosophy of Science,2013.

[19]Alvarado R.What kind of trust does AI deserve,if any?[J].AI and Ethics,2023,3(4):1169-1183.

[20]McCraw B W.The nature of epistemic trust[J].Social epistemology,2015,29(4):413-430.

[21][波兰]彼得•什托姆普卡.程胜利,译.信任:一种社会学理论[M].北京:中华书局,2005(P32).

[22]闫宏秀.负责任人工智能的信任模塑:从理念到实践[J].云南社会科学,2023(04):40-49.

[23]郭雷.系统科学进展3[M].北京:科学出版社,2023(P123-158).

[24]闫宏秀,宋胜男.智能背景下的算法信任[J].长沙理工大学学报(社会科学版),2020,35(06):1-9.

[25]闫宏秀.负责任人工智能的信任模塑:从理念到实践[J].云南社会科学,2023(04):40-49.

[26]https://www.gov.uk/government/publications/introduction-to-ai-assurance/introduction-to-ai-assurance#ai-assurance-in-context

[27]HLEG AI.(2019).Ethics guidelines for trustworthy AI.Retrieved from High-Level Expert Group on Artificial Intelligence.

[28]https://www.linkedin.com/pulse/my-annual-letter-leading-new-era-satya-nadella/。

[29]Burstein J,Doran C,Solorio T.Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics:Human Language Technologies,Volume 1(Long and Short Papers)[C]//Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics:Human Language Technologies,Volume 1(Long and Short Papers).2019.

[30]朱松纯.“为人文赋理,为机器立心”,朱松纯教授在图灵大会阐释“通用智能·人机共生”[EB/OL].https://mp.weixin.qq.com/s/JYyCI49hDV3KalPButaoRg

[31]Tuomela M,Hofmann S.Simulating Rational Social Normative Trust,Predictive Trust,and PredictiveReliance between Agents[J].Ethics and Information Technology,2003,5(3):163-176.

[32]McDermid,etal,2021年“Artificial intelligence explainability:the technical and ethical dimensions

[33]https://blog.research.google/2024/01/introducing-aspire-for-selective.html

[34]Fukuyama F.Trust:The social virtues and the creation of prosperity[M].Simon and Schuster,1996.

[35]王俊美.人工智能获得信任的前提是监管到位[EB/OL].https://www.cssn.cn/skgz/202303/t20230306_5601306.shtml

[36]Hoffman,Robert R.,et al."Metrics for explainable AI:Challenges and prospects."arXiv preprint arXiv:1812.04608(2018).

[37]Akula A R,Wang K,Liu C,et al.CX-ToM:Counterfactual explanations with theory-of-mind for enhancing human trust in image recognition models[J].Iscience,2022,25(1).

相关推荐

如何解决大模型的信任问题?

AI大模型,如何保持人类价值观?

AI大模型如何重塑汽车后市场?

未来三年闲鱼要在20城开店 通过“线下”解决信任问题

最后一公里不解决,大模型开闭源都一文不值

中国AI大模型,应该如何商业化?

AI也有偏见,我们该如何信任它们?

8家国产大模型,内容真实性如何?

打包提供零信任产品,「赛赋科技」想帮企业解决云时代的安全管理问题

李想的数字化理想:解决企业发展中的“人性”问题

网址: 如何解决大模型的信任问题? http://m.xishuta.com/newsview122400.html