对标英伟达Blackwell,华为达芬奇的压力好大!

在信息爆炸的AI时代,数据洪流如同奔涌的江河,急需强大的动力引擎来驱动其潜能。而GPU,这个曾被视为图形渲染领域的专属硬件,如今已华丽变身,成为AI时代的强大引擎。它们不再是简单的图像处理单元,而是智能计算的加速器,为AI的飞速发展提供了澎湃动力。

GPU芯片架构的演进,是这股动力的关键所在。架构,就像GPU的DNA,决定了GPU的性能、效率和应用范围。从早期的简单图形处理,到如今的AI大模型训练和推理,每一次架构的迭代,都是对GPU潜能的深度挖掘。架构的创新,让GPU在AI时代焕发了新的生命力。

GPU芯片架构的设计,涉及到核心数量、内存带宽、能源消耗等多个方面。一个优秀的GPU架构,能够实现高性能计算的同时,保持较低的能耗,满足AI时代对计算效率的苛刻要求。

英伟达的GPU,之所以能够取得如今的垄断地位,其芯片架构的创新居功至伟。那么,英伟达芯片架构是怎么一步步发展迭代的,华为的达芬奇能不能追得上,有没有后发优势?接下来,我们尝试就这个问题来进行探讨。

从GeForce到Blackwell,英伟达是如何一步步走到今天的?

在半导体行业的舞台上,英伟达以其GPU芯片架构的创新,一直走在GPU技术浪潮的前沿。接下来,我们来看看,从GeForce到Hopper,英伟达是如何一步步铸就其在高性能计算领域的领导地位的。

英伟达的起步与GeForce系列的诞生密切相关,1999年,GeForce 256以其硬件T&L技术,为3D图形处理设定了新的行业标准。随后,英伟达推出了Tesla系列,这一转变不仅是产品线的扩展,更是战略方向的调整。Tesla GPUs在高性能计算领域崭露头角,其应用案例包括著名的"折叠@home"项目,该项目利用分布式计算能力研究蛋白质的折叠过程。

Fermi的洪荒之力

2010年,英伟达的Fermi架构GPU,GTX 480,以其512个CUDA核心和惊人的3亿晶体管数量,将GPU的计算能力推向了一个新的高度。Fermi架构的推出,不仅是晶体管数量的增加,更重要的是CUDA技术的发展,它为GPU通用计算提供了强大的支持,开启了GPU并行计算的新纪元。

Kepler的能效之舞

2012年,Kepler架构的GTX 680问世,它在每瓦性能上实现了显著提升。Kepler架构通过动态调整核心频率和电压,实现了性能与功耗的平衡。这一架构的能效优化,使得GPU在数据中心等环境中得到了广泛应用,例如在亚马逊AWS的EC2计算实例中,就采用了基于Kepler架构的GPU。

Maxwell的智能调度创新

2014年,Maxwell架构的GTX 980发布,它在每瓦性能上比前代产品提升了20%。Maxwell架构的智能调度技术,通过优化内存访问和执行效率,进一步提升了GPU的性能。Maxwell架构的GPU在AI边缘计算领域也有所作为,例如在自动驾驶汽车的传感器数据处理中。

Pascal对深度学习的全面拥抱

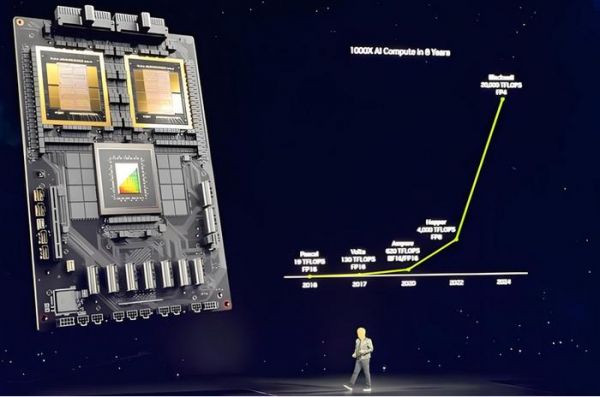

2016年,Pascal架构的Tesla P100 GPU问世,它采用了16nm FinFET工艺,拥有高达3584个CUDA核心。Pascal架构的推出,标志着英伟达全面拥抱深度学习。P100 GPU在AI研究和应用开发中被广泛应用,例如在谷歌的DeepMind项目中,P100 GPU就发挥了关键作用。

Volta引入了Tensor Core

2017年,Volta架构的Tesla V100 GPU发布,它引入了Tensor Core,专门为深度学习训练和推理优化。V100的发布,使得AI训练的速度比前代产品快了数倍。V100 GPU在多个领域取得了显著成就,包括在斯坦福大学的研究中,V100 GPU加速了蛋白质结构预测的计算过程。

Turing引入了实时光线追踪技术

2018年,Turing架构的RTX 2080 Ti显卡问世,它引入了实时光线追踪技术,为游戏和电影渲染带来了革命性的变化。Turing架构的推出,不仅提升了图形渲染的质量,也为3D建模和可视化提供了强大的支持。在电影《复仇者联盟4:终局之战》的制作中,Turing GPU就发挥了重要作用。

Ampere,A100的核心

2020年,Ampere架构的A100 GPU发布,它采用了7nm工艺,拥有6912个CUDA核心和432个Tensor Core。A100在AI训练和推理性能上,相比前代产品提升了20倍,进一步巩固了英伟达在AI和HPC领域的领导地位。A100 GPU在多个高性能计算项目中取得了突破,包括在橡树岭国家实验室的Frontier超级计算机中,A100 GPU为模拟核聚变反应提供了关键计算能力。

Hopper的内存架构创新

2022年,Hopper架构的GPU发布,它在性能和效率上再次实现了飞跃,引入了新一代的Tensor Core和更高效的内存架构。Hopper的推出,标志着英伟达在AI芯片领域的最新进展。Hopper GPU在AI领域的应用前景广阔,预计将在自然语言处理、图像识别等多个领域取得突破。

Blackwell,专为AI大模型而生,采用第二代Transformer引擎

进入2024年,英伟达的Blackwell架构代表了该公司在GPU芯片设计上的最新进展。作为继Hopper架构之后的新一代产品,Blackwell带来了一系列重大的性能提升和技术革新。Blackwell GPU专为应对AI时代对计算能力的巨大需求而设计,特别是在处理万亿参数规模的AI模型方面。

Blackwell架构的GPU采用了双芯片配置,通过高带宽接口(NV-HBI)实现两个GPU芯片的高效互联,支持高达10TB/s的带宽。这种设计显著提升了整体性能,同时保持了良好的能效比。Blackwell GPU还配备了高达192GB的HBM3e内存和超过8TB/s的内存带宽,为处理大规模AI模型提供了充足的内存容量和带宽。

在AI训练和推理性能方面,Blackwell GPU相较Hopper架构的GPU实现了显著提升。其训练性能是Hopper GPU的4倍,推理性能更是高达30倍。这种性能的飞跃得益于Blackwell GPU采用的第二代Transformer引擎和定制的Tensor Core技术,这些创新为大型语言模型(LLM)和专家混合模型(MoE)的推理过程带来了显著加速。

此外,Blackwell架构还引入了第五代NVLink技术,为GPU之间的高速互联提供了支持。这使得Blackwell GPU能够支持多达576个GPU的集群,为构建超大规模AI系统提供了可能。

英伟达的GPU芯片架构演进,是一段由技术创新驱动的历史。每一次架构的更新,都伴随着性能的大幅提升和能效的优化。从Fermi的诞生到Hopper的最新进展,英伟达不断突破技术极限,推动着整个行业的发展。这不仅是技术的胜利,更是对未来计算模式的探索。

英伟达GPU架构的未来发展方向,将继续围绕性能提升、能效优化和技术创新展开。随着AI技术的不断进步和应用场景的不断扩展,英伟达的GPU架构将继续向着更高的计算效率、更强的AI处理能力和更优的图形渲染性能方向发展。同时,英伟达也在积极布局云计算和边缘计算,通过DGX Cloud等云服务,为AI研究和应用提供了灵活、高效的计算资源。

在AI计算的长远布局上,英伟达不仅关注GPU架构的优化,还着眼于整个AI生态系统的建设。通过CUDA和其他软件开发工具,英伟达为开发者提供了强大的支持,推动了AI技术的发展和应用。此外,英伟达还与科技巨头如苹果合作,共同推动AI和机器人技术的革新,展现了其在AI领域的深远影响力和领导地位。随着技术的不断进步和市场需求的不断扩大,英伟达的GPU架构将继续引领AI计算的未来。

华为达芬奇,一个来自中国的对手

在AI芯片架构领域,英伟达有一个来自中国的对手——华为达芬奇。

华为达芬奇架构作为华为自研的AI计算架构,虽然相较于业界其他一些架构起步较晚,但已经展现出了强大的竞争力和创新能力。

接下来,让我们简要回顾一下华为达芬奇的关键发展节点:

1. 2018年:华为首次公开提出达芬奇架构,并推出基于此架构的AI芯片Ascend 310(昇腾310)。这是达芬奇架构的首次亮相,标志着华为正式进入AI芯片领域。

2. 2019年6月:华为发布麒麟810芯片,这是首款采用达芬奇架构NPU的智能手机SoC芯片。麒麟810的AI性能在当时的AI Benchmark榜单中表现卓越,证明了达芬奇架构的实力。

3. 2019年8月:华为发布AI芯片Ascend 910,这是一款面向云端AI训练和推理的高性能AI处理器。Ascend 910的发布,进一步丰富了华为AI芯片的产品线。

4. 2020年:华为继续推进达芬奇架构的发展,推出了Ascend 系列的其他产品,包括Ascend-Nano、Ascend-Tiny、Ascend-Lite、Ascend-Mini和Multi-Ascend 310等,覆盖了从端侧到云端的全场景AI应用。

5. 2023年:华为算力GPU的出货量显著增长,预计到2024年将达到几十万片的规模,这表明华为达芬奇架构的AI芯片在市场上已经取得了一定的认可和应用。

尽管华为达芬奇架构起步较晚,但其发展速度和技术创新能力不容小觑。

华为达芬奇架构之所以能在AI芯片领域异军突起,其核心竞争力在于创新的3D Cube计算引擎。这一引擎专门针对AI计算中最为关键的矩阵运算进行优化,通过三维立体的计算模式,实现了数据并行处理的质的飞跃。在3D Cube的加持下,每个AI Core在一个时钟周期内能够执行高达4096个MAC(乘-累加)操作,这样的算力密度在传统CPU和GPU中是难以想象的。

这种设计不仅提升了算力,更在单位功耗下实现了AI算力的显著提升,这对于功耗敏感的移动设备和需要大规模部署的云端服务器来说,具有极其重要的意义。在AI芯片的战场上,能效比往往决定了一款产品的生死,而达芬奇架构在这方面的表现无疑给了华为一些底气。

除了3D Cube,达芬奇架构的另一个亮点是其集成的多种计算单元,包括向量、标量以及硬件加速器等。这些单元的协同工作,使得达芬奇架构能够灵活处理各种复杂的AI计算任务,从基础的数学运算到复杂的深度学习算法,都能游刃有余。这种灵活性和扩展性,让达芬奇架构能够适应多变的AI应用场景,无论是端侧的智能设备还是云端的大规模计算任务,都能提供强大的支持。

此外,达芬奇架构对多种精度计算的支持,也是其一大优势。在AI训练和推理过程中,不同的任务对数据精度的要求各不相同,达芬奇架构能够根据任务需求灵活调整,既保证了计算的准确性,又避免了资源的浪费,实现了效率和效果的最优平衡。

当然,虽然华为达芬奇在诸多方面作出了自己的特色,但面对强大的英伟达,依然显得弱小。

GPU芯片架构还远没有到“完全体”

GPU芯片架构的演进是一场永无止境的技术革新之旅,尽管已经取得了显著的进步,但袁还没达到至善至美的"完全体"形态。那么,芯片架构演进的方向是什么呢?以下是GPU芯片架构发展中值得关注的几个方向:

1. 统一架构(One Architecture):GPU架构正朝着能够在不同计算环境中提供一致性能和功能的方向发展。这意味着,无论是在数据中心的大型服务器,还是在边缘设备上,同一款GPU架构都应具备高效的执行能力。例如,英伟达的Ampere架构就被设计为能够同时支持x86和Arm架构,这使得GPU能够跨平台工作,简化了开发流程并扩大了应用范围。

2. 训练与推理融合:AI芯片的设计越来越注重同时支持训练和推理任务。传统上,训练和推理需要不同类型的硬件优化,但随着技术的进步,正在实现在同一硬件上对两者的高效支持。推理功能的优化特别关键,因为它直接关系到AI模型在实际应用中的响应速度和能效比。

3. 内存容量的增长:随着AI模型的规模和复杂性不断增加,对内存容量的需求也在急剧上升。HBM技术通过3D堆叠多个DRAM层来提供更高的内存密度和带宽。预计到2025年,HBM技术将达到前所未有的容量和带宽水平,这将极大地推动AI芯片的性能提升。

4. 软硬件协同优化:软硬件的紧密结合是实现GPU最佳性能的关键,英伟达的CUDA平台和其GPU硬件之间的协同就是一个典型例子。软件层面的优化可以充分发挥硬件的潜力,而硬件设计时也需要考虑软件的执行效率。

5. 更强的互联技术:GPU之间以及计算节点之间的高速互联,对于构建大规模计算集群至关重要。例如,英伟达的NVLink技术提供了单个节点内GPU间高达数百GB/s的互连带宽,而InfiniBand技术则广泛用于节点之间的高速通信,这对于实现高效的并行计算和数据共享至关重要。

6. 先进封装技术:随着芯片尺寸的缩小和集成度的提高,传统的封装技术已经不能满足需求。先进封装技术,如Chiplet,允许在单个封装内集成多个小芯片,从而实现更高的性能和更低的功耗。预计到2025年,这种技术将在AI芯片中得到广泛应用。

7. 系统级创新:真正的创新来自于对整个系统每一个环节的深入理解和优化,从芯片设计、制造工艺、内存技术到软件工具和开发环境,每一个环节都需要不断创新,以实现整体性能的最优。

8. 快速迭代与性能提升:AI芯片的更新周期正在缩短,以适应快速发展的市场需求。每一代新芯片都在存储、计算和互联方面实现了显著的性能提升,通常比上一代提升1.5到2倍以上。

对于华为来说,要想在AI芯片架构上追赶英伟达,就需要在上述方面发力。华为需要不断优化达芬奇架构,提高其在统一架构下的性能和能效,加强内存和互联技术的研发,以及构建更加完善的软硬件生态系统。通过系统性的创新和快速迭代,才有望逐步缩小与行业领导者的差距,并在未来的AI芯片竞争中占据一席之地。

文:一蓑烟雨 / 数据猿责编:凝视深空 / 数据猿

发布于:北京

相关推荐

对标英伟达Blackwell,华为达芬奇的压力好大!

华为达芬奇与英伟达CUDA,必有一战!

英伟达Blackwell架构:数据中心霸主GB100或提前问世

英伟达Blackwell GPU供不应求,追单效应已蔓延至封测厂

功耗要超 1000W!英伟达新一代架构 Blackwell 来了:RTX 50、B200 都要用

英伟达的GPU已经讲不出“花儿”了

英伟达超越苹果指日可待

英伟达黄仁勋称下一场工业革命已经开始

英伟达带来最强AI芯片,但赶超苹果又远了一步?

黄仁勋宣布大动作!“最强AI芯片”或将推动英伟达业绩和股价再创新高

网址: 对标英伟达Blackwell,华为达芬奇的压力好大! http://m.xishuta.com/newsview121177.html