英伟达发布GB200:2080亿晶体管,号称史上最强AI芯片!

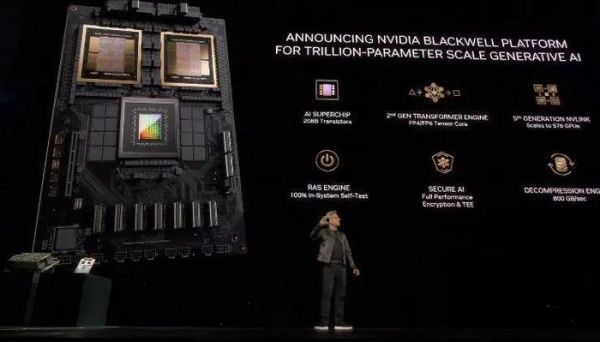

3月19日消息,在昨晚的GTC开发者大会上,NVIDIA正式推出了面向人工智能模型的新一代Blackwell GPU架构,以及基于此架构的新一代AI加速卡——GB200。NVIDIA的CEO黄仁勋指出:“Blackwell并非仅是一款芯片,而是一个平台”。

(图源:GTC 2024)

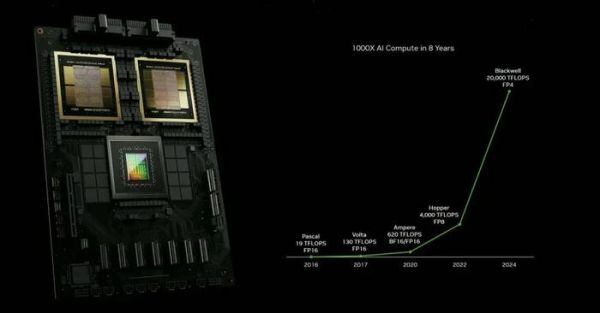

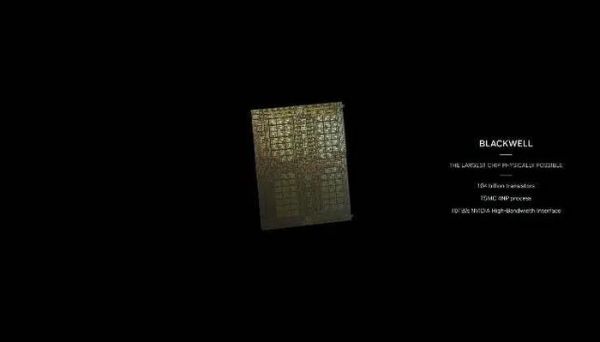

(图源:GTC 2024)也就是说,GB200实际上由两个Blackwell B200 GPU和一个Grace CPU组成的AI加速平台。据悉,每个B200 GPU含有2080亿个晶体管。相较于H100,GB200的算力提升了6倍,而在处理多模态特定领域任务时,其算力更是能达到H100的30倍。

(图源:GTC 2024)

(图源:GTC 2024)算力的提升虽然重要,但并非这次芯片更新的重头戏。相比之下,更关键的是能耗和成本的大幅降低。上一代的H100 AI加速卡峰值功率高达700瓦,而训练一个1.8万亿参数模型需要8000个Hopper GPU和15兆瓦的电力。

与H100相比,新一代的GB200 AI加速卡仅需原来25分之一的成本和能耗,即用2000个Blackwell GPU就能完成相同的任务,且功耗只有4兆瓦。

简单来说,GB200的性能是H100的7倍,而成本和能耗更低。

(图源:GTC 2024)

(图源:GTC 2024)此前便有专家预测,随着大量H100的部署,其总功耗将与一座美国大城市不相上下,甚至超过一些欧洲小国。而GB200这一巨大的性能提升和能效改进,意味着数据中心和AI应用将能以更低的成本运行更加复杂和要求高的计算任务,从而加速AI技术的发展和应用。

诚然,从十多年前的智能手机,到现如今的AI,随着科技在这十年间飞速发展,AI也迎来了爆发式的增长,随之而来的就是所需算力越来越高。而目前NVIDIA在AI领域的进度已经甩掉同行一大截了,GB200的推出也很可能促使其他公司加快开发和推出自己的高性能AI加速卡,从而激化市场竞争。

(图源:GTC 2024)

(图源:GTC 2024)加上英伟达还推出名为NIM的创新软件和一个用于制造类人机器人的硬件和软件平台,这将进一步使部署人工智能变得更容易,为客户在竞争日益激烈的领域中坚持使用英伟达芯片提供了又一个理由。

(图源:GTC 2024)

(图源:GTC 2024)长期来看,这将促进技术创新,为用户带来更多、更好的选择,同时推动整个行业向前发展。

总而言之,GB200与前代产品之间的显著性能差异可能会促使数据中心和企业客户更新他们的硬件,以利用新技术带来的优势。这也意味着,在需要处理大量数据和复杂计算的领域,AI技术在各行各业的应用将进一步加速。

发布于:广东

相关推荐

英伟达发布GB200:2080亿晶体管,号称史上最强AI芯片!

英伟达,再次展示了自己对于AI的“主权”

英伟达官宣全球最强AI芯片:性能提升 30 倍,并将重新设计整个底层软件堆栈

最大碳纳米管芯片、最大 AI芯片相继发布,芯片行业要变天了?

史上最大芯片诞生:1.2万亿晶体管超级巨无霸,专为AI设计

英伟达芯片,最新路线图

结盟三星美光,英伟达发布性价比更高的新一代消费级GPU

焦点分析 | 英伟达推出“算力怪兽” A100 , 国产云端AI芯片们如何破局

AMD发起AI芯片挑战,但英伟达依然独孤求败

最强AI芯片H200?黄仁勋又在挤牙膏了

网址: 英伟达发布GB200:2080亿晶体管,号称史上最强AI芯片! http://m.xishuta.com/newsview112241.html